2024-03-04

分类:新视野

阅读(1519) 评论(0)

近期,[OpenAI Translator](https://github.com/openai-translator/openai-translator) 和 [NextChat](https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web) 相继支持了 Ollama 本地运行的[大型语言模型](/what-are-llm/),这对「新手上路」的爱好者来说,又多了一种新玩法。

而且 Ollama on Windows(预览版)的推出,完全颠覆了在 Windows 设备上进行 AI 开发的方式,它为 AI 领域的探索者和普通的「试水玩家」指引了一条明确的道路。

什么是 Ollama? {#0-%E4%BB%80%E4%B9%88%E6%98%AF-ollama%EF%BC%9F}

------------------------------------------------------------

Ollama 是一款开创性的人工智能(AI)和机器学习(ML)工具平台,它极大地简化了 AI 模型的开发和使用过程。

在技术社区里,AI 模型的硬件配置和环境搭建一直是个棘手的问题,而 Ollama 正是为了解决这样的关键需求而出现的:

* 它不仅提供了一系列工具,更重要的是,这些工具使用起来非常直观且高效,不管你是 AI 领域的专业人士还是初涉此道的新手,都能在 Ollama 上找到对应的支持。

* 不止于方便使用,Ollama 还让先进的 AI 模型和计算资源的获取不再局限于少数人。对于 AI 和 ML 社区而言,Ollama 的诞生具有里程碑意义,它推动了 AI 技术的普及,让更多的人能够去尝试和实践自己的 AI 创意。

为什么 Ollama 能够脱颖而出? {#1-%E4%B8%BA%E4%BB%80%E4%B9%88-ollama-%E8%83%BD%E5%A4%9F%E8%84%B1%E9%A2%96%E8%80%8C%E5%87%BA%EF%BC%9F}

--------------------------------------------------------------------------------------------------------------------------

在众多 AI 工具中,Ollama 凭借以下几个关键优势脱颖而出,这些特性不仅彰显了其独特性,更解决了 AI 开发者和爱好者们最常遇到的难题:

* **自动硬件加速**:Ollama 能自动识别并充分利用 Windows 系统中的最优硬件资源。无论你是配备了 NVIDIA GPU,还是 CPU 支持 AVX、AVX2 这样先进的指令集,Ollama 都能实现针对性优化,确保 AI 模型更加高效地运行。有了它,就不用再头疼于复杂的硬件配置问题了,你可以将更多的时间和精力都集中在项目本身。

* **无需虚拟化**:在进行 AI 开发时,以往常常需要搭建虚拟机或配置复杂的软件环境。而 Ollama 让这一切都不再成为阻碍,直接就能开始 AI 项目的开发,整个流程变得简单快捷。对于想尝试 AI 技术的个人或组织来说,这种便捷性降低了很多门槛。

* **接入完整的 Ollama 模型库** :Ollama 为用户提供了丰富的 [AI 模型库](https://www.sysgeek.cn/google-gemma-open-models/),包括像 [LLaVA 这样的先进图像识别模型](/google-gemma-open-models/)和 [Google 最新推出的 Gemma 模型](/google-gemma-open-models/)等。拥有这样一个全面的「武器库」,我们可以轻松尝试和应用各种开源模型,而不用自己费时费力地去搜寻整合。无论你想进行文本分析、图像处理,还是其他 AI 任务,Ollama 的模型库都能提供强有力的支持。

* **Ollama 的常驻 API**:在软件互联的今天,将 AI 功能整合到自己的应用中极具价值。Ollama 的常驻 API 大大简化了这一过程,它会在后台默默运行,随时准备将强大的 AI 功能与你的项目无缝对接,而无需额外的复杂设置。有了它,Ollama 丰富的 AI 能力会随时待命,能自然而然地融入你的开发流程,进一步提升工作效率。

Ollama 通过这些精心设计的功能特性,不仅解决了 AI 开发中的常见难题,还让更多的人能够轻松地接触和应用先进的 AI 技术,极大地扩展了 AI 的应用前景。

在 Windows 上使用 Ollama {#2-%E5%9C%A8-windows-%E4%B8%8A%E4%BD%BF%E7%94%A8-ollama}

------------------------------------------------------------------------------

欢迎迈入 AI 和 ML 的新时代!接下来,我们将带你完成上手的每一步,还会提供一些实用的代码和命令示例,确保你一路畅通。

### 步骤 1:下载和安装 {#3-%E6%AD%A5%E9%AA%A4-1%EF%BC%9A%E4%B8%8B%E8%BD%BD%E5%92%8C%E5%AE%89%E8%A3%85}

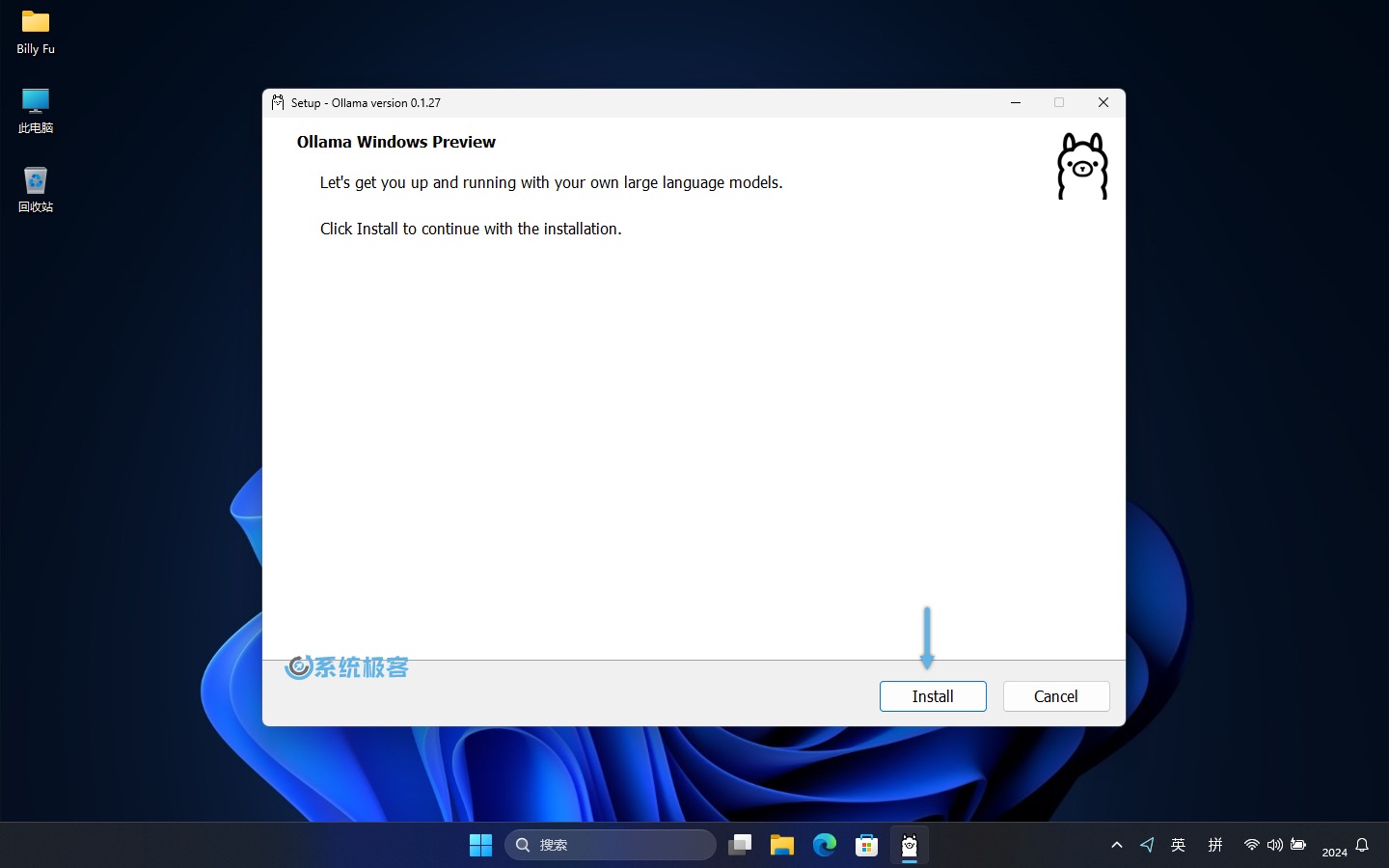

1访问 [Ollama Windows Preview](https://ollama.com/download/windows) 页面,下载`OllamaSetup.exe`安装程序。

2双击文件,点击「Install」开始安装。

在 Windows 中安装 Ollama

3安装完成之后,就可以开始在 Windows 上使用 Ollama 了,是不是非常简单。

### 步骤 2:启动 Ollama 并获取模型 {#4-%E6%AD%A5%E9%AA%A4-2%EF%BC%9A%E5%90%AF%E5%8A%A8-ollama-%E5%B9%B6%E8%8E%B7%E5%8F%96%E6%A8%A1%E5%9E%8B}

要启动 Ollama 并从模型库中获取开源 AI 模型,请按以下步骤操作:

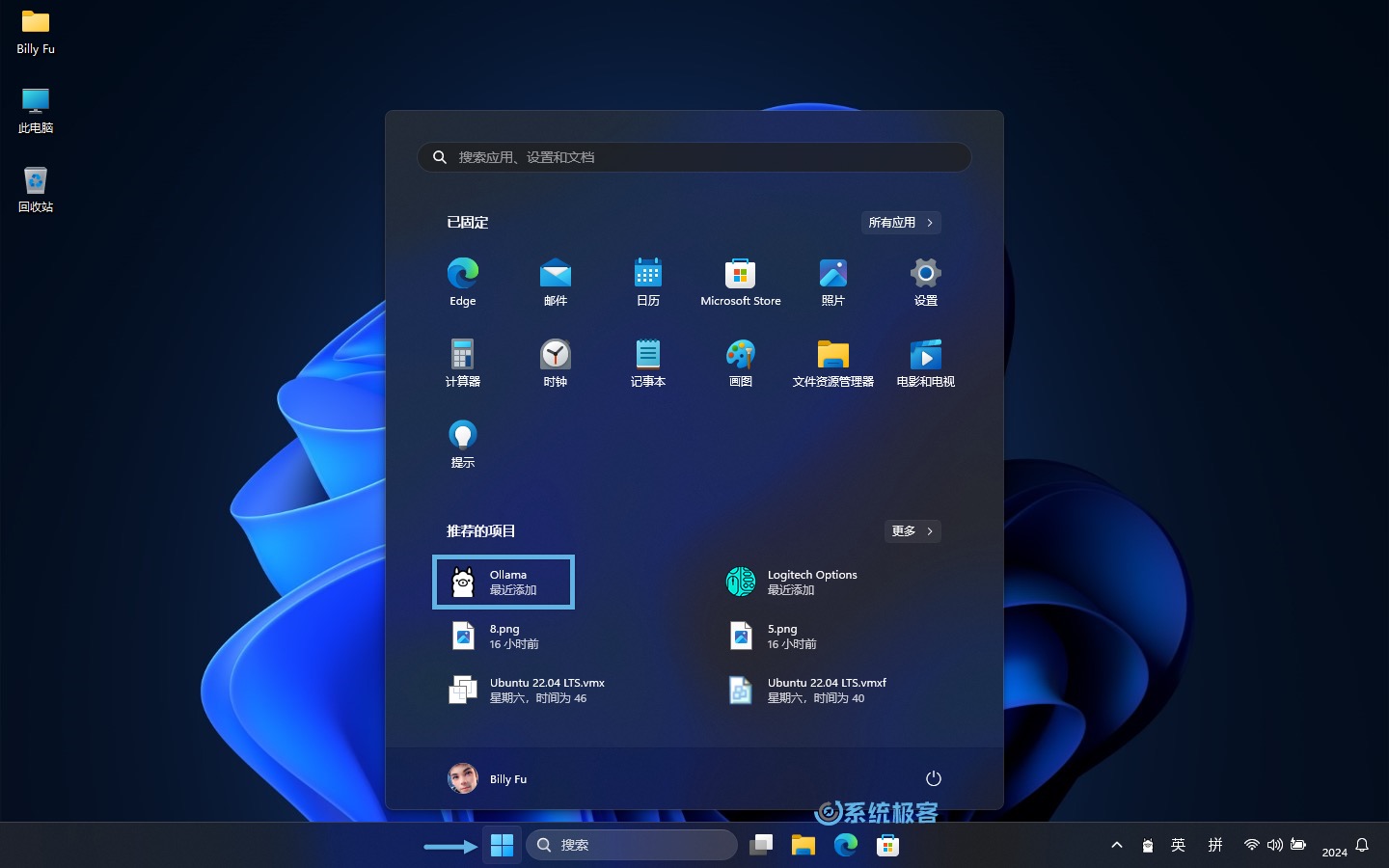

1在「开始」菜单中点击 Ollama 图标,运行后会在任务栏托盘中驻留一个图标。

从开始菜单中启动 Ollama

2右键点击任务栏图标,选择「View log」打开命令行窗口。

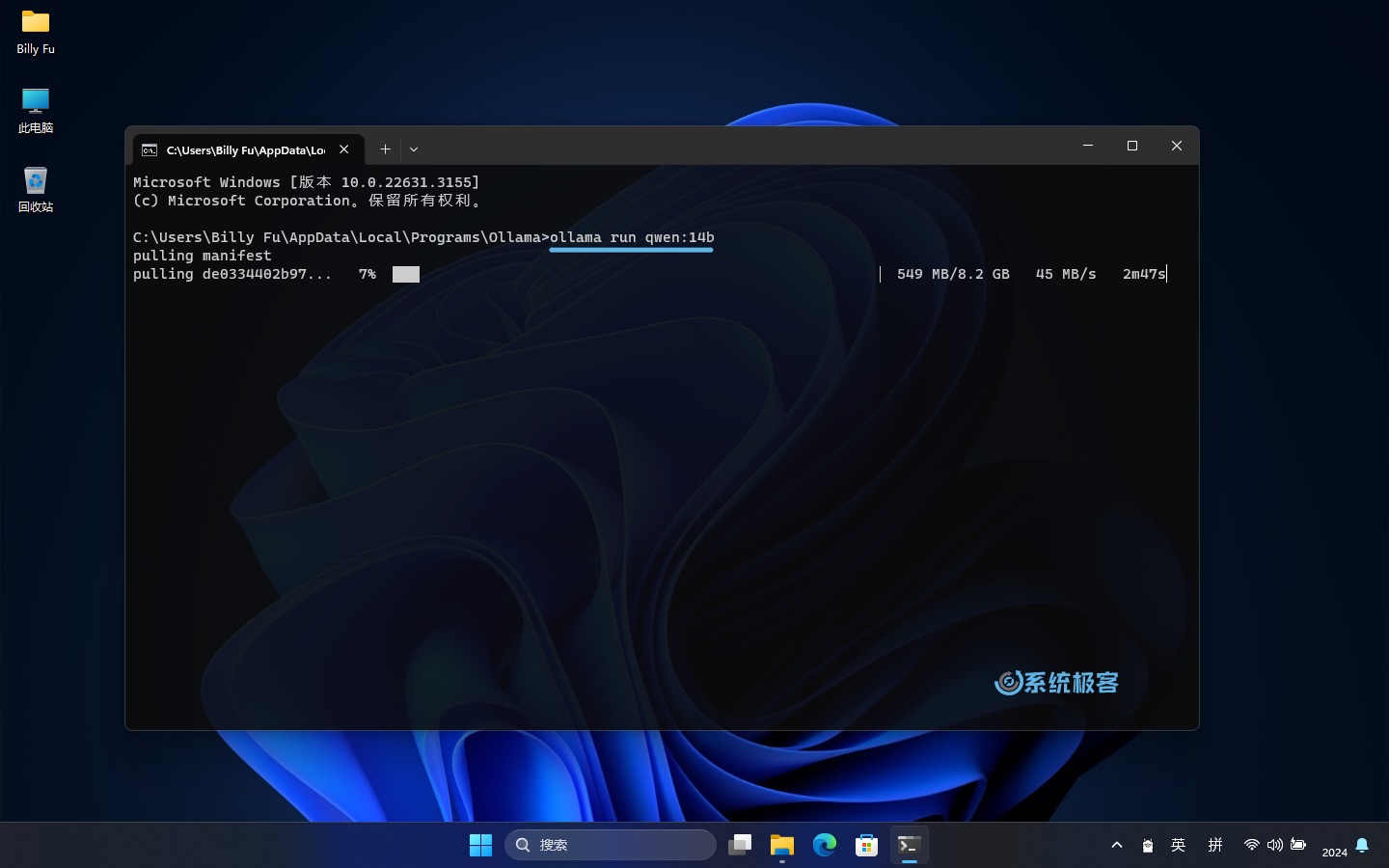

3执行以下命令来运行 Ollama,并加载模型:

```

ollama run [modelname]

```

运行 qwen:14b 模型

执行以上命令后,Ollama 将开始初始化,并自动从 [Ollama 模型库](https://ollama.com/library)中拉取并加载所选模型。一旦准备就绪,就可以向它发送指令,它会利用所选模型来进行理解和回应。

记得将`modelname`名称换成要运行的模型名称,常用的有:

\| 模型 \| 参数 \| 大小 \| 安装命令 \| 发布组织 \|

\|-------------\|------\|-------\|---------------------------\|--------------------------------------------------\|

\| Llama 2 \| 7B \| 3.8GB \| `ollama run llama2` \| Meta \|

\| Code Llama \| 7B \| 3.8GB \| `ollama run codellama` \| Meta \|

\| Llama 2 13B \| 13B \| 7.3GB \| `ollama run llama2:13b` \| Meta \|

\| Llama 2 70B \| 70B \| 39GB \| `ollama run llama2:70b` \| Meta \|

\| Mistral \| 7B \| 4.1GB \| `ollama run mistral` \| Mistral AI \|

\| mixtral \| 8x7b \| 26GB \| `ollama run mixtral:8x7b` \| Mistral AI \|

\| Phi-2 \| 2.7B \| 1.7GB \| `ollama run phi` \| Microsoft Research \|

\| LLaVA \| 7B \| 4.5GB \| `ollama run llava` \| Microsoft Research Columbia University Wisconsin \|

\| Gemma 2B \| 2B \| 1.4GB \| `ollama run gemma:2b` \| Google \|

\| Gemma 7B \| 7B \| 4.8GB \| `ollama run gemma:7b` \| Google \|

\| Qwen 4B \| 4B \| 2.3GB \| `ollama run qwen:4b` \| Alibaba \|

\| Qwen 7B \| 7B \| 4.5GB \| `ollama run qwen:7b` \| Alibaba \|

\| Qwen 14B \| 14B \| 8.2GB \| `ollama run qwen:14b` \| Alibaba \|

运行 7B 至少需要 8GB 内存,运行 13B 至少需要 16GB 内存。

### 步骤 3:使用模型 {#5-%E6%AD%A5%E9%AA%A4-3%EF%BC%9A%E4%BD%BF%E7%94%A8%E6%A8%A1%E5%9E%8B}

如前所述,Ollama 支持通过各种各样的开源模型来完成不同的任务,下面就来看看怎么使用。

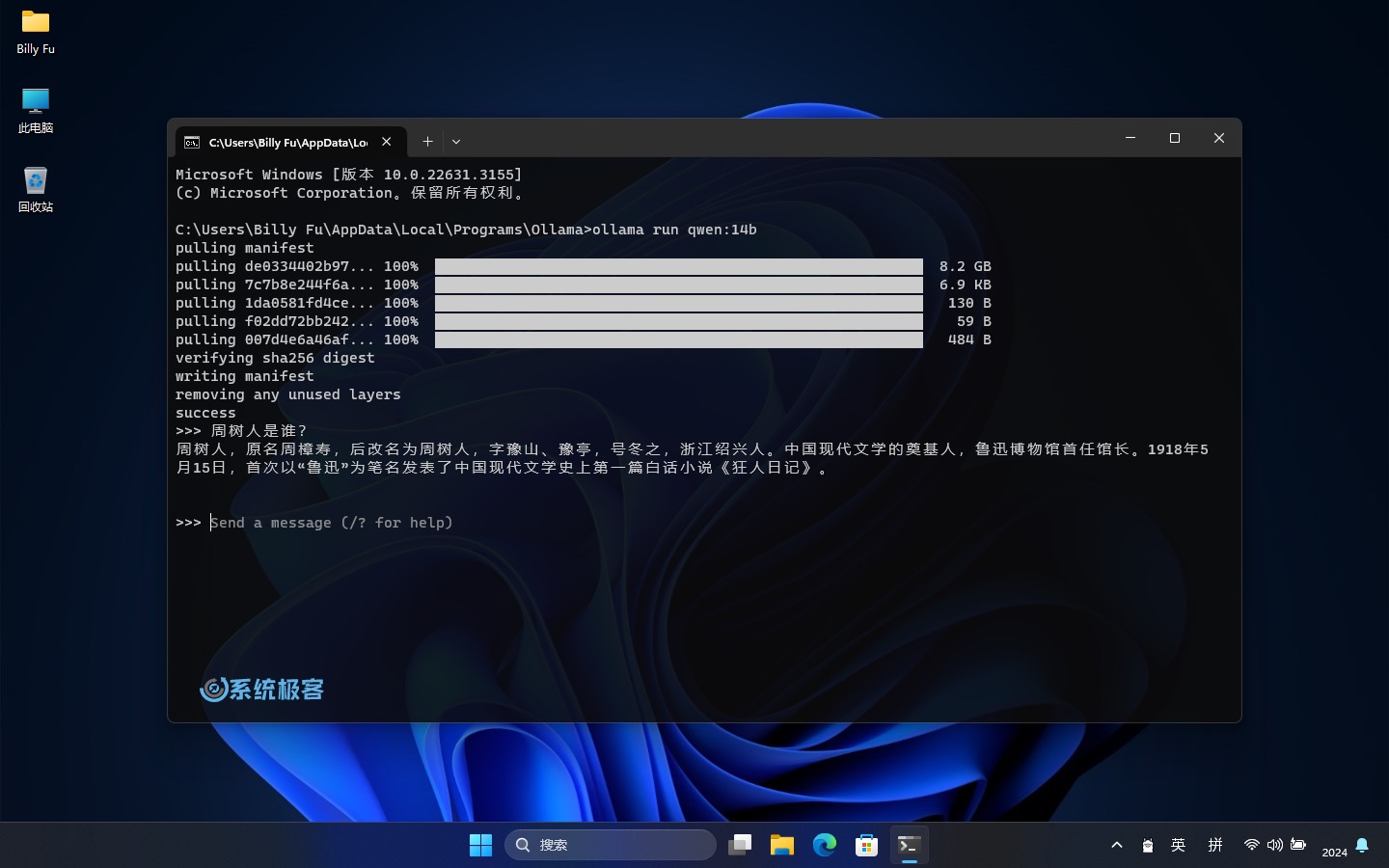

* **基于文本的模型**:加载好文本模型后,就可以直接在命令行里输入文字开始与模型「对话」。例如,阿里的 Qwen(通义千问):

输入文字开始与 qwen 模型对话

* **基于图像的模型**:如果你想使用图像处理模型,如 LLaVA 1.6,可以使用以下命令来加载该模型:

ollama run llava1.6

使用 llava 1.6 模型分析图片

Ollama 会使用你选择的模型来分析这张图片,并给你一些结果,比如图片的内容和分类,图片是否有修改,或者其他的分析等等(取决于所使用的模型)。

### 步骤 4:连接到 Ollama API {#6-%E6%AD%A5%E9%AA%A4-4%EF%BC%9A%E8%BF%9E%E6%8E%A5%E5%88%B0-ollama-api}

我们不可能只通过命令行来使用,将应用程序连接到 Ollama API 是一个非常重要的步骤。这样就可以把 AI 的功能整合到自己的软件里,或者在 [OpenAI Translator](https://github.com/openai-translator/openai-translator) 和 [NextChat](https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web) 这类的前端工具中进行调用。

以下是如何连接和使用 Ollama API 的步骤:

* **默认地址和端口** :Ollama API 的默认地址是`http://localhost:11434`,可以在安装 Ollama 的系统中直接调用。

* **修改 API 的侦听地址和端口**:如果要在网络中提供服务,可以修改 API 的侦听地址和端口。

1右击点击任务栏图标,选择「Quit Ollama」退出后台运行。

2使用`Windows + R`快捷键打开「运行」对话框,输出以下命令,然后按`Ctrl + Shift + Enter`以管理员权限启动「环境变量」。

```

C:\Windows\system32\rundll32.exe sysdm.cpl, EditEnvironmentVariables

```

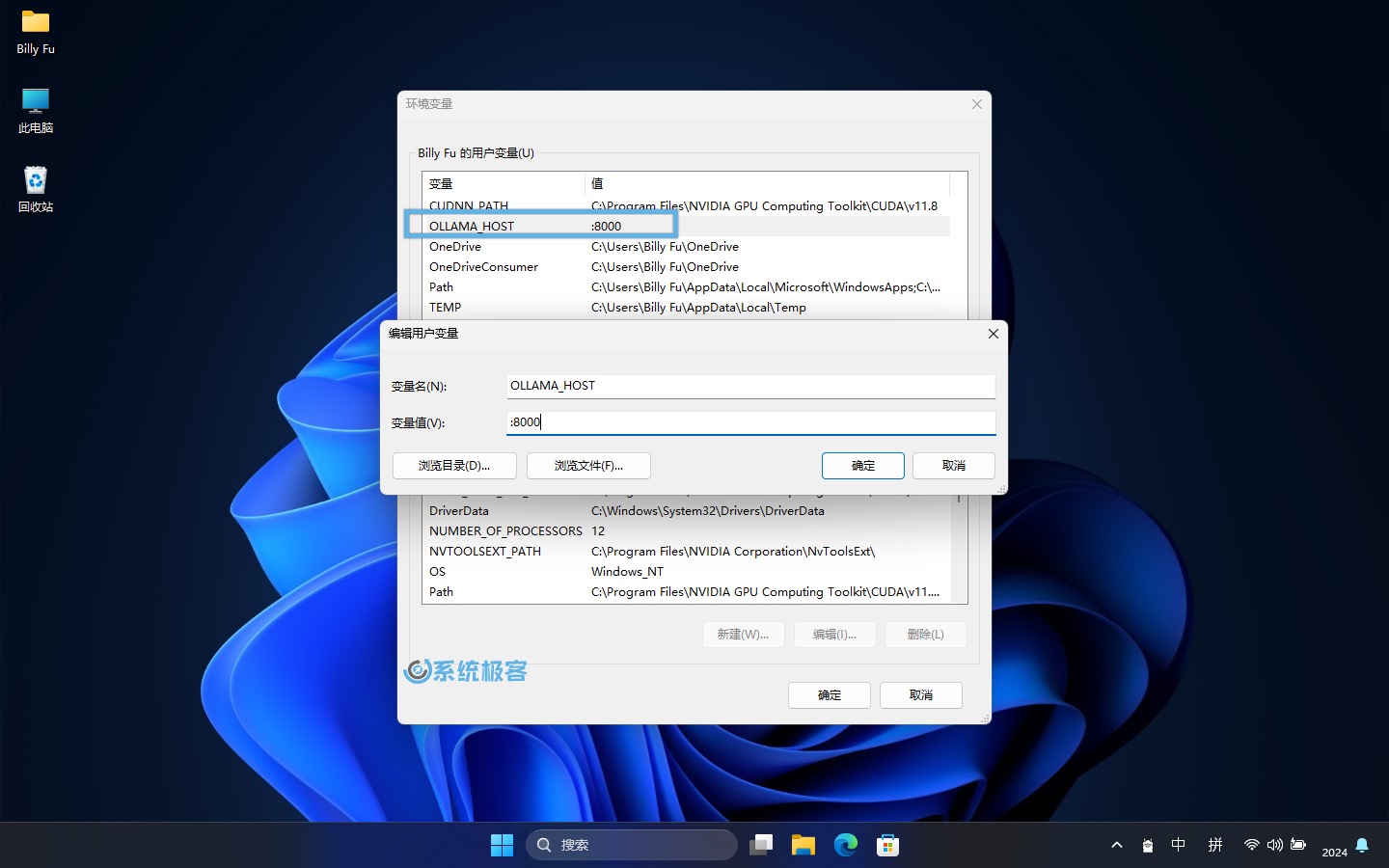

3要更改侦听地址和端口,可以添加以下环境变量:

* 变量名:`OLLAMA_HOST`

* 变量值(端口):`:8000`

指定 Ollama API 侦听地址和端口

只填写端口号可以同时侦听(所有) IPv4 和 IPv6 的`:8000`端口。

要使用 IPv6,需要 Ollama 0.0.20 或更新版本。{#ub-styled-box-notification-content-85ac14d7-8727-4f3a-adc7-4e1f461f01d2}

4如果安装了多个模型,可以通过`OLLAMA_MODELS`变量名来指定默认模型。

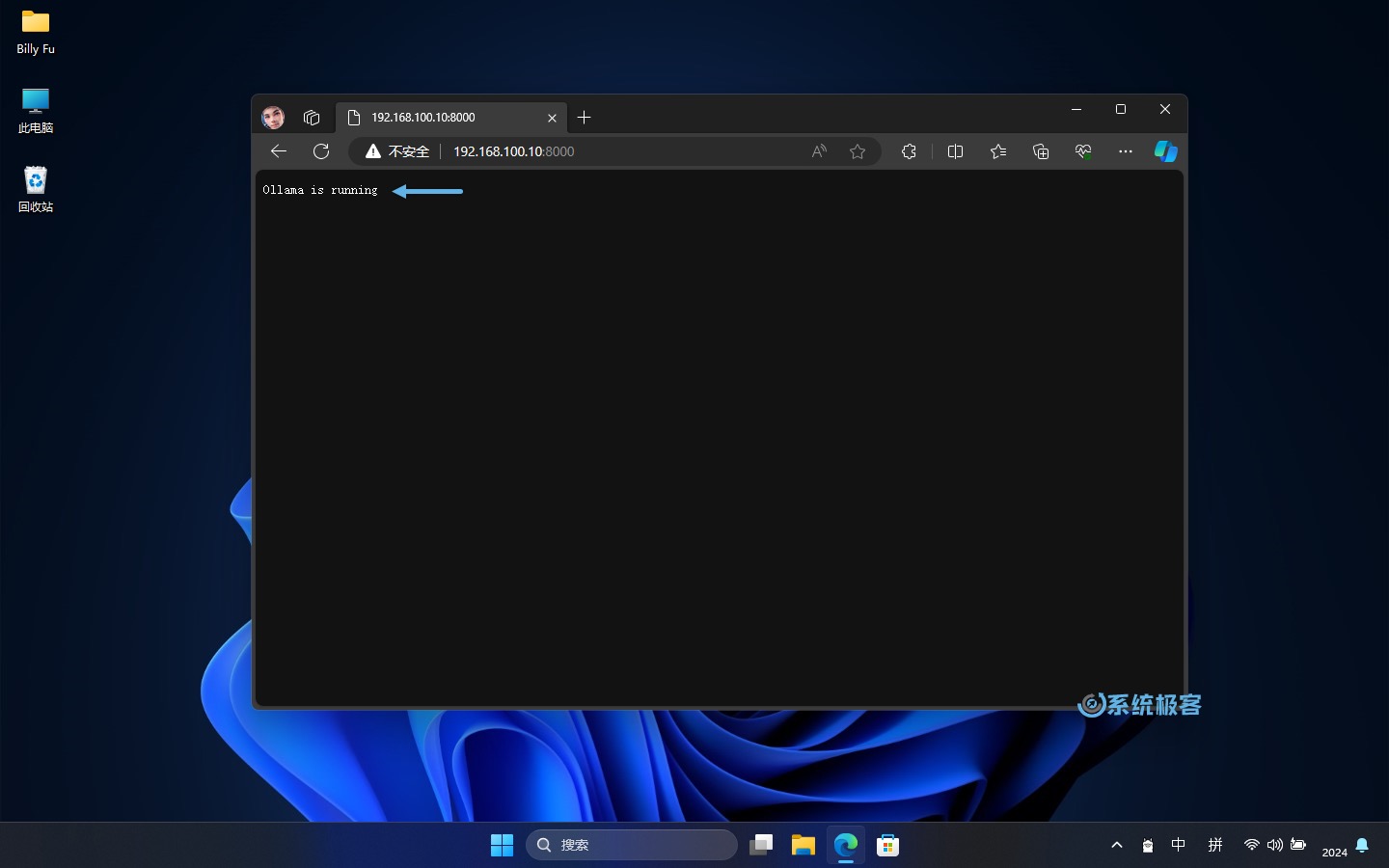

5更改完之后,重新运行 Ollama。然后在浏览器中测试访问,验证更改是否成功。

验证 API 工作状态

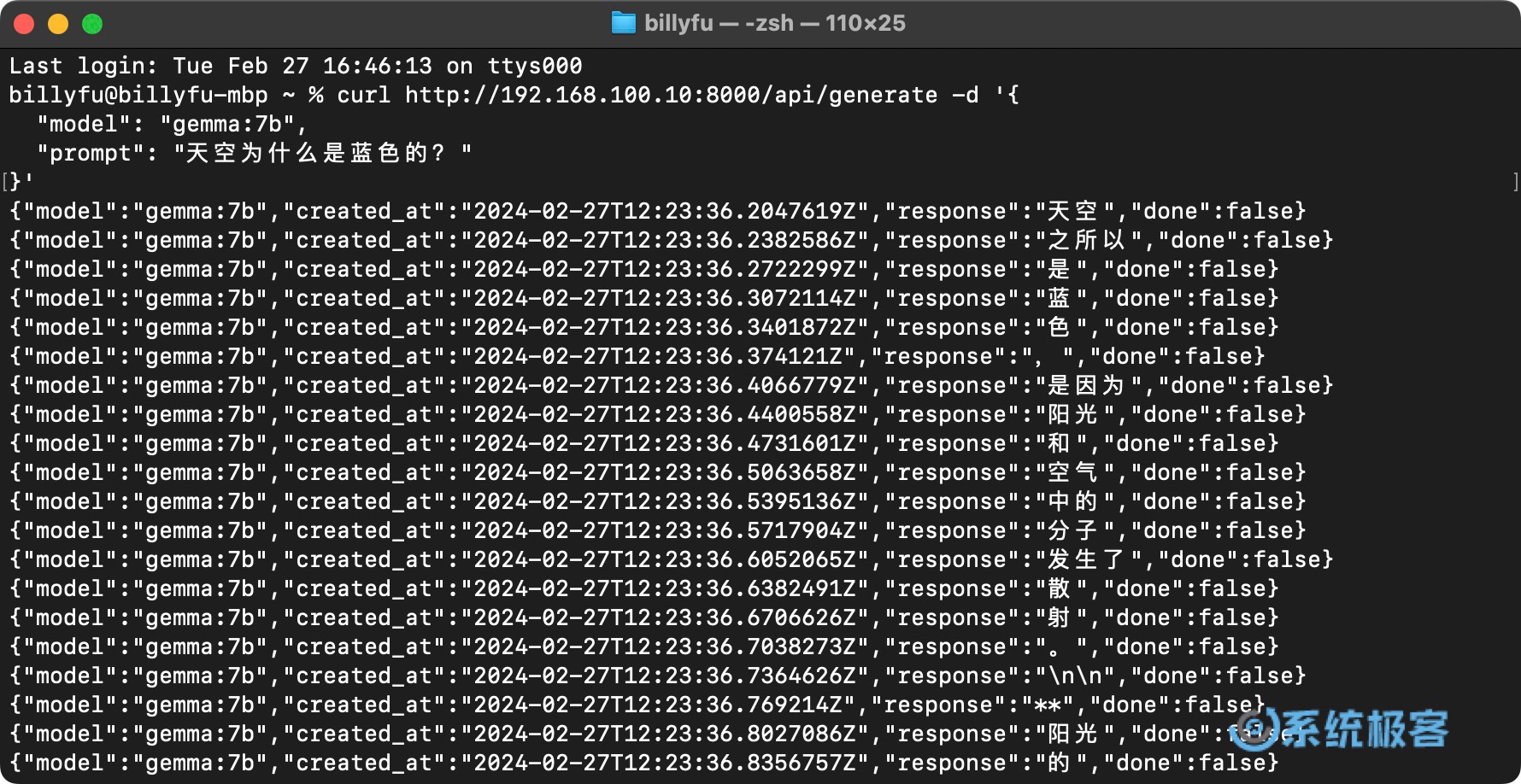

6示例 API 调用: 要使用 [Ollama API](https://github.com/ollama/ollama/blob/main/docs/api.md),可以在自己的程序里发送 HTTP 请求。下面是在「终端」里使用`curl`命令给 Gemma 模型发送文字提示的例子:

```

curl http://192.168.100.10:8000/api/generate -d '{

"model": "gemma:7b",

"prompt": "天空为什么是蓝色的?"

}'

```

Ollama API 调用示例

返回响应的格式,目前只支持 Json 格式。{#ub-styled-box-notification-content-61bc9c42-f6f4-462d-b049-5b62d6b40b15}

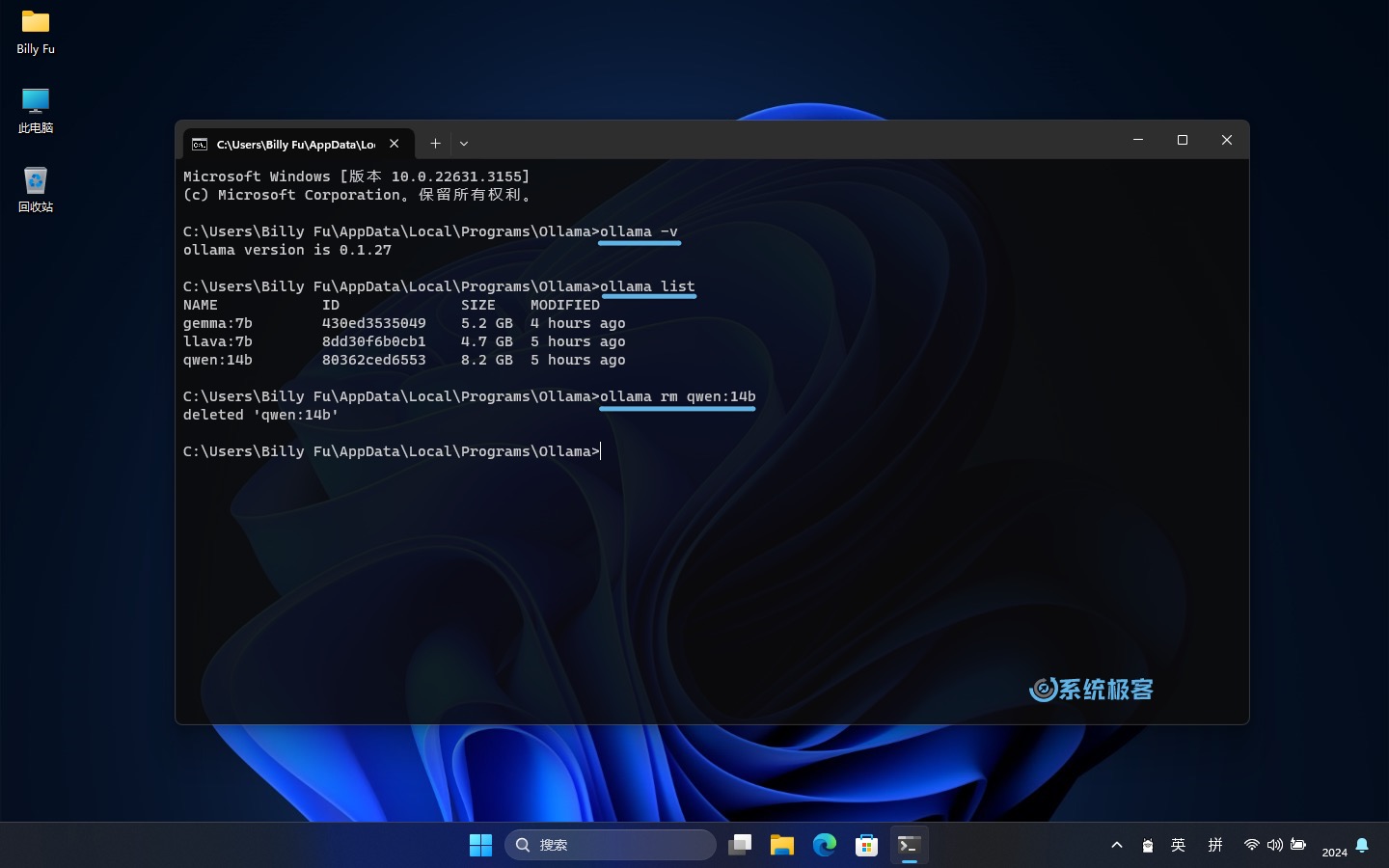

### Ollama 的常用命令有: {#7-ollama-%E7%9A%84%E5%B8%B8%E7%94%A8%E5%91%BD%E4%BB%A4%E6%9C%89%EF%BC%9A}

```

# 查看 Ollama 版本

ollama -v

# 查看已安装的模型

ollama list

# 删除指定模型

ollama rm [modelname]

# 模型存储路径

# C:\Users\\.ollama\models

```

Ollama 的常用命令

按照上述步骤,并参考命令示例,你可以在 Windows 上尽情体验 Ollama 的强大功能。不管是在命令行中直接下达指令,通过 API 将 AI 模型集成到你的软件当中,还是通过前端套壳,Ollama 的大门都已经为你敞开。

Ollama on Windows 的最佳实践 {#8-ollama-on-windows-%E7%9A%84%E6%9C%80%E4%BD%B3%E5%AE%9E%E8%B7%B5}

--------------------------------------------------------------------------------------------

要让 Ollama 在 Windows 上充分发挥最大潜力,需要注意以下几点最佳实践和技巧,这将帮助你优化性能并解决一些常见问题:

### 优化 Ollama 的性能: {#9-%E4%BC%98%E5%8C%96-ollama-%E7%9A%84%E6%80%A7%E8%83%BD%EF%BC%9A}

* **检查硬件配置**: 确保你的设备满足 Ollama 推荐的硬件要求,尤其是运行大型模型时。如果你有 NVIDIA GPU,还可以享受 Ollama 提供的自动硬件加速,大幅提升计算速度。

* **更新驱动程序**: 保持显卡驱动程序为最新版本,以确保与 Ollama 的兼容性和最佳性能。

* **释放系统资源**:运行大型模型或执行复杂任务时,请关闭不必要的程序,释放系统资源。

* **选择合适模型**:根据任务需求选择合适的模型。大参数模型虽然可能更准确,但对算力的要求也更高。对于简单任务,使用小参数模型更有效率。

### Ollama 常见问题解答 {#10-ollama-%E5%B8%B8%E8%A7%81%E9%97%AE%E9%A2%98%E8%A7%A3%E7%AD%94}

#### 安装问题

* 确保你的 Windows 系统是最新版本。

* 确保你拥有安装软件所需的权限。

* 尝试以管理员身份运行安装程序。

#### 模型加载错误

* 检查输入的命令是否正确。

* 确认模型名称与 Ollama 模型库中的名称相符。

* 检查 Ollama 版本并进行更新。

#### Ollama API 连接问题

* 确保 Ollama 正在运行。

* 检查侦听地址和端口,特别是端口是否被其他应用占用。

*** ** * ** ***

在本教程中,我们学习了如何在 Windows 上安装和使用 Ollama,包括安装 Ollama、执行基础命令、使用 Ollama 模型库,以及通过 API 连接 Ollama。建议你深入研究 Ollama,并尝试各种不同的模型。

Ollama 的潜力无限,借助它,你可以实现更多可能!

![]()

众生皆苦,唯有自渡!

51工具盒子

51工具盒子

51工具盒子

51工具盒子