" Magic-Me: Identity-Specific Video Customized Diffusion**"**

在文本到图像生成(T2I)领域,主题驱动的内容生成已经取得了巨大的进展,图像中的ID是可控的。然而,直接将其扩展到视频生成还没有得到很好的探索。

本文提出一种简单有效的主题身份可控的视频生成框架,称为视频自定义扩散(VCD)。VCD通过少量图像定义指定的主体ID,加强身份信息提取,并在初始化阶段注入帧间相关性,使稳定的视频输出在很大程度上保持身份。

尽管VCD很简单,但进行了广泛的实验,验证了VCD能够生成稳定和高质量的视频,在选定的强基线上具有明显更好的ID保持能力。此外,由于ID模块的可移植性,VCD也可以很好地与公开提供的经过微调的文本到图像模型一起工作,进一步提高了其可用性。

项目主页:https://magic-me-webpage.github.io/

论文地址:https://arxiv.org/abs/2402.09368

Github地址:https://github.com/Zhen-Dong/Magic-Me

摘要

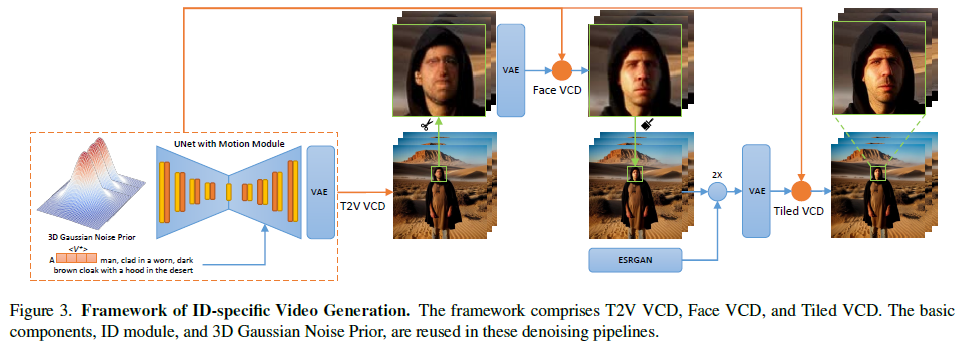

本文介绍了一种名为Video Custom Diffusion (VCD)的视频生成框架,可以通过几张图像定义主题身份,并在初始化阶段注入帧间相关性,以实现身份保留。该框架包括三个关键组件:身份模块、文本到视频模块和视频到视频模块。实验结果表明,VCD可以生成稳定且高质量的视频,并且可以与公开可用的文本到图像模型配合使用。

简介

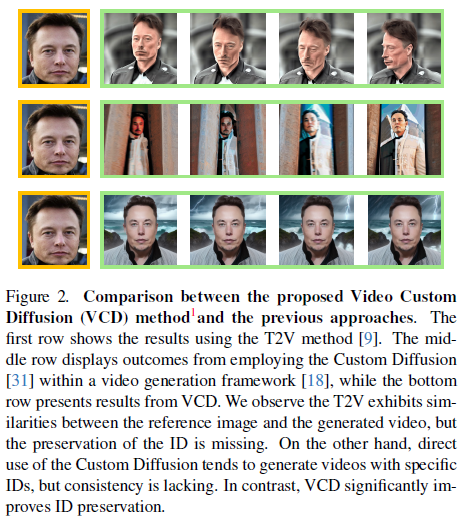

在视频生成中,特别是与人相关的场景中,控制对象身份仍然是一个挑战。图2中观察到的失败案例突出了两个基本问题。1)收集的参考图像具有不同的背景,捕捉了同一个人的表情、外观和环境的变化。这种多样性被印在唯一的ID令牌上。因此,在推理过程中,即使使用相同的ID令牌,生成的视频帧也可能显示不同的ID。虽然这在图像上下文中可能不会造成问题,但在视频生成中会出现问题。2)目前的视频生成框架依赖于预训练的运动模块来建立帧间一致性。当ID令牌以不同的信息独立初始化每个帧时,运动模块可能很难生成时间一致的视频帧。

在本文中,主要关注特定ID的自定义,其目标是在保持目标ID的同时,通过不同的运动和场景来实现目标身份的动画。

为解决第一个问题,本文提出一个ID模块,改进了学习到的ID令牌信息与主观ID的对齐。该模块将身份的特定特征学习到几个紧凑的文本标记嵌入中,即扩展ID标记,其使用的参数比SVDiff少约105倍(16KB vs 1.7MB)。

为解决第二个问题,本文提出一种新的3D高斯噪声先验来建立输入帧之间的相关性。它无需训练,并确保了推理阶段初始化的一致性。因此,尽管ID标记可能包含不同的信息,但在去噪过程中,所有帧都倾向于描述一致的ID,从而改善了视频片段。

视频自定义扩散(VCD),介绍了一种模块化方法来生成特定于身份的视频。优化过程在T2V VCD和V2V VCD两个管道中复用相同的ID模块以保持其一致性。基于Stable Diffusion,这些管道可以使用在推理过程中在同一基础上进行微调的任何特定领域模型。

文本主要贡献如下:

-

提出一种新的框架,视频自定义扩散(VCD),致力于生成高质量的特定id视频。VCD展示了将IDs与所提供的图像和文本描述进行对齐的实质性改进。

-

提出一种鲁棒的3D高斯噪声先验用于视频帧去噪,增强帧间相关性,从而改善视频一致性。

-

提出两个V2V模块,即Face VCD和Tiled VCD,以将视频放大到更高的分辨率。

-

设计了一种新的训练范式,通过提示到分割来掩盖损失,以减少ID token中的噪声。

相关工作

主题驱动文本到图像生成

最近的研究集中在定制化生成模型上,通过使用预训练的T2I扩散模型和一小组定制化的主题图像,旨在微调模型并学习与所需主题相关的唯一标识符。早期的方法,如Textual Inversion,通过调整令牌嵌入来学习令牌和主题图像之间的映射,而不改变模型结构。DreamBooth则通过全面微调模型来学习主题的概念,并保留了一般概念生成的能力。这引发了一系列后续研究,如NeTI,专注于保持主题的保真度和身份特征。它进一步扩展到多主题生成,其中模型能够共同学习多个主题,并将它们组合成一个生成的图像。

文本到视频生成

T2V是生成模型的新应用,比图像生成更具挑战性。视频生成需要高计算成本,需要在多个帧之间保持长期的空间和时间一致性,并且需要根据简短的视频字幕进行条件控制。早期的探索使用GAN和VAE方法生成帧,但这些方法仅适用于低分辨率视频。最新的扩散模型成功地引领了视频生成的新浪潮,MagicVideo和Video LDM等先驱性工作引入了新的条件采样技术。

视频编辑

一些方法可以通过微调模型来改变视频内容,同时保留运动。其他方法则结合可训练的运动动态模块和预训练的稳定扩散模型,进一步实现由文本、姿势/边缘/图像引导的视频合成,而无需使用任何配对的文本-视频数据。最近,一种名为AnimateDiff的方法通过在运动模块的训练中提取合理的运动先验,使现有的个性化文本到图像模型动画化。

图像动画

以前的图像动画主要集中在将静态图像扩展为一系列帧,而没有改变场景或修改角色属性。我们的框架不仅能够动画化给定的帧,还能修改主体的属性和更改背景,所有这些都以合理的动作呈现。

Video Custom Diffusion (VCD)

本文提出了一个用于VCD的预处理模块,以及一个ID模块和一个运动模块。此外,还提供了一个可选模块,利用ControlNet Tile对视频进行上采样,生成高分辨率内容。该方法结合了AnimateDiff的现成运动模块,并增加了我们提出的3D高斯噪声先验。ID模块引入了扩展的ID令牌,采用掩码损失和提示分割。在Face VCD和Tiled VCD中引入了两个V2V VCD流水线。

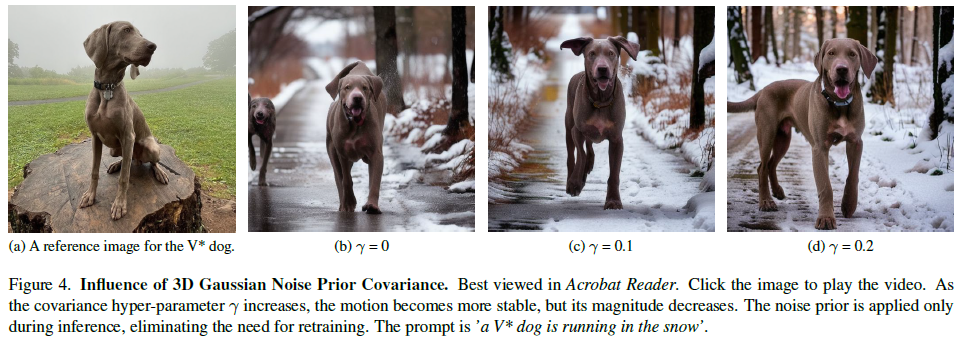

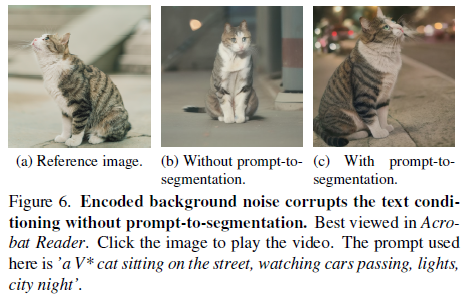

3D高斯噪声先验

为了减轻推理过程中的曝光偏差,我们将无需训练的3D高斯噪声先验应用于现成的运动模块。选择的运动模块将网络扩展到时间维度,将2D卷积和注意力层转换为时间伪3D层,遵循方程2中的训练目标。3D高斯噪声先验通过从多元高斯分布N(0, Σf(γ))中采样来处理由f帧组成的视频。其中,Σf(γ)表示由γ ∈ (0, 1)参数化的协方差矩阵。上述协方差确保了初始化的3D噪声在m-th和n-th帧之间的相同位置上具有γ |m −n|的协方差。超参数γ代表了稳定性和运动幅度之间的权衡关系。较低的γ值会导致具有剧烈运动但不稳定的视频,而较高的γ值会导致更稳定但幅度较小的运动。

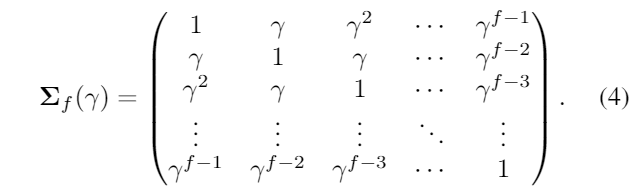

ID模块

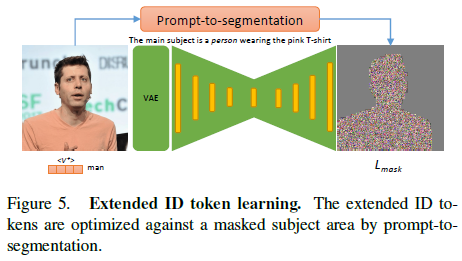

本文提出了两种方法来改进T2V生成中的身份定制问题。首先,使用扩展ID令牌来与条件编码交互,以更好地保留身份的视觉特征。其次,使用prompt-to-segmentation方法来消除编码的背景噪声,以提高图像文本一致性。这些方法可以提高视频质量并减少参数空间。

Face VCD和Tiled VCD

Face VCD用于提高视频中人脸的清晰度和分辨率。该方法首先检测和裁剪视频中的人脸区域,并将其拼接成一个以人脸为中心的视频。然后使用VCD进行部分去噪处理,提高人脸的分辨率和清晰度。为了进一步提高视频的分辨率,作者还提出了Tiled VCD方法,将视频分割成4个512x512像素的瓷砖,并使用VCD进行部分去噪处理,以恢复缺失的细节和身份信息。最终,视频被放大到1024x1024像素。

实验

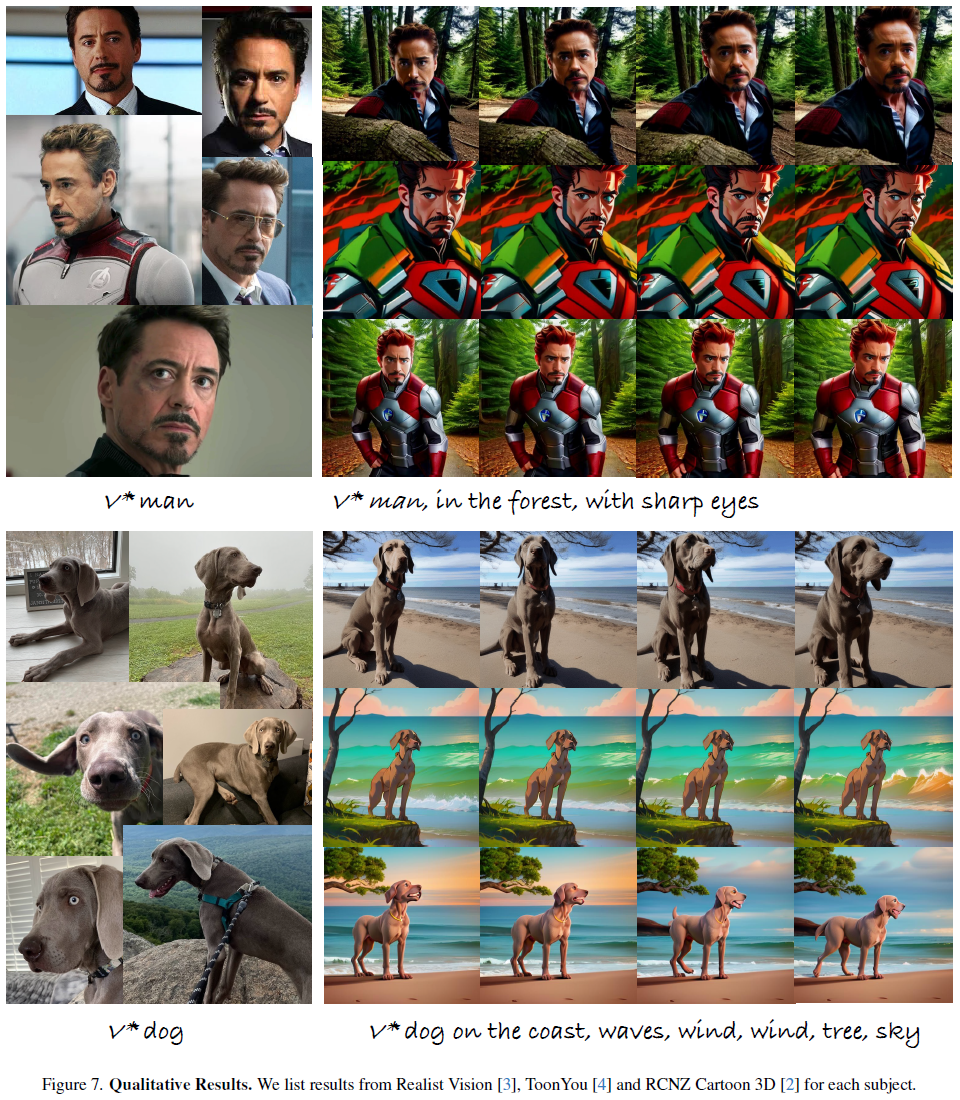

定性结果

VCD不仅在逼真的基础模型中保持了角色的身份,还在各种类型的风格化模型中保持了角色的身份。从Civitai获取了开源模型,包括Realist Vision 、ToonYou和RCNZ Cartoon 3D。首先描述了实现细节和选定的基准线。然后进行了消融研究,并与选定的基准方法进行了比较。

实现细节

**训练。**ID模块使用Stable Diffusion 1.5进行训练,并在推理过程中使用Realistic Vision。

**数据集。**从DreamBooth数据集和CustomConcept101以及互联网中精心选择了16个主题,确保了人类、动物和物体的多样化表示。对于每个主题,我们要求GPT-4V在不同的背景下创建25个动画提示。为了评估目的,该模型为每个提示生成4个视频,使用不同的随机种子。这个过程总共产生了1600个视频。

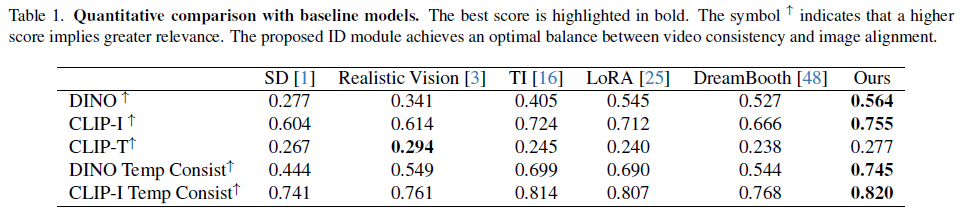

**评价指标。**从三个角度评估生成的视频。(i)身份对齐:生成的身份的视觉外观应与参考图像中的视觉外观保持一致。利用CLIP-I和DINO计算每对视频帧与参考图像之间的相似度得分。(ii)文本对齐:在CLIP特征空间中计算文本-图像相似性得分。(iii)时间平滑性:通过计算所有连续视频帧对的CLIP和DINO相似性得分来评估生成视频的时间一致性。需要注意的是,时间平滑性不仅受到连续帧之间内容一致性的影响,还受到运动幅度的影响。因此,在比较结果时,建议综合考虑文本对齐、图像对齐和时间平滑性。

**基线。**由于缺乏特定于身份的T2V方法,本文将ID模块的选择与AnimateDiff的组成和几种特定于身份的定制方法进行了比较,如CustomDiffusion、Textual Inversion和LoRA,这些方法都结合了3D高斯噪声先验。

定量结果

Realistic Vision是一个在Stable Diffusion基础上进行微调的社区开发模型,其生成的图像更加逼真。在表1中,Realistic Vision通常优于SD,因此我们选择它作为基础模型。然而,对于像DreamBooth这样需要对UNet中的所有权重进行微调的模型来说,替换基础模型的权重是不可行的。它的性能通常较差,突显了广泛微调的局限性。

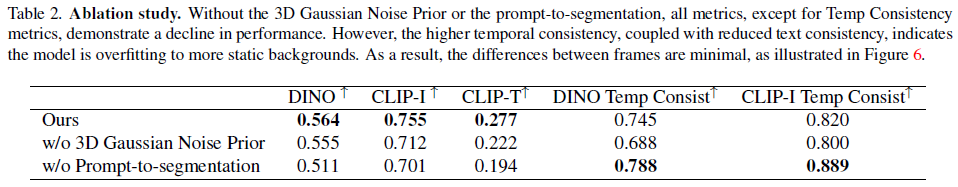

消融分析

本文进行了详细的消融研究,发现3D高斯噪声先验对于视频平滑、图像对齐和CLIP-T得分至关重要。相反,去除提示到分割模块会增加视频平滑度,但会降低CLIP-T和CLIP-I得分。这是因为这种去除会导致令牌中编码的背景噪声,从而破坏文本条件。因此,生成的视频缺乏运动,导致平滑度得分更高。

限制和未来工作

提出的框架在处理多个身份的视频时存在问题,特别是当这些角色需要互动时,视频质量会下降。框架的运动模块容量有限,难以扩展视频长度并保持一致性和保真度。未来需要改进系统,使其能够处理多个身份之间的互动,并确保在更长的视频中保持质量。

总结

Video Custom Diffusion(VCD)旨在解决主体身份可控视频生成的挑战。通过聚焦身份信息和帧间相关性的融合,VCD为生成不仅能在帧间保持主体身份,而且稳定清晰的视频铺平了道路。本文的创新贡献包括ID模块、T2V VCD模块和V2V模块,共同为视频内容中的身份保护建立了新的标准。通过广泛的实验,证实了VCD在生成高质量、稳定的视频方面的优越性。此外,我们的ID模块适用于现有的文本到图像模型,增强了VCD的实用性,使其适用于广泛的应用。

▌关于我们

灵度智能,我们致力于提供优质的AI服务,涵盖人工智能、数据分析、机器学习、深度学习、强化学习、计算机视觉、自然语言处理、语音处理等领域。提供AI课程、AI算法代做、论文复现、远程调试等服务。如有相关需求,请私信与我们联系。

我们的愿景通过创新创意和智能技术为客户提供卓越的解决方案,助力产业升级和数字化转型。我们的产品和服务将引领行业标准,创造卓越的用户体验。我们的团队致力于创造更智能、更便捷和更高效的生活方式,推动社会进步,致力于创造更美好的未来。

51工具盒子

51工具盒子