使用pip下载python依赖包whl文件并进行离线安装

公司项目原因,经常需要到客户现场配置python开发环境,而客户现场提供的开发环境(Windows桌面)基本都是内网环境,无法访问公网,因此要安装python环境都是需要离线安装。为了能将离线搭建开发环境标准化,本文分享一下如何使用pip下载离线安装库whl文件,以及如何离线安装whl文件的经验。 场景描述 {#场景描述} ------------ 具体的场景是需要在一个内...

51工具盒子

51工具盒子

公司项目原因,经常需要到客户现场配置python开发环境,而客户现场提供的开发环境(Windows桌面)基本都是内网环境,无法访问公网,因此要安装python环境都是需要离线安装。为了能将离线搭建开发环境标准化,本文分享一下如何使用pip下载离线安装库whl文件,以及如何离线安装whl文件的经验。 场景描述 {#场景描述} ------------ 具体的场景是需要在一个内...

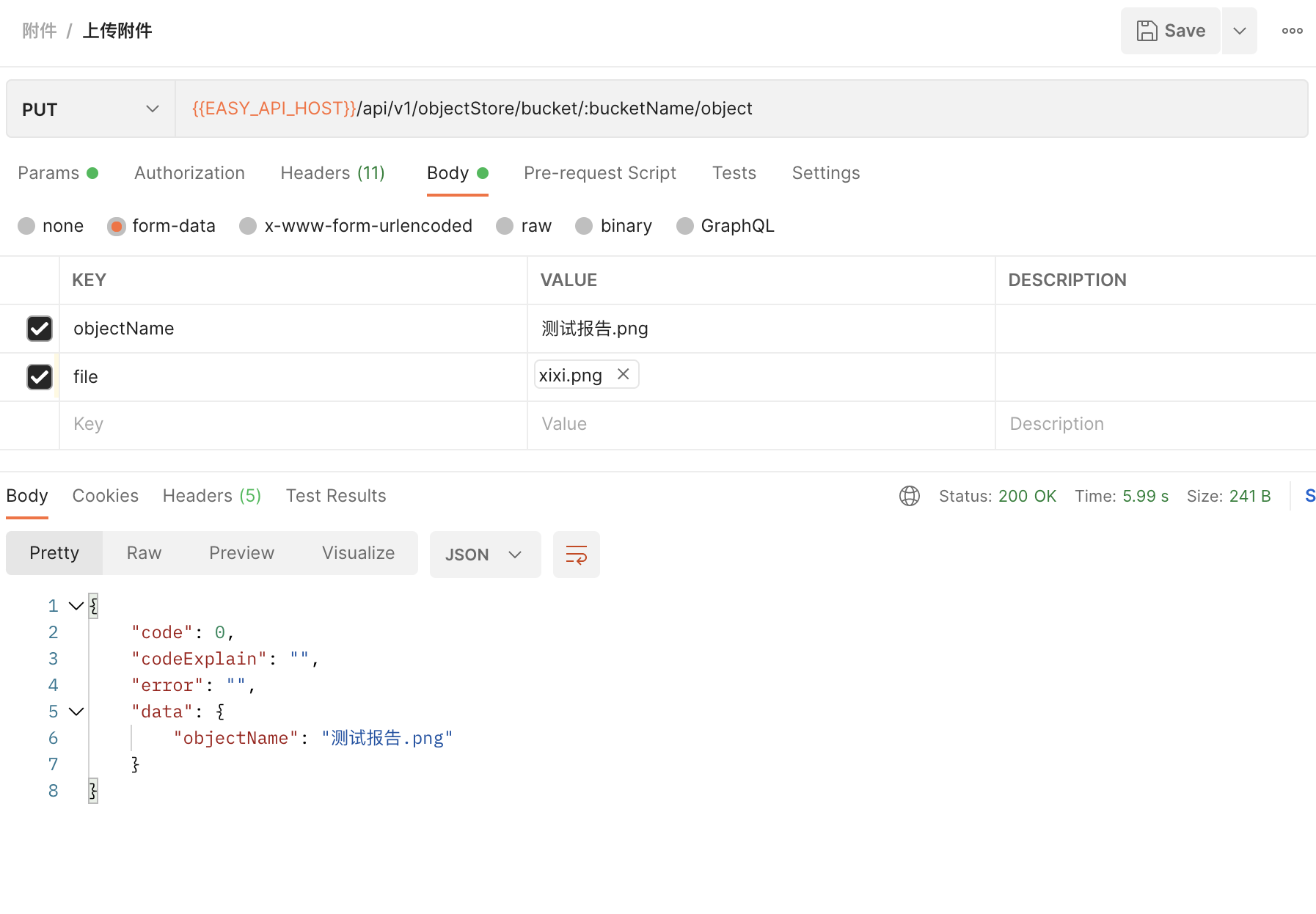

postman 接口调用 {#postman-接口调用} ---------------------------- 一般文件上传的接口大概如下,某个字段需要上传文件,比如这里的是file字段

Python 有很多魔法方法,本文记录一下可以自定义 with 语句的上下文管理器所使用到的两个魔法方法,也就是 `__enter__` 和 `__exit__` 方法的实用性。 自定义上下文管理类 {#自定义上下文管理类} ---------------------- 最常见的 with 语句就是 open 函数了,这里不做解释,直接来看一个自定义类的例子。 ```...

公司很多旧的项目代码都是 python2 的,而新项目代码都是 python3,于是我自己本地也是同时搭建了两个版本的 python 环境,平时写代码都是在 python3 的环境写好,然后在 python2 环境再验证一下兼容性,目的就是为了保证两个环境能通用。由于经常会遇到一些需要进行兼容的问题,因此觉得需要一篇博客来记录一下。 判断 python 版本的方法 {#判断-...

工作中经常需要登录 linux 服务器调用接口,一般都是使用 curl 命令,而我本身习惯是本地用 Python 写接口调用的,也就是使用 requests 库写的。于是就经常会有人问我要某个接口的 curl 命令的时候我就需要去重新组装一下,将现有的 requests 脚本改写成 curl 命令行的形式。于是,py2curl 就诞生了,一个简单的 Python 脚本库,可以将...

前段时间写了一个 django 的应用安装包打包上传到了 PyPI,由于是第一次打包分发,所以趁机研究了一下 Python 打包的相关注意事项。网上的确是可以搜到很多相关资料,但是我发现很多人都在无脑复制粘贴或者简单的提供了一份打包配置,一点不实际也不实用,而我最喜欢的就是分享实际经验,所以这次也不例外,来分享踩坑指南。 打包规范 {#打包规范} ------------ ...

之前公司的项目部署主要使用的是 ansible 编排,说到 ansible 就不得不提到强大的 jinja 语法了。而后来公司又让各个服务把部署方式改成 SDK 安装的方式,这个转变就引发了一些重复利用文件的问题,最后的解决办法就是使用 yaml 和 jinja2 将原本属于 ansible 的模板文件充分利用起来了。这篇文章就来分享一下我在工作中使用到的 jinja 用法。 ...

一般我们在运行 Python 项目或者脚本的时候都是直接执行启动脚本即可,但是 Python 作为一个脚本语言,在 Linux 中经常会跟 Shell 脚本结合使用,这个时候执行的 Python 脚本多半都需要使用命令行参数传入一些变量,下面就分享一下我在工作中常见和自己会使用的3种命令行参数传入方式。 命令行参数模块 {#命令行参数模块} -----------------...

我本地和服务器的连接一直使用的是 Xshell 5,而在与服务器进行文件操作的时候使用的是 Xshell 推荐安装的一个工具 Xftp 5,然而,昨天自己想着从服务器下载备份好的的数据库文件到本地的时候发现这个文件传输工具居然过期不能用了,好气啊!于是没办法(机智如我)只好用 Python 来实现 SSH 的连接,顺便从服务器批量下载一些文件,实现自动化。 项目介绍 {#项目...

.app 域名是前段时间谷歌花费2500万美元竞拍获得,是全球首个需要 HTTPS 加密的顶级域名。该域名从2018年5月8日开始全面接受注册,由于这个域名对于现今移动 APP 的发展有着非常重要的意义,所以必将带来一波域名疯抢的高潮。那么,在这波域名抢注的机会中,我们可以使用 Python 做点什么呢? 首先,我们知道,域名在注册之前是需要查询一下自己想要的域名有没有被注册...