如何在 Python 2.7 中获取未调用函数的局部变量

背景 {#背景} -------- 我们公司平台的开发环境中使用的是 Python 2.7 版本,最近工作中,我遇到这样一个需求:我需要在一个方法中访问另一个函数内部定义的变量。这些变量包括字符串和数字类型,来源于一个预定义的固定函数。 这个固定函数会在执行文件前由平台自动注入,且**不能被修改**,并且函数中包含的一些变量是动态的,只能注入之后才能知道具体是什么。本质就是...

51工具盒子

51工具盒子

背景 {#背景} -------- 我们公司平台的开发环境中使用的是 Python 2.7 版本,最近工作中,我遇到这样一个需求:我需要在一个方法中访问另一个函数内部定义的变量。这些变量包括字符串和数字类型,来源于一个预定义的固定函数。 这个固定函数会在执行文件前由平台自动注入,且**不能被修改**,并且函数中包含的一些变量是动态的,只能注入之后才能知道具体是什么。本质就是...

背景 {#背景} -------- 我们公司的产品有一些微应用依然使用的 Python 开发,由于历史原因,公司产品提供的 Python 环境是 2.7.18,所以当时选择的框架是支持 Python2 的异步框架 Tornado。 最近我有个需求是需要启动一个微服务提供几个接口,于是我本着不引入新依赖的原则打算基于平台提供的 Tornado 封装的模块去开发一个微服务。于是...

临时修改日志级别 {#临时修改日志级别} -------------------- **使用场景**:在脚本的调试阶段,尽可能的输入更多的信息,以便于定位问题,而在正式使用中只打印关键信息即可。 **解决方案** :在 `if __name__ == '__main__':` 中使用 `setLevel` 重新设置当前文件的的日志级别,调试的时候只需要这行代...

前言 {#前言} -------- 我的博客配置了很多定时任务,其中有一部分定时任务属于 I/O 密集型的任务,比如需要进行大量的网络请求,此类任务执行普遍会比较耗时。最近看了几篇关于 Python 异步函数的文章,就想到可以把这些任务改造一下,改造完成后发现效率直接飙升! 定时任务的异步改造 {#定时任务的异步改造} ---------------------- ###...

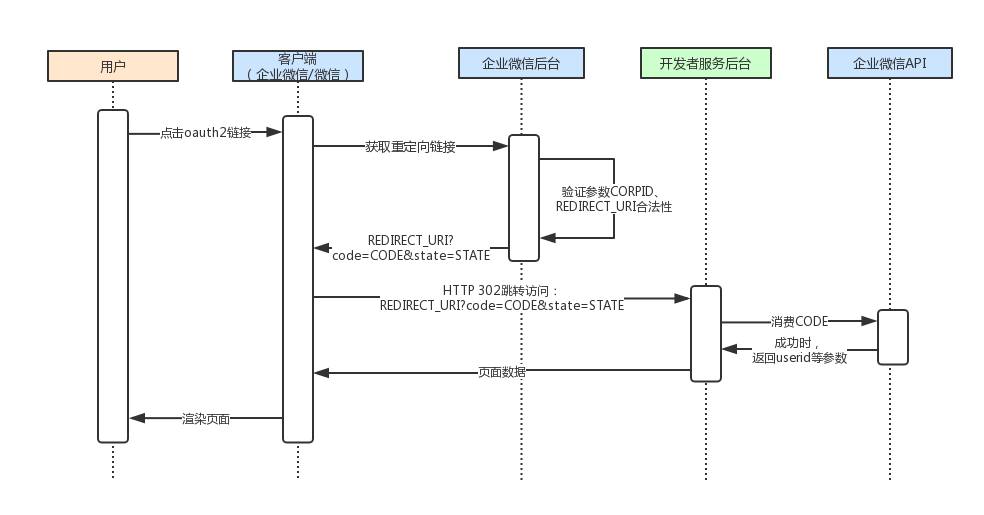

最近在对接企业微信搞单点登录,其实之前我搞个这个,无非就是调用企微接口使用code获取用户信息。之所以打算写一篇文章记录一下这次的对接经验,是因为我感觉这套代码的一个思路(关于如何简单的存储会过期的token)可以作为一个类似的接口调用的参考。 企微单点登录对接流程 {#企微单点登录对接流程} ------------------------ 只要有单点登录的概念,知道单独...

前言 {#前言} -------- 最近在搞虚拟机变更自动化的对接,支持了两个平台,分别是 SmartX 和 VMware 平台。这篇文章记录一下使用 Python SDK 进行 VMware 虚拟机操作的一些实战场景,主要包括快照创建、快照删除、计算资源变更、磁盘扩容等操作。 💩 **感慨** VMware 的使用和 Python SDK 使用已经不是第一次了,之前...

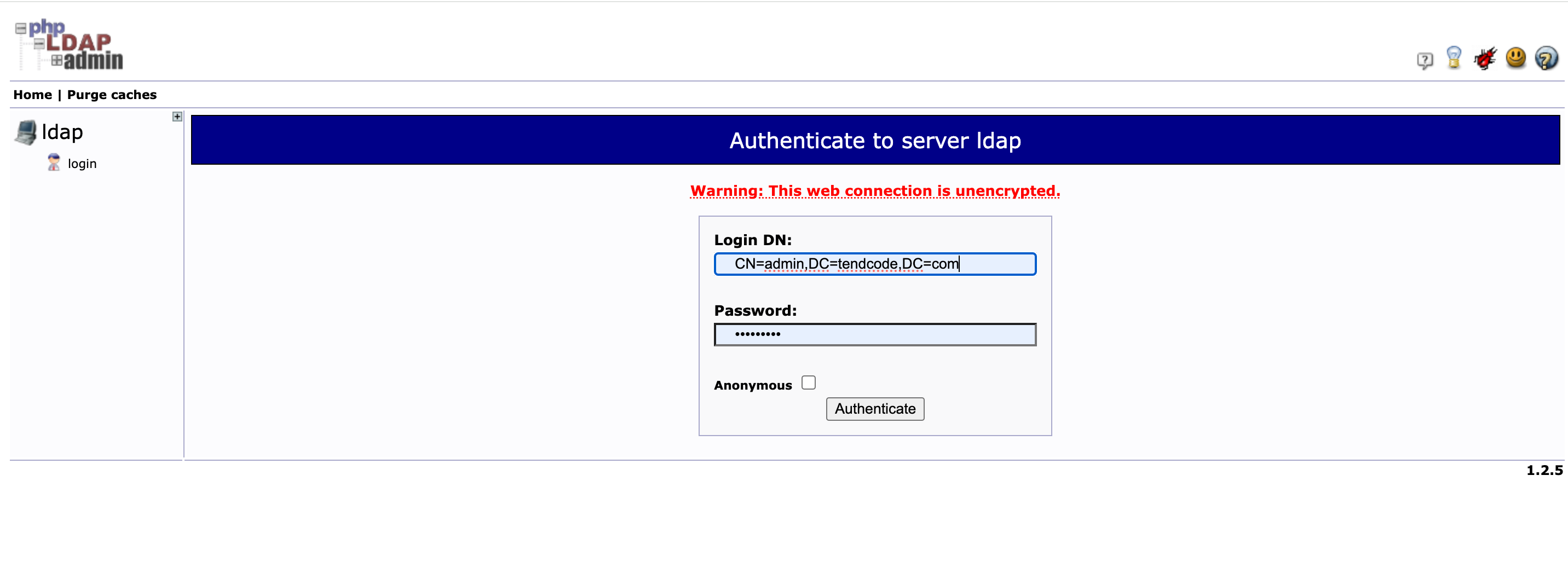

前言 {#前言} -------- 写这篇文章的初衷:公司的平台可以配置 LDAP 登录,在客户项目中这是一个最常见的功能,对接 LDAP 主要分成两个部分,第一个配置对接,这个有标准流程,直接配置就行;第二部分是用户数据同步,这个需要根据客户现场组织架构调整同步逻辑。 我发现公司其他人写的用户同步脚本乱七八糟的,虽然每个客户的现场数据不同,但是按理只是查询条件不同而已,不...

最近在写很多自动化的脚本,涉及很多平台的接口调用,比如虚拟化平台 VMware、SmartX、Nutanix,其中涉及很多异步任务的接口调用,比如创建快照、删除快照、扩容等接口,基本都是异步任务。此时就需要不停的去查询任务状态,只有任务状态为成功或失败才结束。 因此,我写了一个通用的装饰器来处理这种需要重复执行某个函数,直到得到预期返回的操作。 方案思路解析 {#方案思路解...

现在大部分跟代码有关的编辑器和网站基本都是支持 markdown 语法的,我比较喜欢的 markdown 内容显示的网站是 vitepress 的网站,vitepress 支持的语法比较全,而且有很多个性化的渲染语法,是原生的 markdown 不具备的。 本文分享一下利用 markdown 自带的拓展类进行自定义渲染语法。 自定义行渲染规则 {#自定义行渲染规则} ---...

公司项目原因,经常需要到客户现场配置python开发环境,而客户现场提供的开发环境(Windows桌面)基本都是内网环境,无法访问公网,因此要安装python环境都是需要离线安装。为了能将离线搭建开发环境标准化,本文分享一下如何使用pip下载离线安装库whl文件,以及如何离线安装whl文件的经验。 场景描述 {#场景描述} ------------ 具体的场景是需要在一个内...