一、Zookeeper介绍

{#7430-1534039864147}ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,是一个针对大型分布式系统的可靠协调系统;

**{#0053-1534039767655}提供的功能包括:配置维护、名字服务、分布式同步、组服务等;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

**{#0042-1534039767655}目标就是封装好复杂易出错的关键职务,将简单易用的接口和性能高效、功能稳定的系统提供给用户;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

**{#3156-1534039767655}Zookeeper已经成为Hadoop生态系统中的基础组件。**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

工作原理

{#8889-1534039813373}ZooKeeper是以Fast Paxos算法为基础的,Paxos 算法存在活锁的问题,即当有多个proposer交错提交时,有可能互相排斥导致没有一个proposer能提交成功,而Fast Paxos作了一些优化,通过选举产生一个leader (领导者),只有leader才能提交proposer,具体算法可见Fast Paxos。因此,要想弄懂ZooKeeper首先得对Fast Paxos有所了解文章源自小柒网-https://www.yangxingzhen.cn/1371.html

{#7770-1534039814308}ZooKeeper的基本运转流程

- {#2951-1534039814308}选举Leader。

- {#4867-1534039814308}同步数据。

- 选举Leader过程中算法有很多,但要达到的选举标准是一致的。

- Leader要具有最高的执行ID,类似root权限。

- {#7613-1534039814308}集群中大多数的机器得到响应并接受选出的Leader。

{#1275-1534039767655}二、Zookeeper特点

**{#6077-1534039767655}最终一致性:为客户端展示同一视图,这是Zookeeper最重要的性能;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

**{#3665-1534039767655}可靠性:如果消息被一台服务器接受,那么它将被所有的服务器接受;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

**{#3229-1534039767655}原子性:更新只能成功或失败,没有中间状态;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

{#5293-1534039767655}三、Zookeeper应用场景

{#9738-1534039767655}1、统一命名服务文章源自小柒网-https://www.yangxingzhen.cn/1371.html

{#6035-1534039767655}1)分布式环境下,经常需要对应用/服务进行统一命名,便于识别不同的服务文章源自小柒网-https://www.yangxingzhen.cn/1371.html

**{#2895-1534039767655}类似于域名与ip之间对应关系,域名容易记住;**文章源自小柒网-https://www.yangxingzhen.cn/1371.html

{#8984-1534039767655}通过名称来获取资源或服务的地址,提供者信息。

{#2053-1534039767655}2)按照层次结构组织服务/应用名称

{#9470-1534039767655}可将服务名称以及地址信息写在Zookeeper上,客户端通过Zookeeper获取可用服务列表。

{#6586-1534039767655}2、配置管理

{#3057-1534039767655}1)分布式环境下,配置文件管理和同步是一个常见问题

{#8558-1534039767655}一个集群中,所有节点的配置信息是一致的,比如Hadoop;

{#8184-1534039767655}对配置文件修改后,希望能够快速同步到各个节点上。

{#9855-1534039767655}2)配置管理可交由Zookeeper实现

{#9951-1534039767655}可将配置信息写入Zookeeper的一个znode上;

{#3930-1534039767655}各个节点监听这个znode

{#8013-1534039767655}一旦znode中的数据被修改,Zookeeper将会通知各个节点。

{#1976-1534039767655}3、集群管理

{#1594-1534039767655}1)分布式环境下,实时掌握每个节点的状态是必要的

{#4646-1534039767655}可根据节点实时状态做出一些调整。

{#7889-1534039767655}2)可交由Zookeeper实现

{#2036-1534039767655}可将节点信息写入Zookeeper的一个znode上;

{#5822-1534039767655}监听这个znode可获得它的实时状态变化。

{#1453-1534039767655}3)典型应用

{#1231-1534039767655}HBase中Master状态的监控与选举。

{#2080-1534039767655}4、分布式通知/协调

{#6224-1534039767655}原理其实就是发布/订阅。

{#8168-1534039767655}1)分布式环境下经常存在一个服务需要知道它所管理的子服务的状态

{#5051-1534039767655}NameNode需要知道各DataNode的状态

{#3292-1534039767655}2)心跳检测机制可通过Zookeeper实现

{#9150-1534039767655}3)信息推送可由Zookeeper实现(发布/订阅模式)

{#6387-1534039767655}5、分布式锁

{#8494-1534039767655}1)Zookeeper是强一致性的

{#8478-1534039767655}多个客户端同时在Zookeeper上创建相同znode,只有一个创建成功。

{#3631-1534039767655}2)实现锁的独占性

{#5990-1534039767655}多个客户端同时在Zookeeper上创建相同znode,创建成功的那个客户端得到锁,其他客户端等待。

{#8268-1534039767655}3)控制锁的时序

{#4070-1534039767655}各个客户端在某个znode下创建临时znode(类型为CreateMode.EPHEMERAL_SEQUENTIAL),这样,该znode可掌握全局访问时序。

{#5640-1534039767655}四、用到了Zookeeper的一些系统

{#8846-1534039767655}HDFS

{#1889-1534039767655}YARN

{#4962-1534039767655}Storm

{#1170-1534039767655}HBase

{#7026-1534039767655}Flume

{#3641-1534039767655}Dubbo

{#8454-1534039767655}metaq

{#7986-1534039767655}五、Zookeeper集群安装部署

{#8730-1534039767655}下面开始介绍Zookeeper的安装部署。安装部署分三种模式:单机模式、伪分布式模式和分布式模式。单机模式和伪分布式比较简单,多用于本地测试调试,下面介绍分布式模式安装部署。

{#9314-1534039767655}注意:3台机器都需要安装zk。对于Zookeeper集群的话,官方推荐的最小节点数为3个。

{#4222-1534039959291}1)环境信息

|----------------|------------------|-----------------------------| | 操作系统 | IP地址 | 安装软件 | | Centos 7.4 | 192.168.8.20 | JDK1.8、zookeeper-3.4.10 | | Centos 7.4 | 192.168.8.21 | JDK1.8、zookeeper-3.4.10 | | Centos 7.4 | 192.168.8.22 | JDK1.8、zookeeper-3.4.10 |

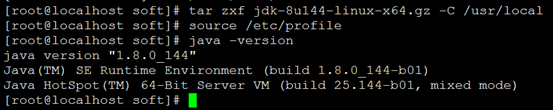

{#2145-1534044317791}2)安装JDK1.8(3台机器都需要安装jdk)

{#1625-1534040355411}[root@localhost ~]# cd /data/soft

{#7073-1534039980079}[root@localhost soft]# wget -c https://mirrors.yangxingzhen.com/jdk/jdk-8u144-linux-x64.tar.gz

{#3784-1534040361164}[root@localhost soft]# tar zxf jdk-8u144-linux-x64.gz -C /usr/local

{#1493-1534040475562}配置环境变量

{#2235-1534040485259}[root@localhost soft]# vim /etc/profile,添加以下内容

export JAVA_HOME=/usr/local/jdk1.8.0_144

export CLASSPATH=$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH:$HOMR/bin

{#3618-1534040750242}执行source /etc/profile 使其生效

{#9618-1534040781992}[root@localhost soft]# java -version

{#8521-1534040504915}3)安装zookeeper

{#4986-1534039980079}1、下载zookeeper包

[root@localhost soft]# wget -c http://mirror.bit.edu.cn/apache/zookeeper/zookeeper-3.4.10/zookeeper-3.4.10.tar.gz

2、解压安装配置第一台zk

{#8013-1534041091339}[root@localhost soft]# tar zxf zookeeper-3.4.10.tar.gz -C /usr/local/

{#4388-1534041439255}[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/

{#7710-1534041192410}创建快照日志存放目录:

{#6381-1534041200994}[root@localhost zookeeper-3.4.10]# mkdir -p dataDir

{#8522-1534041201586}创建事务日志存放目录:

{#3680-1534039980079}[root@localhost zookeeper-3.4.10]# mkdir -p datalogDir

{#3030-1534041288778}【注意】:如果不配置dataLogDir,那么事务日志也会写在dataDir目录中。这样会严重影响zk的性能。因为在zk吞吐量很高的时候,产生的事务日志和快照日志太多。

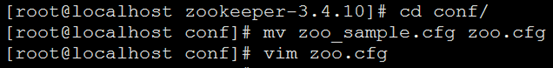

{#0082-1534041765302}[root@localhost zookeeper-3.4.10]# cd conf/

{#3270-1534041774689}[root@localhost conf]# mv zoo_sample.cfg zoo.cfg

{#6379-1534041774689}[root@localhost conf]# vim zoo.cfg

{#8219-1534041297084}修改配置文件,配置如下内容:

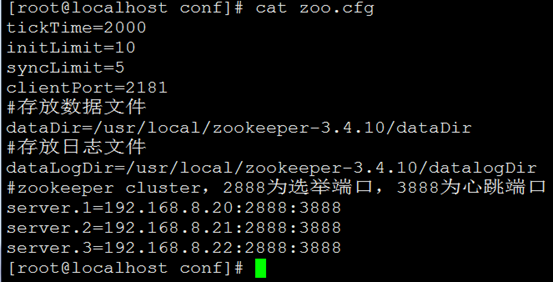

tickTime=2000

initLimit=10

syncLimit=5

clientPort=2181

#存放数据文件

dataDir=/usr/local/zookeeper-3.4.10/dataDir

#存放日志文件

dataLogDir=/usr/local/zookeeper-3.4.10/datalogDir

#zookeeper cluster,2888为选举端口,3888为心跳端口

server.1=192.168.8.20:2888:3888

server.2=192.168.8.21:2888:3888

server.3=192.168.8.22:2888:3888

{#1725-1534041727851}在我们配置的dataDir指定的目录下面,创建一个myid文件,里面内容为一个数字,用来标识当前主机,conf/zoo.cfg文件中配置的server.X中X为什么数字,则myid文件中就输入这个数字:

{#4276-1534041841420}[root@localhost local]# echo "1" >/usr/local/zookeeper-3.4.10/dataDir/myid

{#1081-1534041857244}2)远程复制第一台的zk到另外两台上,并修改myid文件为2和3

{#8993-1534041868565}[root@localhost conf]# cd /usr/local/

{#2082-1534042042531}[root@localhost local]# scp -rp zookeeper-3.4.10/ root@192.168.8.21:/usr/local/

{#6236-1534042087439}[root@localhost local]# scp -rp zookeeper-3.4.10/ root@192.168.8.22:/usr/local/

{#3055-1534042226669}在192.168.8.21执行

{#5663-1534042093134}[root@localhost soft]# echo "2" >/usr/local/zookeeper-3.4.10/dataDir/myid

{#5771-1534042242342}在192.168.8.22执行

{#4473-1534042223790}[root@localhost soft]# echo "3" >/usr/local/zookeeper-3.4.10/dataDir/myid

{#2731-1534042250452}4)启动和关闭zk

{#3024-1534042270048}在ZooKeeper集群的每个结点上,执行启动ZooKeeper服务的脚本,如下所示:

{#8650-1534042282172}[root@localhost local]# cd zookeeper-3.4.10/bin

{#3069-1534042386429}[root@localhost bin]# ./zkServer.sh start

{#2576-1534042386429}ZooKeeper JMX enabled by default

{#9890-1534042386429}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#3063-1534042386429}Starting zookeeper ... STARTED

{#9151-1534042389348}192.168.8.21:

{#5750-1534042401252}[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/bin/

{#9820-1534042411525}[root@localhost bin]# ./zkServer.sh start

{#3880-1534042411525}ZooKeeper JMX enabled by default

{#4813-1534042411525}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#7264-1534042411525}Starting zookeeper ... STARTED

192.168.8.22:

{#2840-1534042403195}[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/bin/

{#3294-1534042413696}[root@localhost bin]# ./zkServer.sh start

{#7478-1534042413696}ZooKeeper JMX enabled by default

{#2381-1534042413696}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#9840-1534042413696}Starting zookeeper ... STARTED

{#2249-1534042481779}日志可查询:/usr/local/zookeeper-3.4.10/bin/zookeeper.out

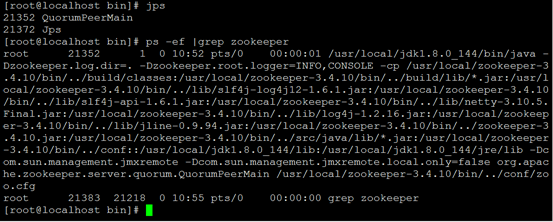

{#5256-1534042496731}可以通过命令jps查看Zookeeper进程:

{#5762-1534042548051}[root@localhost bin]# jps

{#9171-1534042556099}[root@localhost bin]# ps -ef |grep zookeeper

{#7779-1534042543706}停止zk命令:

{#8051-1534042588210}[root@localhost bin]# /usr/local/zookeeper-3.4.10/bin/zkServer.sh stop

{#7011-1534042651216}5)测试zk集群

{#3636-1534042662623}可以通过ZooKeeper的脚本来查看启动状态,包括集群中各个结点的角色(或是Leader,或是Follower)

{#3539-1534043020219}IP:192.168.8.20

{#1682-1534042959285}[root@localhost bin]# ./zkServer.sh status

{#8977-1534042966646}ZooKeeper JMX enabled by default

{#6863-1534042966646}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#1956-1534042966646}Mode: follower

{#1726-1534043034947}IP:192.168.8.21

{#7013-1534043014130}[root@localhost bin]# ./zkServer.sh status

{#9939-1534043015184}ZooKeeper JMX enabled by default

{#4271-1534043015184}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#6183-1534043015184}Mode: leader

{#3699-1534043039755}IP:192.168.8.22

{#8095-1534042967389}[root@localhost bin]# ./zkServer.sh status

{#2211-1534042997750}ZooKeeper JMX enabled by default

{#4019-1534042997750}Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

{#5737-1534042997750}Mode: follower

{#8994-1534043148490}通过上面状态查询结果可见,192.168.8.21是集群的Leader,其余的两个结点是Follower。

{#5075-1534043148553}另外,可以通过客户端脚本,连接到ZooKeeper集群上。对于客户端来说,ZooKeeper是一个整体,连接到ZooKeeper集群实际上感觉在独享整个集群的服务,所以,你可以在任何一个结点上建立到服务集群的连接。

{#3112-1534043275345}zookeeper简单操作命令:

{#7749-1534043479729}#连接到任意节点生成数据:

{#4370-1534043443975}[root@localhost bin]# ./zkCli.sh -server 192.168.8.20:2181

{#4265-1534043282322}[zk: 192.168.8.20:2181(CONNECTED) 0] create /test "hello"

{#1367-1534043440938}Created /test

{#9260-1534043440938}[zk: 192.168.8.20:2181(CONNECTED) 1] get /test

{#6770-1534043440938}hello

{#2814-1534043440938}cZxid = 0x100000002

{#4692-1534043440938}ctime = Sun Aug 12 11:10:13 CST 2018

{#3079-1534043440938}mZxid = 0x100000002

{#2668-1534043440938}mtime = Sun Aug 12 11:10:13 CST 2018

{#3654-1534043440938}pZxid = 0x100000002

{#0091-1534043440938}cversion = 0

{#4114-1534043440938}dataVersion = 0

{#9257-1534043440938}aclVersion = 0

{#2536-1534043440938}ephemeralOwner = 0x0

{#6455-1534043440938}dataLength = 5

{#2330-1534043440938}numChildren = 0

{#2036-1534043440938}#在其他zookeeper节点验证数据:

{#2744-1534043536072}[root@localhost bin]# ./zkCli.sh -server 192.168.8.21:2181

{#7239-1534043533814}[zk: 192.168.8.21:2181(CONNECTED) 0] get /test

{#9694-1534043534257}hello

{#3543-1534043534257}cZxid = 0x100000002

{#5682-1534043534257}ctime = Sun Aug 12 11:10:13 CST 2018

{#4949-1534043534257}mZxid = 0x100000002

{#4080-1534043534257}mtime = Sun Aug 12 11:10:13 CST 2018

{#7965-1534043534257}pZxid = 0x100000002

{#6960-1534043534257}cversion = 0

{#0090-1534043534257}dataVersion = 0

{#4784-1534043534257}aclVersion = 0

{#6850-1534043534257}ephemeralOwner = 0x0

{#8078-1534043534257}dataLength = 5

{#3636-1534043534257}numChildren = 0

{#5025-1534043623261}[root@localhost bin]# ./zkCli.sh -server 192.168.8.22:2181

{#6736-1534043658715}[zk: 192.168.8.22:2181(CONNECTED) 0] get /test

{#9058-1534043659064}hello

{#7415-1534043659064}cZxid = 0x100000002

{#5240-1534043659064}ctime = Sun Aug 12 11:10:13 CST 2018

{#3093-1534043659064}mZxid = 0x100000002

{#5880-1534043659064}mtime = Sun Aug 12 11:10:13 CST 2018

{#9230-1534043659064}pZxid = 0x100000002

{#9500-1534043659064}cversion = 0

{#9999-1534043659064}dataVersion = 0

{#9083-1534043659064}aclVersion = 0

{#9255-1534043659064}ephemeralOwner = 0x0

{#9650-1534043659064}dataLength = 5

{#3122-1534043659064}numChildren = 0 {#5910-1534043671811}

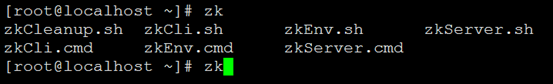

{#4050-1534043883856}添加zookeeper环境变量/etc/profile内容如下

export PATH=/usr/local/zookeeper-3.4.10/bin:$PATH

执行{#2857-1534043936064}source /etc/profile,使其生效

至此,Zookeeper集群搭建完毕。

继续阅读

历史上的今天

8 月

12

- 2023Linux安装Clamav Zookeeper最后更新:2022-12-5

51工具盒子

51工具盒子