1.1 安装 {#11-安装}

-

1.进入/opt目录下 cd /opt

-

2.安装

wget http://download.redis.io/releases/redis-5.0.2.tar.gz tar xzf redis-5.0.2.tar.gz cd redis-5.0.2 make

1.2 备份redis的配置文件 {#12-备份redis的配置文件}

> 进入opt目录

cd /opt

> 新建一个myredisconf文件夹

mkdir myredisconf

> 进入redis的安装目录

cd /opt/redis-5.0.2

>复制配置文件到myredisconf文件加

cp ./redis.conf ../myredisconf

1.3 修改redis备份后的配置文件 {#13-修改redis备份后的配置文件}

vim /opt/myredisconf/redis.conf

将下面的daemonize no改为yes

################################ GENERAL #####################################

By default Redis does not run as a daemon. Use 'yes' if you need it.

Note that Redis will write a pid file in /var/run/redis.pid when daemonized.

daemonize yes

1.4 启动redis的服务端 {#14-启动redis的服务端}

进入到redis的src目录下

cd /opt/redis-5.0.2/src

使用备份的配置文件启动redis服务端

./redis-server /opt/myredisconf/redis.conf

看到类似如下提示说明启动成功

8347:C 11 Dec 2018 16:36:52.716 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

8347:C 11 Dec 2018 16:36:52.716 # Redis version=5.0.2, bits=64, commit=00000000, modified=0, pid=8347, just started

8347:C 11 Dec 2018 16:36:52.716 # Configuration loaded

接着启动redis的客户端,默认端口号是6379,参数-p ./redis-cli -p 6379 出现下面提示便进入到了redis的客户端 127.0.0.1:6379> 测试连接 输入:ping redis回答PONG说明连接成功 测试存储 set k1 helloworld get k1 看到 "helloworld" 使用select 库号 可以切换库

1.5 redis性能测试 {#15-redis性能测试}

启动redis服务器,切换到redis安装目录下,运行redis-benchmark即可看到测试读写速度

- redis启动后杂项基础知识 {#2-redis启动后杂项基础知识}

- dbsize

查看当前库的key数量

- keys pattern (如:keys *,keys k?)

列出当前库所有键,keys支持正则查询,例如:keys k?会查询首字母带k的键

keys [0-9]* 会查询出首字母是数字的所有key

- flushall

清空所有库(不要用!)

- flushdb

清空当前库(不要用!)

redis统一密码管理,16个库密码要么不用,要么都相同

- redis五大数据类型 {#3-redis五大数据类型}

Redis is an open source (BSD licensed), in-memory data structure store , used as a database, cache and message broker. It supports data structures such as strings, hashes, lists, sets, sorted sets with range queries, bitmaps, hyperloglogs, geospatial indexes with radius queries and streams. Redis has built-in replication, Lua scripting, LRU eviction, transactions and different levels of on-disk persistence, and provides high availability via Redis Sentinel and automatic partitioning with Redis Cluster.

redis是一个内存数据结构存储器,可以用来作为数据库、缓存和消息代理。他支持的数据类型有

-

String

-

hash

-

list

-

set

-

sorted set

-

bitmap

-

超级日志

-

具有半径查询和流地理空间索引

3.0 redis 键操作(key) {#30-redis-键操作key}

-

keys *

-

exists key名:判断某个key是否存在

-

move key db:将key记录移动到其他库

-

expire key 秒数:为给定的key设置过期时间

-

ttl key:查看还有多少秒过期,-1表示永不过期,-2表示已过期,过期后记录不存在

-

type key:查看key的类型

如果存储时键已经存在则内容覆盖

其他命令查文档

redis命令参考网址:http://redisdoc.com/

3.1 String型 {#31-string型}

String是redis最基本的类型,可以理解为与memcache一模一样的类型,一个key对应一个value。

String类型二进制安全的,意思是redis的String可以包含任何数据。比如jpg的图片或者序列化的对象,一个redis中字符串value最多可以是512M。

字符串操作指令: {#字符串操作指令}

-

strlen key:

获取键长度

-

append key:

追加

-

对于键是纯数值的:

incr key:单步递增 decr key:单步递减 incrby key:设置步长递增 decrby key:设置步长递减

-

getrange

获取指定区间范围内的值,相当于字符串截取如:

getrange k1 0 3

-

setex(set with expire)键秒值

将键 key 的值设置为 value , 并将键 key 的生存时间设置为 seconds 秒钟。 如果键 key 已经存在, 那么 SETEX 命令将覆盖已有的值。 SETEX 命令的效果和以下两个命令的效果类似: SET key value EXPIRE key seconds # 设置生存时间

SETEX 和这两个命令的不同之处在于 SETEX 是一个原子(atomic)操作, 它可以在同一时间内完成设置值和设置过期时间这两个操作, 因此 SETEX 命令在储存缓存的时候非常实用。

-

setnx(set if not exist)

SETEX 和这两个命令的不同之处在于

SETEX是一个原子(atomic)操作, 它可以在同一时间内完成设置值和设置过期时间这两个操作, 因此SETEX命令在储存缓存的时候非常实用。返回值 命令在设置成功时返回 1 , 设置失败时返回 0 。

示例: redis> EXISTS job # job 不存在 (integer) 0

redis> SETNX job "programmer" # job 设置成功 (integer) 1

-

MSET key value [key value ...]

同时为多个键设置值。

如果某个给定键已经存在, 那么 MSET 将使用新值去覆盖旧值, 如果这不是你所希望的效果, 请考虑使用 MSETNX 命令, 这个命令只会在所有给定键都不存在的情况下进行设置。

MSET 命令总是返回 OK 。

示例: redis> MSET date "2012.3.30" time "11:00 a.m." weather "sunny" OK

- MGET key [key ...]

返回给定的一个或多个字符串键的值。

如果给定的字符串键里面, 有某个键不存在, 那么这个键的值将以特殊值 nil 表示。

返回值:

MGET 命令将返回一个列表, 列表中包含了所有给定键的值。

示例:

redis> MGET redis mongodb

-

"redis.com"

-

"mongodb.org"

-

MSETNX key value [key value ...]

当且仅当所有给定键都不存在时, 为所有给定键设置值。

即使只有一个给定键已经存在, MSETNX 命令也会拒绝执行对所有键的设置操作。

MSETNX 是一个原子性(atomic)操作, 所有给定键要么就全部都被设置, 要么就全部都不设置, 不可能出现第三种状态。

返回值: 当所有给定键都设置成功时, 命令返回 1 ; 如果因为某个给定键已经存在而导致设置未能成功执行, 那么命令返回 0 。

示例: 对不存在的键执行 MSETNX 命令: MSETNX k1 "MySQL" k2 "MongoDB" k3 "redis" 对某个已经存在的键进行设置: redis> MSETNX rmdbs "Sqlite" language "python" # rmdbs 键已经存在,操作失败 (integer) 0

3.2 List列表 {#32-list列表}

redis列表是简单的字符串列表,按照插入顺序排列,你可以添加一个元素到列表的头部(左边)或者尾部(右边)。它的底层实际是一个链表。

-

LPUSH key value [value ...]

作用:将一个或多个值 value 插入到列表 key 的表头

描述:如果有多个 value 值,那么各个 value 值按从左到右的顺序依次插入到表头: 比如说,对空列表 mylist 执行命令 LPUSH mylist a b c ,列表的值将是 c b a ,这等同于原子性地执行 LPUSH mylist a 、 LPUSH mylist b 和 LPUSH mylist c 三个命令。 如果 key 不存在,一个空列表会被创建并执行 LPUSH 操作。 当 key 存在但不是列表类型时,返回一个错误。

返回值: 执行 LPUSH 命令后,列表的长度。

示例: redis> lpush mylist a b c d a # 列表允许重复元素 redis> LRANGE mylist 0 -1 "a" "b" "c" "d" "a"

-

LPUSHX key value

作用:将值 value 插入到列表 key 的表头,当且仅当 key 存在并且是一个列表。相当于对已存在的列表执行追加操作。 和 LPUSH key value [value ...] 命令相反,当 key 不存在时, LPUSHX 命令什么也不做。

示例:

对空列表执行 LPUSHX

redis> LPUSHX greet "hello" # 尝试 LPUSHX,失败,因为列表为空 (integer) 0

对非空列表执行 LPUSHX

redis> LPUSHX greet "good morning" # 这次 LPUSHX 执行成功 (integer) 2

-

RPUSH key value [value ...]

作用:将一个或多个值 value 插入到列表 key 的表尾(最右边)。

描述:如果有多个 value 值,那么各个 value 值按从左到右的顺序依次插入到表尾:比如对一个空列表 mylist 执行 RPUSH mylist a b c ,得出的结果列表为 a b c ,等同于执行命令 RPUSH mylist a 、 RPUSH mylist b 、 RPUSH mylist c 。

如果 key 不存在,一个空列表会被创建并执行 RPUSH 操作 当 key 存在但不是列表类型时,返回一个错误。

返回值: 执行 RPUSH 操作后,表的长度。

示例: redis> RPUSH mylist a b c (integer) 3

redis> LRANGE mylist 0 -1

-

"a"

-

"b"

-

"c"

-

-

LPOP key

作用:移除并返回列表 key 的头元素

返回值: 列表的头元素。 当 key 不存在时,返回 nil 。

示例:类似队列,先进先出 redis> RPUSH mylist a b c (integer) 3 redis>lpop mylist "a"

-

RPOP key

作用:移除并返回列表 key 的尾元素。

返回值: 列表的尾元素。 当 key 不存在时,返回 nil 。

示例:类似栈,先进后出 redis> RPUSH mylist a b c d (integer) 3 redis>rpop mylist "d"

-

LINDEX key index

作用:返回列表 key 中,下标为 index 的元素。

描述:下标(index)参数 start 和 stop 都以 0 为底,也就是说,以 0 表示列表的第一个元素,以 1 表示列表的第二个元素,以此类推。 你也可以使用负数下标,以 -1 表示列表的最后一个元素, -2 表示列表的倒数第二个元素,以此类推。如果 key 不是列表类型,返回一个错误。

返回值:列表中下标为 index 的元素。 如果 index 参数的值不在列表的区间范围内(out of range),返回 nil

示例: redis> lpush mylist 1 2 3 4 5 redis> lrange mylist 0 -1

-

"5"

-

"4"

-

"3"

-

"2"

-

"1" redis> lindex mylist 1 "4"

-

-

LLEN key

作用:返回列表 key 的长度。

描述:如果 key 不存在,则 key 被解释为一个空列表,返回 0 如果 key 不是列表类型,返回一个错误。

返回值:列表 key 的长度。

示例: redis> llen mylist (integer) 5

-

LREM key count value

作用:根据参数 count 的值,移除列表中与参数 value 相等的元素。

描述:count 的值可以是以下几种: count > 0 : 从表头开始向表尾搜索,移除与 value 相等的元素,数量为 count 。 count < 0 : 从表尾开始向表头搜索,移除与 value 相等的元素,数量为 count 的绝对值。 count = 0 : 移除表中所有与 value 相等的值。

返回值:被移除元素的数量。 因为不存在的 key 被视作空表(empty list),所以当 key 不存在时, LREM 命令总是返回 0 。

示例: redis> lrange mylist 0 -1

-

"3"

-

"2"

-

"2"

-

"2"

-

"5"

-

"4"

-

"3"

-

"2"

-

"1" redis> lrem mylist 2 2 #移除2个mylist中的2 (integer) 2 redis> lrange mylist 0 -1

-

"3"

-

"2"

-

"5"

-

"4"

-

"3"

-

"2"

-

"1"

-

-

LTRIM key start stop

作用:对一个列表进行修剪(trim),就是说,让列表只保留指定区间内的元素,不在指定区间之内的元素都将被删除。

描述:举个例子,执行命令 LTRIM list 0 2 ,表示只保留列表 list 的前三个元素,其余元素全部删除。下标(index)参数 start 和 stop 都以 0 为底。也可以使用负数下标,以 -1 表示列表的最后一个元素,-2 表示列表的倒数第二个元素。

返回值: 当 key 不是列表类型时,返回一个错误 命令执行成功时,返回 ok 。

注意: 超出范围的下标值不会引起错误。 如果 start 下标比列表的最大下标 end ( LLEN list 减去 1 )还要大,或者 start > stop , LTRIM 返回一个空列表(因为 LTRIM 已经将整个列表清空)。 如果 stop 下标比 end 下标还要大,Redis将 stop 的值设置为 end 。

示例: redis> lpush mylist 1 2 3 4 5 6 redis> lrange mylist 0 -1

-

"8"

-

"7"

-

"6"

-

"5"

-

"4"

-

"3"

-

"2"

-

"1" redis> LTRIM mylist 0 4 #截取0-4的元素 OK redis> lrange mylist 0 -1

-

"8"

-

"7"

-

"6"

-

"5"

-

"4"

redis> ltrim mylist 0 10086 #如果 stop下标比end下标还要大,则stop=end 。 redis> lrange mylist 0 -1 #所以一个也没有被丢弃

-

"8"

-

"7"

-

"6"

-

"5"

-

"4"

redis> ltrim mylist 10086 4 #start > end 则列表被清空 redis> lrange mylist 0 -1 (empty list or set) -

-

RPOPLPUSH source destination

作用: 将列表 source 中的最后一个元素(尾元素)弹出,并返回给客户端。 将 source 弹出的元素插入到列表 destination ,作为 destination 列表的的头元素

描述: 如果 source 不存在,值 nil 被返回,并且不执行其他动作。 如果 source 和 destination 相同,则列表中的表尾元素被移动到表头,并返回该元素,可以把这种特殊情况视作列表的旋转(rotation)操作。

返回值:被弹出的元素。

示例: redis> lpush mylist 1 2 3 4 5 redis> lrange mylist 0 -1

-

"5"

-

"4"

-

"3"

-

"2"

-

"1" redis> rpoplpush mylist deslist #将mylist的尾元素添加到deslist的头部

-

"1"

redis> lrange deslist 0 -1

"1"

-

-

LSET key index value

作用:将列表 key 下标为 index 的元素的值设置为 value 。 当 index 参数超出范围,或对一个空列表( key 不存在)进行 LSET 时,返回一个错误。

返回值: 操作成功返回 ok ,否则返回错误信息。

示例: redis> lpush mylist 1 2 3 4 5 (integer) 5 redis> lrange mylist 0 -1

-

"5"

-

"4"

-

"3"

-

"2"

-

"1" redis> lset mylist 2 7 #将下标为2的元素设置为7 OK redis> lrange mylist 0 -1

-

"5"

-

"4"

-

"7"

-

"2"

-

"1"

-

-

LINSERT key BEFORE|AFTER pivot value

作用:将值 value 插入到列表 key 当中,位于值 pivot 之前或之后。 当 pivot 不存在于列表 key 时,不执行任何操作。 当 key 不存在时, key 被视为空列表,不执行任何操作。 如果 key 不是列表类型,返回一个错误。

返回值: 如果命令执行成功,返回插入操作完成之后,列表的长度。 如果没有找到 pivot ,返回 -1 。 如果 key 不存在或为空列表,返回 0 。

示例: redis> lpush mylist js is the best language (integer) 5 redis> lrange mylist 0 -1

-

"language"

-

"best"

-

"the"

-

"is"

-

"js"

redis> linsert mylist before js java #在js之前插入java (integer) 6 redis> lrange mylist 0 -1

-

"language"

-

"best"

-

"the"

-

"is"

-

"java"

-

"js"

-

总结:

他是一个字符串列表,left,right都可以插入/添加

如果键不存在,创建心得链表;

如果键已经存在,新增内容;

如果值全部移除,对应得键也就消失了。

链表得操作无论是头还是尾效率都极高,但假如是对中间元素进行操作,效率就很惨淡了。

3.3 Set集合 {#33-set集合}

redis的set是string类型的无需集合。它是通过HashTable实现的。

-

SADD key member [member ...]

作用:将一个或多个 member 元素加入到集合 key 当中,已经存在于集合的 member 元素将被忽略。 假如 key 不存在,则创建一个只包含 member 元素作成员的集合。 当 key 不是集合类型时,返回一个错误。

返回值: 被添加到集合中的新元素的数量,不包括被忽略的元素。

示例: redis> sadd set01 hello world hello (integer) 2 redis> smembers set01

-

"world"

-

"hello"

-

-

SMEMBERS key

作用:返回集合 key 中的所有成员。 不存在的 key 被视为空集合。

返回值: 集合中的所有成员。

示例: redis> SADD language Ruby Python Clojure (integer) 3

redis> SMEMBERS language

-

"Python"

-

"Ruby"

-

"Clojure"

-

-

SISMEMBER key member

作用:判断 member 元素是否集合 key 的成员。

返回值: 如果 member 元素是集合的成员,返回 1 。 如果 member 元素不是集合的成员,或 key 不存在,返回 0 。

示例: redis> sismember set01 hello (integer) 1

-

SCARD key

作用:返回集合 key 的基数(集合中元素的数量)。

返回值: 集合的基数。 当 key 不存在时,返回 0 。

示例: redis> scard set01 (integer) 2

-

SREM key member [member ...]

作用:移除集合 key 中的一个或多个 member 元素,不存在的 member 元素会被忽略。 当 key 不是集合类型,返回一个错误。

返回值:被成功移除的元素的数量,不包括被忽略的元素。

示例: redis> SMEMBERS set01

-

"hello"

-

"world" redis> srem set01 hello (integer) 1 redis> SMEMBERS set01

-

"world"

-

-

SRANDMEMBER key [count]

作用:如果命令执行时,只提供了 key 参数,那么返回集合中的一个随机元素。

描述:从 Redis 2.6 版本开始, SRANDMEMBER 命令接受可选的 count 参数: 如果 count 为正数,且小于集合基数,那么命令返回一个包含 count 个元素的数组,数组中的元素各不相同。如果 count 大于等于集合基数,那么返回整个集合。 如果 count 为负数,那么命令返回一个数组,数组中的元素可能会重复出现多次,而数组的长度为 count 的绝对值。 该操作和 SPOP key 相似,但 SPOP key 将随机元素从集合中移除并返回,而 SRANDMEMBER 则仅仅返回随机元素,而不对集合进行任何改动。

返回值: 只提供 key 参数时,返回一个元素;如果集合为空,返回 nil 。 如果提供了 count 参数,那么返回一个数组;如果集合为空,返回空数组。

示例: 127.0.0.1:6379> sadd set02 hello is anybody here me (integer) 5 redis> SRANDMEMBER set02 3

-

"hello"

-

"me"

-

"anybody" redis> SRANDMEMBER set02 3

-

"hello"

-

"me"

-

"anybody" redis> SRANDMEMBER set02 3

-

"is"

-

"me"

-

"anybody"

-

-

SPOP key

作用:移除并返回集合中的一个随机元素。

返回值:被移除的随机元素。 当 key 不存在或 key 是空集时,返回 nil 。

示例:5.x版本可以指定pop个数 redis> SMEMBERS set02

-

"is"

-

"here"

-

"anybody"

-

"hello"

-

"me" redis> spop set02 "here" redis> spop set02 2

-

"anybody"

-

"is" redis> SMEMBERS set02

-

"hello"

-

"me"

-

-

SMOVE source destination member

作用:将 member 元素从 source 集合移动到 destination 集合。

描述: 如果 source 集合不存在或不包含指定的 member 元素,则 SMOVE 命令不执行任何操作,仅返回 0 。否则, member 元素从 source 集合中被移除,并添加到 destination 集合中去。 当 destination 集合已经包含 member 元素时, SMOVE 命令只是简单地将 source 集合中的 member 元素删除。

返回值: 如果 member 元素被成功移除,返回 1 。 如果 member 元素不是 source 集合的成员,并且没有任何操作对 destination 集合执行,那么返回 0 。

示例: redis> SMEMBERS set01

-

"are"

-

"you"

-

"world" redis> SMEMBERS set02

-

"x"

-

"y"

-

"z" redis> smove set01 set02 world (integer) 1 redis> SMEMBERS set02

-

"z"

-

"y"

-

"world"

-

"x"

-

数学集合类:

-

差集:SDIFF key [key ...]

作用:返回一个集合的全部成员,该集合是所有给定集合之间的差集。不存在的 key 被视为空集

返回值:一个包含差集成员的列表。

示例: redis> sadd set01 1 2 3 4 5 x y (integer) 7 redis> sadd set02 1 2 3 4 a b c (integer) 7 redis> sdiff set01 set02

-

"y"

-

"x"

-

"5"

-

-

交集:SINTER key [key ...]

作用:返回一个集合的全部成员,该集合是所有给定集合的交集。 不存在的 key 被视为空集。 当给定集合当中有一个空集时,结果也为空集(根据集合运算定律)。

返回值:交集成员的列表。

示例: redis> sadd set01 1 2 3 4 5 x y (integer) 7 redis> sadd set02 1 2 3 4 a b c (integer) 7 redis> sinter set01 set02

-

"2"

-

"3"

-

"1"

-

"4"

-

-

并集:SUNION key [key ...]

作用:返回一个集合的全部成员,该集合是所有给定集合的并集。 不存在的 key 被视为空集。

返回值:并集成员的列表。

示例: redis> sadd set01 1 2 3 4 5 x y (integer) 7 redis> sadd set02 1 2 3 4 a b c (integer) 7 redis> SUNION set01 set02

-

"y"

-

"3"

-

"1"

-

"c"

-

"4"

-

"x"

-

"5"

-

"2"

-

"a"

-

"b"

-

3.4 Hash {#34-hash}

类似Java里面的Map<String,Object>

-

HSET hash field value

作用:将哈希表 hash 中域 field 的值设置为 value 。 如果给定的哈希表并不存在, 那么一个新的哈希表将被创建并执行 HSET 操作。 如果域 field 已经存在于哈希表中, 那么它的旧值将被新值 value 覆盖。

返回值: 当 HSET 命令在哈希表中新创建 field 域并成功为它设置值时, 命令返回 1 ; 如果域 field 已经存在于哈希表, 并且 HSET 命令成功使用新值覆盖了它的旧值, 那么命令返回 0 。

示例: redis> hset user id 001 (integer) 1 redis> hget user id "001"

-

HGET hash field

作用:返回哈希表中给定域的值。

返回值: HGET 命令在默认情况下返回给定域的值。 如果给定域不存在于哈希表中, 又或者给定的哈希表并不存在, 那么命令返回 nil 。

示例: redis> hget user id "001"

-

HSETNX hash field value

作用:当且仅当域 field 尚未存在于哈希表的情况下, 将它的值设置为 value 。 如果给定域已经存在于哈希表当中, 那么命令将放弃执行设置操作。 如果哈希表 hash 不存在, 那么一个新的哈希表将被创建并执行 HSETNX 命令。

返回值: HSETNX 命令在设置成功时返回 1 , 在给定域已经存在而放弃执行设置操作时返回 0 。

示例: #未存在时设置成功 redis> HSETNX database name Redis (integer) 0 redis> HGET database name "Redis"

#已存在时值不变 redis> HSETNX database name Riak (integer) 0 redis> HGET database name "Redis"

-

HMSET key field value [field value ...] / HMGET key field [field ...]

作用:同时将多个 field-value (域-值)对设置到哈希表 key 中。 此命令会覆盖哈希表中已存在的域。 如果 key 不存在,一个空哈希表被创建并执行 HMSET 操作。

返回值: 如果命令执行成功,返回 OK 。 当 key 不是哈希表(hash)类型时,返回一个错误。

示例: redis> hmset customer id 01 name zhangsan sex male OK redis> hmget customer id name sex

-

"01"

-

"zhangsan"

-

"male"

-

-

HGETALL key

作用:返回哈希表 key 中,所有的域和值。 在返回值里,紧跟每个域名(field name)之后是域的值(value),所以返回值的长度是哈希表大小的两倍。

返回值:以列表形式返回哈希表的域和域的值。 若 key 不存在,返回空列表。

示例: redis> hgetall customer

-

"id"

-

"01"

-

"name"

-

"zhangsan"

-

"sex"

-

"male"

-

-

HLEN key

作用:返回哈希表 key 中域的数量。

返回值:哈希表中域的数量。 当 key 不存在时,返回 0 。

示例: redis> hgetall customer

-

"id"

-

"01"

-

"name"

-

"zhangsan"

-

"sex"

-

"male" redis> hlen customer (integer) 3

-

-

HEXISTS hash field

作用:检查给定域 field 是否存在于哈希表 hash 当中。

返回值: HEXISTS 命令在给定域存在时返回 1 , 在给定域不存在时返回 0 。

示例: redis> HEXISTS customer name (integer) 1

-

HKEYS key

作用:返回哈希表 key 中的所有域。

返回值:一个包含哈希表中所有域的表。 当 key 不存在时,返回一个空表。

示例: redis> hkeys customer

-

"id"

-

"name"

-

"sex"

-

-

HVALS key

作用:返回哈希表 key 中所有域的值。

返回值: 一个包含哈希表中所有值的表。 当 key 不存在时,返回一个空表。

示例: redis> hvals customer

-

"01"

-

"zhangsan"

-

"male"

-

-

HINCRBY key field increment

作用:为哈希表 key 中的域 field 的值加上增量 increment 。增量也可以为负数,相当于对给定域进行减法操作。如果 key 不存在,一个新的哈希表被创建并执行 HINCRBY 命令。对字符串进行HINCRBY 会报错。

返回值:执行 HINCRBY 命令之后,哈希表 key 中域 field 的值。

示例: redis> hgetall customer

-

"id"

-

"01"

-

"name"

-

"zhangsan"

-

"sex"

-

"male"

-

"age"

-

"19" redis> hincrby customer age 1 (integer) 20

-

-

HINCRBYFLOAT key field increment

作用:为哈希表 key 中的域 field 加上浮点数增量 increment 。 如果哈希表中没有域 field ,那么 HINCRBYFLOAT 会先将域 field 的值设为 0 ,然后再执行加法操作。如果键 key 不存在,那么 HINCRBYFLOAT 会先创建一个哈希表,再创建域 field ,最后再执行加法操作。

返回值:执行加法操作之后 field 域的值。

示例: redis> HINCRBYFLOAT customer age 0.5 "20.5"

3.5 Zset有序集合(sorted set) {#35-zset有序集合sorted-set}

redis zset和色图一样也是String类型的元素集合,且不允许重复。

不同的是每个元素都会关联一个double类型的分数。

redis正是通过分数来为集合中的成员进行从小到大的排序。zset的成员是唯一的,但是分数(score)却可以重复

-

ZADD key score member [[score member] [score member] ...]

作用:将一个或多个 member 元素及其 score 值加入到有序集 key 当中。 如果某个 member 已经是有序集的成员,那么更新这个 member 的 score 值,并通过重新插入这个 member 元素,来保证该 member 在正确的位置上。 score 值可以是整数值或双精度浮点数。

返回值: 被成功添加的新成员的数量,不包括那些被更新的、已经存在的成员。

示例: redis> zadd page_rank 20 baidu.com 30 google.com 40 tencent.com (integer) 3

-

ZRANGE key start stop [WITHSCORES]

作用:返回有序集 key 中,指定区间内的成员。 其中成员的位置按 score 值递增(从小到大)来排序。 具有相同 score 值的成员按字典序(lexicographical order )来排列。 下标参数 start 和 stop 都以 0 为底,也就是说,以 0 表示有序集第一个成员,以 1 表示有序集第二个成员,以此类推。 你也可以使用负数下标,以 -1 表示最后一个成员, -2 表示倒数第二个成员,以此类推。

返回值:指定区间内,带有 score 值(可选)的有序集成员的列表。

示例: redis> zrange page_rank 0 -1

-

"baidu.com"

-

"google.com"

-

"tencent.com"

redis> zrange page_rank 0 -1 withscores

-

"baidu.com"

-

"20"

-

"google.com"

-

"30"

-

"tencent.com"

-

"40"

-

-

ZRANGEBYSCORE key min max [WITHSCORES] [LIMIT offset count]

作用:返回有序集 key 中,所有 score 值介于 min 和 max 之间(包括等于 min 或 max )的成员。有序集成员按 score 值递增(从小到大)次序排列

LIMIT 参数指定返回结果的数量及区间(就像SQL中的 SELECT LIMIT offset, count ) WITHSCORES 参数决定结果集是单单返回有序集的成员,还是将有序集成员及其 score 值一起返回。

区间及无限: min 和 max 可以是 -inf 和 +inf ,这样一来,你就可以在不知道有序集的最低和最高 score 值的情况下,使用 ZRANGEBYSCORE 这类命令。 默认情况下,区间的取值使用闭区间 (小于等于或大于等于),你也可以通过给参数前增加 ( 符号来使用可选的开区间 (小于或大于),如:ZRANGEBYSCORE zset (1 5

返回值:指定区间内,带有 score 值(可选)的有序集成员的列表。

示例: #显示<=30的网站域名 redis> zrangebyscore page_rank -inf 30 withscores

-

"baidu.com"

-

"20"

-

"google.com"

-

"30"

#显示整个有序集 redis> zrangebyscore page_rank -inf +inf

-

"baidu.com"

-

"google.com"

-

"tencent.com"

#查询>20 <=40的网站域名 27.0.0.1:6379> zrangebyscore page_rank (20 40 withscores

-

"google.com"

-

"30"

-

"tencent.com"

-

"40"

-

-

ZREM key member [member ...]

作用:移除有序集 key 中的一个或多个成员,不存在的成员将被忽略。 当 key 存在但不是有序集类型时,返回一个错误。

返回值:被成功移除的成员的数量,不包括被忽略的成员。

示例: #移除单个元素 redis> zrem page_rank baidu.com (integer) 1

#移除多个元素 redis> ZREM page_rank baidu.com bing.com (integer) 2

-

ZCARD key

作用:返回有序集 key 的基数。

返回值: 当 key 存在且是有序集类型时,返回有序集的基数。 当 key 不存在时,返回 0

示例: redis> zcard page_rank (integer) 2

-

ZCOUNT key min max

作用:返回有序集 key 中, score 值在 min 和 max 之间(默认包括 score 值等于 min 或 max )的成员的数量。

返回值 score 值在 min 和 max 之间的成员的数量。

示例: redis> zadd zset01 10 hello 20 world 30 im 40 jack 50 haha (integer) 5 redis> zcount zset01 10 30 (integer) 3

-

ZRANK key member

作用:返回有序集 key 中成员 member 的排名。其中有序集成员按 score 值递增(从小到大)顺序排列。 排名以 0 为底,也就是说, score 值最小的成员排名为 0 。

返回值: 如果 member 是有序集 key 的成员,返回 member 的排名。 如果 member 不是有序集 key 的成员,返回 nil 。

示例: redis> zrange zset01 0 -1

-

"hello"

-

"world"

-

"im"

-

"jack"

-

"haha" redis> zrank zset01 jack #下标从0开始 (integer) 3

-

-

ZSCORE key member (递增排列)

作用:返回有序集 key 中,成员 member 的 score 值。 如果 member 元素不是有序集 key 的成员,或 key 不存在,返回 nil 。

返回值: member 成员的 score 值,以字符串形式表示。

示例: redis> zrange zset01 0 -1 withscores

-

"hello"

-

"10"

-

"world"

-

"20"

-

"im"

-

"30"

-

"jack"

-

"40"

-

"haha"

-

"50" redis> zscore zset01 im "30"

-

-

ZREVRANGE key start stop [WITHSCORES] (递减排列)

作用:返回有序集 key 中,指定区间内的成员。 其中成员的位置按 score 值递减(从大到小)来排列。 具有相同 score 值的成员按字典序的逆序排列。(reverse lexicographical order)

返回值: 指定区间内,带有 score 值(可选)的有序集成员的列表。

示例: redis> zrevrange zset01 0 -1 withscores

-

"haha"

-

"50"

-

"jack"

-

"40"

-

"im"

-

"30"

-

"world"

-

"20"

-

"hello"

-

"10"

-

-

ZREVRANGEBYSCORE key max min [WITHSCORES] [LIMIT offset count]

作用:返回有序集 key 中, score 值介于 max 和 min 之间(默认包括等于 max 或 min )的所有的成员。有序集成员按 score 值递减(从大到小)的次序排列。 具有相同 score 值的成员按字典序的逆序(reverse lexicographical order )排列。

返回值: 指定区间内,带有 score 值(可选)的有序集成员的列表。

示例: redis> ZREVRANGEBYSCORE zset01 50 20 withscores

-

"haha"

-

"50"

-

"jack"

-

"40"

-

"im"

-

"30"

-

"world"

-

"20"

-

- 解析配置文件 {#4-解析配置文件}

4.1位置 {#41位置}

默认配置文件位置在redis安装目录下

/opt/redis-5.0.2/

备份的配置文件目录:

/opt/myredisconf/

4.2 Units 单位 {#42-units-单位}

1 # Redis configuration file example.

2 #

3 # Note that in order to read the configuration file, Redis must be

4 # started with the file path as first argument:

5 #

6 # ./redis-server /path/to/redis.conf

7

8 # Note on units: when memory size is needed, it is possible to specify

9 # it in the usual form of 1k 5GB 4M and so forth:

10 #

11 # 1k => 1000 bytes

12 # 1kb => 1024 bytes

13 # 1m => 1000000 bytes

14 # 1mb => 1024*1024 bytes

15 # 1g => 1000000000 bytes

16 # 1gb => 1024*1024*1024 bytes

17 #

18 # units are case insensitive so 1GB 1Gb 1gB are all the same.

1.配置大小单位,开头定义了一些基本的度量单位,只支持bytes,不支持bit

2.对大小写敏感

3.1k和1kb大小不一样,1m和1mb大小也不一样,同理以此类推

4.3 Includes包含 {#43-includes包含}

22 # Include one or more other config files here. This is useful if you

23 # have a standard template that goes to all Redis servers but also need

24 # to customize a few per-server settings. Include files can include

25 # other files, so use this wisely.

26 #

27 # Notice option "include" won't be rewritten by command "CONFIG REWRITE"

28 # from admin or Redis Sentinel. Since Redis always uses the last processed

29 # line as value of a configuration directive, you'd better put includes

30 # at the beginning of this file to avoid overwriting config change at runtime.

31 #

32 # If instead you are interested in using includes to override configuration

33 # options, it is better to use include as the last line.

34 #

35 # include /path/to/local.conf

36 # include /path/to/other.conf

和struts2配置文件类似,可以通过include包含,redis.conf可以作用总配置文件,包含其他。

4.4 NETWORK网络 {#44-network网络}

48 # By default, if no "bind" configuration directive is specified, Redis listens

49 # for connections from all the network interfaces available on the server.

50 # It is possible to listen to just one or multiple selected interfaces using

51 # the "bind" configuration directive, followed by one or more IP addresses.

52 #

53 # Examples:

54 #

55 # bind 192.168.1.100 10.0.0.1

56 # bind 127.0.0.1 ::1

57 #

58 # ~~~ WARNING ~~~ If the computer running Redis is directly exposed to the

59 # internet, binding to all the interfaces is dangerous and will expose the

60 # instance to everybody on the internet. So by default we uncomment the

61 # following bind directive, that will force Redis to listen only into

62 # the IPv4 loopback interface address (this means Redis will be able to

63 # accept connections only from clients running into the same computer it

64 # is running).

65 #

66 # IF YOU ARE SURE YOU WANT YOUR INSTANCE TO LISTEN TO ALL THE INTERFACES

67 # JUST COMMENT THE FOLLOWING LINE.

68 # ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

69 bind 127.0.0.1

默认情况下,如果没有指定"绑定"配置指令,Redis将监听用于连接服务器上所有可用的网络接口。可以只使用一个或多个选择的接口来监听"绑定"配置指令,后面跟着一个或多个IP地址。

例如: bind 192.168.1.100 10.0.0.1 bind 127.0.0.1 ::1

如果运行Redis的计算机直接暴露于internet,则绑定到所有接口是危险的,并将实例暴露给internet上的每个人。默认情况下,我们取消注释

遵循bind指令,这将强制Redis只监听IPv4环回接口地址(这意味着Redis将只能接受来自运行在它所运行的同一台计算机上的客户机的连接)。

如果您确定希望实例侦听所有接口,只需注释以下行即可。

bind 127.0.0.1

# Protected mode is a layer of security protection, in order to avoid that

72 # Redis instances left open on the internet are accessed and exploited.

73 #

74 # When protected mode is on and if:

75 #

76 # 1) The server is not binding explicitly to a set of addresses using the

77 # "bind" directive.

78 # 2) No password is configured.

79 #

80 # The server only accepts connections from clients connecting from the

81 # IPv4 and IPv6 loopback addresses 127.0.0.1 and ::1, and from Unix domain

82 # sockets.

83 #

84 # By default protected mode is enabled. You should disable it only if

85 # you are sure you want clients from other hosts to connect to Redis

86 # even if no authentication is configured, nor a specific set of interfaces

87 # are explicitly listed using the "bind" directive.

88 protected-mode yes

受保护模式是一层安全保护,为了避免Redis实例在internet上处于打开状态时被访问和利用。当保护模式为打开时,如果:服务器没有使用"绑定"指令显式地绑定到一组地址。没有配置密码。服务器只接受来自IPv4和IPv6环回地址127.0.0.1和::1以及Unix域套接字的连接。

默认情况下启用保护模式。只有当您确信希望来自其他主机的客户机连接到Redis(即使没有配置身份验证,也没有使用"bind"指令显式列出特定的接口集)时,才应该禁用它。

89 # Accept connections on the specified port, default is 6379 (IANA 90 #815344).

91 # If port 0 is specified Redis will not listen on a TCP socket.

92 port 6379

接受指定端口上的连接,默认值为6379 (IANA 815344)。

如果端口被指定为0,Redis将不会监听TCP套接字。

94 # TCP listen() backlog.

95 #

96 # In high requests-per-second environments you need an high backlog in order

97 # to avoid slow clients connections issues. Note that the Linux kernel

98 # will silently truncate it to the value of /proc/sys/net/core/somaxconn so

99 # make sure to raise both the value of somaxconn and tcp_max_syn_backlog

100 # in order to get the desired effect.

101 tcp-backlog 511

TCP连接队列:

在每秒高请求的环境中,您需要一个高backlog值来避免客户机连接缓慢的问题。注意,Linux内核将悄悄地将其截断为/proc/sys/net/core/somaxconn的值,因此请确保同时提高somaxconn和tcp_max_syn_backlog的值,以获得所需的效果,默认值为511

backlog队列总和=未完成三次握手队列 + 已完成三次握手队列

103 # Unix socket.

104 #

105 # Specify the path for the Unix socket that will be used to listen for

106 # incoming connections. There is no default, so Redis will not listen

107 # on a unix socket when not specified.

108 #

109 # unixsocket /tmp/redis.sock

110 # unixsocketperm 700

111

112 # Close the connection after a client is idle for N seconds (0 to disable)

113 timeout 0

指定用于侦听传入连接的Unix套接字的路径。没有缺省值,因此如果没有指定,Redis将不会在unix套接字上侦听。

如果想要开启unix套接字侦听开启如下配置

unixsocket /tmp/redis.sock

unixsocketperm 700

一下是设置客户端在空闲多少秒后关闭连接(0表示禁用)

timeout 0

# TCP keepalive.

116 #

117 # If non-zero, use SO_KEEPALIVE to send TCP ACKs to clients in absence

118 # of communication. This is useful for two reasons:

119 #

120 # 1) Detect dead peers.

121 # 2) Take the connection alive from the point of view of network

122 # equipment in the middle.

123 #

124 # On Linux, the specified value (in seconds) is the period used to send ACKs.

125 # Note that to close the connection the double of the time is needed.

126 # On other kernels the period depends on the kernel configuration.

127 #

128 # A reasonable value for this option is 300 seconds, which is the new

129 # Redis default starting with Redis 3.2.1.

130 tcp-keepalive 300

设置TCP keepalive:

如果非零,在没有通信的情况下,使用SO_KEEPALIVE向客户机发送TCP ACKs。这很有用,原因有二:

(1) 检测死节点。

(2) 站在网络设备的中间,从网络设备的角度进行活连接。在Linux上,指定的值(以秒为单位)是用来发送ACKs的周期。注意,要关闭连接,需要双倍的时间。对于其他内核,周期取决于内核配置。

这个选项的合理值是300秒,这是从Redis 3.2.1开始,新版Redis的默认值。

tcp-keepalive 300

4.5 通用配置 {#45-通用配置}

# By default Redis does not run as a daemon. Use 'yes' if you need it.

# Note that Redis will write a pid file in /var/run/redis.pid when #daemonized.

daemonize yes

默认情况下,Redis不作为守护进程运行。如果你需要,用"是"。注意,Redis将在/var/run/redis中编写pid文件。

# If you run Redis from upstart or systemd, Redis can interact with your

# supervision tree. Options:

# supervised no - no supervision interaction

# supervised upstart - signal upstart by putting Redis into SIGSTOP mode

# supervised systemd - signal systemd by writing READY=1 to $NOTIFY_SOCKET

# supervised auto - detect upstart or systemd method based on

# UPSTART_JOB or NOTIFY_SOCKET environment variables

# Note: these supervision methods only signal "process is ready."

# They do not enable continuous liveness pings back to your supervisor.

如果您从upstart或systemd运行Redis, Redis可以与您的监控树进行交互。

选项:

supervised no:没有监督互动

supervised upstart:通过将redis设置为SIGSTOP模式向upstart发送信号

supervised systemd:通过写入READY=1到$NOTIFY_SOCKET来信号systemd

supervised auto:

# Specify the server verbosity level.

# This can be one of:

# debug (a lot of information, useful for development/testing)

# verbose (many rarely useful info, but not a mess like the debug level)

# notice (moderately verbose, what you want in production probably)

# warning (only very important / critical messages are logged)

loglevel notice

loglevel日志级别:

指定服务器详细级别。这可以是其中之一:

debug(大量信息,对开发/测试有用)

verbose (许多很少有用的信息,但不像调试级别那样混乱)

notice(可能比较冗长,生产中需要什么)

warning(只记录非常重要/关键的消息)

默认值是:notice

# Specify the log file name. Also the empty string can be used to force

# Redis to log on the standard output. Note that if you use standard

# output for logging but daemonize, logs will be sent to /dev/null

logfile ""

指定日志文件名。另外,空字符串还可以用来强制redis日志以标准方式输出。注意,如果您使用标准输出进行日志记录,但使用守护模式,日志将被发送到/dev/null

# To enable logging to the system logger, just set 'syslog-enabled' to yes,

# and optionally update the other syslog parameters to suit your needs.

# syslog-enabled no

要启用对系统日志记录器的日志记录,只需将'syslog-enabled'设置为yes,并可选地更新其他syslog参数以满足您的需要。

默认值为: syslog-enabled no

#Specify the syslog identity.

# syslog-ident redis

指定syslog标识。

Specify the syslog facility. Must be USER or between LOCAL0-LOCAL7.

# syslog-facility local0

指定syslog工具。必须是USER或介于LOCAL0-LOCAL7之间。

# Set the number of databases. The default database is DB 0, you can select

# a different one on a per-connection basis using SELECT <dbid> where

# dbid is a number between 0 and 'databases'-1

databases 16

设置数据库的数量。默认数据库是DB 0,您可以选择

在每个连接的基础上使用SELECT <DBid>中的一个不同的

DBid是介于0和"databases"-1之间的数字

# By default Redis shows an ASCII art logo only when started to log to the

# standard output and if the standard output is a TTY. Basically this means

# that normally a logo is displayed only in interactive sessions.

#

# However it is possible to force the pre-4.0 behavior and always show a

# ASCII art logo in startup logs by setting the following option to yes.

always-show-logo yes

默认情况下,Redis只在开始记录标准输出和标准输出为TTY时显示ASCII艺术标志。基本上,这意味着logo通常只在交互式会话中显示。

但是,通过将以下选项设置为yes,可以强制执行4.0之前的行为,并始终在启动日志中显示ASCII art徽标。

默认值:always-show-logo no

4.6 SNAPSHOTTING快照 {#46-snapshotting快照}

Save the DB on disk:

#

# save <seconds> <changes>

#

# Will save the DB if both the given number of seconds and the given

# number of write operations against the DB occurred.

#

# In the example below the behaviour will be to save:

# after 900 sec (15 min) if at least 1 key changed

# after 300 sec (5 min) if at least 10 keys changed

# after 60 sec if at least 10000 keys changed

#

# Note: you can disable saving completely by commenting out all "save" lines.

#

# It is also possible to remove all the previously configured save

# points by adding a save directive with a single empty string argument

# like in the following example:

#

# save ""

将数据持久化到磁盘:

save <seconds> <changes>

如果给定的秒数和给定的对数据库的写操作数同时发生,则会保存数据库。

在下面的例子中,行为将被保存:

900秒(15分钟)后,如果至少有一个键发生了变化

300秒(5分钟)后,如果至少有10个键被更改

60秒后,如果至少10000个键发生了变化

注意:您可以通过注释掉所有"save"行来完全禁用save。

也可以删除所有以前配置的保存点,添加一个保存指令与一个空字符串参数,如下面的例子:

save ""

默认值:

save 900 1

save 300 10

save 60 10000

By default Redis will stop accepting writes if RDB snapshots are enabled

(at least one save point) and the latest background save failed.

This will make the user aware (in a hard way) that data is not persisting

on disk properly, otherwise chances are that no one will notice and some

disaster will happen.

If the background saving process will start working again Redis will

automatically allow writes again.

However if you have setup your proper monitoring of the Redis server

and persistence, you may want to disable this feature so that Redis will

continue to work as usual even if there are problems with disk,

permissions, and so forth.

stop-writes-on-bgsave-error yes

默认情况下,如果启用了RDB快照(至少一个保存点),并且最新的后台保存失败,那么Redis将停止接受写操作。这将使用户(以一种艰难的方式)意识到数据没有正确地持久存储在磁盘上,否则很可能没有人会注意到,并且会发生一些灾难。

如果后台保存过程将再次开始工作,Redis将自动允许再次写入。

但是,如果您已经设置了对Redis服务器和持久性的适当监视,那么您可能希望禁用该特性,以便即使存在磁盘、权限等问题,Redis也能照常工作。

意思就是是否在后台保存发生错误时停止写操作,出错了就不在继续保存了,如果需要该特性则设置:

stop-writes-on-bgsave-error yes

Compress string objects using LZF when dump .rdb databases?

For default that's set to 'yes' as it's almost always a win.

If you want to save some CPU in the saving child set it to 'no' but

the dataset will likely be bigger if you have compressible values or keys.

rdbcompression yes

在转储.rdb数据库时使用LZF压缩字符串对象?默认情况下,它被设置为"yes",因为它几乎总是赢家。如果您想在save子集中保存一些CPU,请将其设置为"no",但是如果您有可压缩的值或键,数据集可能会更大。

就是在转存/备份 .rdb文件时是否启用压缩,启用压缩会占用cpu空间,但是没有比要省,占用不了多少。

# The filename where to dump the DB

dbfilename dump.rdb

设置转存文件名,数据持久化到磁盘是.rdb的后缀但还需要一个名字,可以设置该名称。

# The working directory.

#

# The DB will be written inside this directory, with the filename specified

# above using the 'dbfilename' configuration directive.

#

# The Append Only File will also be created inside this directory.

#

# Note that you must specify a directory here, not a file name.

dir ./

设置工作目录:DB将在这个目录中编写,使用上面的"dbfilename"配置指令指定的文件名。这个目录中还将创建Append Only文件。注意,这里必须指定一个目录,而不是文件名。

4.7 REPLICATION主从复制 {#47-replication主从复制}

原文翻译:

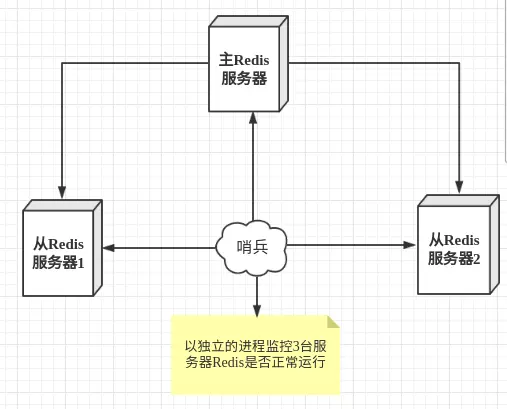

主-从复制:使用replicaof使一个Redis实例成为另一个Redis服务器的副本。关于Redis复制,有几件事需要尽快了解。

+------------------+ +---------------+

| Master | ---> | Replica |

| (receive writes) | | (exact copy) |

+------------------+ +---------------+

-

Redis 使用异步复制。 从 Redis 2.8 开始, 从服务器会以每秒一次的频率向主服务器报告复制流(replication stream)的处理进度。

-

一个主服务器可以有多个从服务器。

-

不仅主服务器可以有从服务器, 从服务器也可以有自己的从服务器, 多个从服务器之间可以构成一个图状结构。

-

复制功能不会阻塞主服务器: 即使有一个或多个从服务器正在进行初次同步, 主服务器也可以继续处理命令请求。

-

复制功能也不会阻塞从服务器: 只要在

redis.conf文件中进行了相应的设置, 即使从服务器正在进行初次同步, 服务器也可以使用旧版本的数据集来处理命令查询。不过, 在从服务器删除旧版本数据集并载入新版本数据集的那段时间内, 连接请求会被阻塞。

你还可以配置从服务器, 让它在与主服务器之间的连接断开时, 向客户端发送一个错误。

-

复制功能可以单纯地用于数据冗余(data redundancy), 也可以通过让多个从服务器处理只读命令请求来提升扩展性(scalability): 比如说, 繁重的 [SORT key BY pattern] [LIMIT offset count] [GET pattern [GET pattern ...]] [ASC | DESC] [ALPHA] [STORE destination] 命令可以交给附属节点去运行。

-

可以通过复制功能来让主服务器免于执行持久化操作: 只要关闭主服务器的持久化功能, 然后由从服务器去执行持久化操作即可。

4.7.1 关闭主服务器持久化时,复制功能的数据安全 {#471-关闭主服务器持久化时复制功能的数据安全}

当配置Redis复制功能时,强烈建议打开主服务器的持久化功能。 否则的话,由于延迟等问题,部署的服务应该要避免自动拉起。

为了帮助理解主服务器关闭持久化时自动拉起的危险性,参考一下以下会导致主从服务器数据全部丢失的例子:

\1. 假设节点A为主服务器,并且关闭了持久化。 并且节点B和节点C从节点A复制数据

\2. 节点A崩溃,然后由自动拉起服务重启了节点A. 由于节点A的持久化被关闭了,所以重启之后没有任何数据

\3. 节点B和节点C将从节点A复制数据,但是A的数据是空的, 于是就把自身保存的数据副本删除。

在关闭主服务器上的持久化,并同时开启自动拉起进程的情况下,即便使用Sentinel来实现Redis的高可用性,也是非常危险的。 因为主服务器可能拉起得非常快,以至于Sentinel在配置的心跳时间间隔内没有检测到主服务器已被重启,然后还是会执行上面的数据丢失的流程。

无论何时,数据安全都是极其重要的,所以应该禁止主服务器关闭持久化的同时自动拉起。

4.7.2 复制功能的运作原理 {#472-复制功能的运作原理}

无论是初次连接还是重新连接, 当建立一个从服务器时, 从服务器都将向主服务器发送一个 SYNC 命令。

接到 SYNC 命令的主服务器将开始执行 BGSAVE , 并在保存操作执行期间, 将所有新执行的写入命令都保存到一个缓冲区里面。

当 BGSAVE 执行完毕后, 主服务器将执行保存操作所得的 .rdb 文件发送给从服务器, 从服务器接收这个 .rdb 文件, 并将文件中的数据载入到内存中。

之后主服务器会以 Redis 命令协议的格式, 将写命令缓冲区中积累的所有内容都发送给从服务器。

你可以通过 telnet 命令来亲自验证这个同步过程: 首先连上一个正在处理命令请求的 Redis 服务器, 然后向它发送 SYNC 命令, 过一阵子, 你将看到 telnet 会话(session)接收到服务器发来的大段数据(.rdb 文件), 之后还会看到, 所有在服务器执行过的写命令, 都会重新发送到 telnet 会话来。

即使有多个从服务器同时向主服务器发送 SYNC , 主服务器也只需执行一次 BGSAVE 命令, 就可以处理所有这些从服务器的同步请求。

从服务器可以在主从服务器之间的连接断开时进行自动重连, 在 Redis 2.8 版本之前, 断线之后重连的从服务器总要执行一次完整重同步(full resynchronization)操作, 但是从 Redis 2.8 版本开始, 从服务器可以根据主服务器的情况来选择执行完整重同步还是部分重同步(partial resynchronization)。

4.7.3 部分重同步 {#473-部分重同步}

从 Redis 2.8 开始, 在网络连接短暂性失效之后, 主从服务器可以尝试继续执行原有的复制进程(process), 而不一定要执行完整重同步操作。

这个特性需要主服务器为被发送的复制流创建一个内存缓冲区(in-memory backlog), 并且主服务器和所有从服务器之间都记录一个复制偏移量(replication offset)和一个主服务器 ID (master run id), 当出现网络连接断开时, 从服务器会重新连接, 并且向主服务器请求继续执行原来的复制进程:

- 如果从服务器记录的主服务器 ID 和当前要连接的主服务器的 ID 相同, 并且从服务器记录的偏移量所指定的数据仍然保存在主服务器的复制流缓冲区里面, 那么主服务器会向从服务器发送断线时缺失的那部分数据, 然后复制工作可以继续执行。

- 否则的话, 从服务器就要执行完整重同步操作。

Redis 2.8 的这个部分重同步特性会用到一个新增的 PSYNC master_run_id offset 内部命令, 而 Redis 2.8 以前的旧版本只有 SYNC 命令, 不过, 只要从服务器是 Redis 2.8 或以上的版本, 它就会根据主服务器的版本来决定到底是使用 PSYNC master_run_id offset 还是 SYNC :

- 如果主服务器是 Redis 2.8 或以上版本,那么从服务器使用 PSYNC master_run_id offset 命令来进行同步。

- 如果主服务器是 Redis 2.8 之前的版本,那么从服务器使用 SYNC 命令来进行同步。

4.7.4 配置 {#474-配置}

配置一个从服务器非常简单, 只要在配置文件中增加以下的这一行就可以了:

slaveof 192.168.1.1 6379

当然, 你需要将代码中的 192.168.1.1 和 6379 替换成你的主服务器的 IP 和端口号。

另外一种方法是调用 SLAVEOF host port 命令, 输入主服务器的 IP 和端口, 然后同步就会开始:

127.0.0.1:6379> SLAVEOF 192.168.1.1 10086

OK

4.7.5 只读从服务器 {#475-只读从服务器}

从 Redis 2.6 开始, 从服务器支持只读模式, 并且该模式为从服务器的默认模式。

只读模式由 redis.conf 文件中的 slave-read-only 选项控制, 也可以通过 CONFIG SET parameter value 命令来开启或关闭这个模式。

只读从服务器会拒绝执行任何写命令, 所以不会出现因为操作失误而将数据不小心写入到了从服务器的情况。

即使从服务器是只读的, DEBUG 和 CONFIG 等管理式命令仍然是可以使用的, 所以我们还是不应该将服务器暴露给互联网或者任何不可信网络。 不过, 使用 redis.conf 中的命令改名选项, 我们可以通过禁止执行某些命令来提升只读从服务器的安全性。

你可能会感到好奇, 既然从服务器上的写数据会被重同步数据覆盖, 也可能在从服务器重启时丢失, 那么为什么要让一个从服务器变得可写呢?

原因是, 一些不重要的临时数据, 仍然是可以保存在从服务器上面的。 比如说, 客户端可以在从服务器上保存主服务器的可达性(reachability)信息, 从而实现故障转移(failover)策略。

4.7.6 从服务器相关配置 {#476-从服务器相关配置}

如果主服务器通过 requirepass 选项设置了密码, 那么为了让从服务器的同步操作可以顺利进行, 我们也必须为从服务器进行相应的身份验证设置。

对于一个正在运行的服务器, 可以使用客户端输入以下命令:

config set masterauth <password>

要永久地设置这个密码, 那么可以将它加入到配置文件中:

masterauth <password>

另外还有几个选项, 它们和主服务器执行部分重同步时所使用的复制流缓冲区有关, 详细的信息可以参考 Redis 源码中附带的 redis.conf 示例文件。

4.7.7主服务器只在有至少 N 个从服务器的情况下,才执行写操作 {#477主服务器只在有至少-n-个从服务器的情况下才执行写操作}

从 Redis 2.8 开始, 为了保证数据的安全性, 可以通过配置, 让主服务器只在有至少 N 个当前已连接从服务器的情况下, 才执行写命令。

不过, 因为 Redis 使用异步复制, 所以主服务器发送的写数据并不一定会被从服务器接收到, 因此, 数据丢失的可能性仍然是存在的。

以下是这个特性的运作原理:

- 从服务器以每秒一次的频率 PING 主服务器一次, 并报告复制流的处理情况。

- 主服务器会记录各个从服务器最后一次向它发送 PING 的时间。

- 用户可以通过配置, 指定网络延迟的最大值

min-slaves-max-lag, 以及执行写操作所需的至少从服务器数量min-slaves-to-write。

如果至少有 min-slaves-to-write 个从服务器, 并且这些服务器的延迟值都少于 min-slaves-max-lag秒, 那么主服务器就会执行客户端请求的写操作。

你可以将这个特性看作 CAP 理论中的 C 的条件放宽版本: 尽管不能保证写操作的持久性, 但起码丢失数据的窗口会被严格限制在指定的秒数中。

另一方面, 如果条件达不到 min-slaves-to-write 和 min-slaves-max-lag 所指定的条件, 那么写操作就不会被执行, 主服务器会向请求执行写操作的客户端返回一个错误。

以下是这个特性的两个选项和它们所需的参数:

min-slaves-to-write <number of slaves>min-slaves-max-lag <number of seconds>

4.8 SECURITY安全 {#48-security安全}

Require clients to issue AUTH <PASSWORD> before processing any other

# commands. This might be useful in environments in which you do not trust

# others with access to the host running redis-server.

#

# This should stay commented out for backward compatibility and because most

# people do not need auth (e.g. they run their own servers).

#

# Warning: since Redis is pretty fast an outside user can try up to

# 150k passwords per second against a good box. This means that you should

# use a very strong password otherwise it will be very easy to break.

#

# requirepass foobared

Command renaming.

It is possible to change the name of dangerous commands in a shared

environment. For instance the CONFIG command may be renamed into something

hard to guess so that it will still be available for internal-use tools

but not available for general clients.

Example:

rename-command CONFIG b840fc02d524045429941cc15f59e41cb7be6c52

It is also possible to completely kill a command by renaming it into

an empty string:

rename-command CONFIG ""

Please note that changing the name of commands that are logged into the

AOF file or transmitted to replicas may cause problems.

安全设置要求客户端在处理任何其他命令之前发出身份验证。在您不信任其他人访问运行redis-server的主机的环境中,这可能很有用。

为了向后兼容性,这应该保留注释,因为大多数人不需要auth(例如,他们运行自己的服务器)。

警告:由于Redis速度相当快,外部用户可以尝试高达每秒150k个密码来破解。这意味着您应该使用一个非常强大的密码,否则它将非常容易被打破。

默认情况下 requirepass 参数是空的,这就意味着你无需通过密码验证就可以连接到 redis 服务。

你配置来设置一个密码,如下:

requirepass foobar

也可以通过命令来修改:

127.0.0.1:6379> CONFIG set requirepass "foobar"

OK

127.0.0.1:6379> CONFIG get requirepass

1) "requirepass"

2) "foobar"

设置密码后,客户端连接 redis 服务就需要密码验证,否则无法执行命令。

AUTH 命令基本语法格式如下:

127.0.0.1:6379> AUTH password

#例如

127.0.0.1:6379> AUTH "foobar"

OK

命令重命名:

可以在共享环境中更改危险命令的名称。例如,可以将CONFIG命令重命名为难以猜测的名称,以便它仍然可以用于内部使用的工具,但不能用于一般客户端。

例子:

rename-command CONFIG b840fc02d524045429941cc15f59e41cb7be6c52

也可以通过将一个命令重命名为空字符串来完全杀死它:

rename-command CONFIG ""

请注意,更改记录到AOF文件或传输到副本的命令的名称可能会导致问题。

4.9 CLIENTS客户端数量 {#49-clients客户端数量}

# Set the max number of connected clients at the same time. By default

# this limit is set to 10000 clients, however if the Redis server is not

# able to configure the process file limit to allow for the specified limit

# the max number of allowed clients is set to the current file limit

# minus 32 (as Redis reserves a few file descriptors for internal uses).

#

# Once the limit is reached Redis will close all the new connections sending

# an error 'max number of clients reached'.

`#maxclients 10000

`

自Redis2.6以后,允许使用者在配置文件(Redis.conf)maxclients属性上修改客户端连接的最大数,也可以通过在Redis-cli工具上输入config set maxclients 去设置最大连接数。根据连接数负载的情况,这个数字应该设置为预期连接数峰值的110%到150之间,若是连接数超出这个数字后,Redis会拒绝并立刻关闭新来的连接。通过设置最大连接数来限制非预期数量的连接数增长,是非常重要的。另外,新连接尝试失败会返回一个错误消息,这可以让客户端知道,Redis此时有非预期数量的连接数,以便执行对应的处理措施。

4.10 MEMORY MANAGEMENT内存管理 {#410-memory-management内存管理}

# Set a memory usage limit to the specified amount of bytes.

# When the memory limit is reached Redis will try to remove keys

# according to the eviction policy selected (see maxmemory-policy).

#

# If Redis can't remove keys according to the policy, or if the policy is

# set to 'noeviction', Redis will start to reply with errors to commands

# that would use more memory, like SET, LPUSH, and so on, and will continue

# to reply to read-only commands like GET.

#

# This option is usually useful when using Redis as an LRU or LFU cache, or to

# set a hard memory limit for an instance (using the 'noeviction' policy).

#

# WARNING: If you have replicas attached to an instance with maxmemory on,

# the size of the output buffers needed to feed the replicas are subtracted

# from the used memory count, so that network problems / resyncs will

# not trigger a loop where keys are evicted, and in turn the output

# buffer of replicas is full with DELs of keys evicted triggering the deletion

# of more keys, and so forth until the database is completely emptied.

# In short... if you have replicas attached it is suggested that you set a lower

# limit for maxmemory so that there is some free RAM on the system for replica

# output buffers (but this is not needed if the policy is 'noeviction').

#

# maxmemory <bytes>

MAXMEMORY POLICY: how Redis will select what to remove when maxmemory

is reached. You can select among five behaviors:

volatile-lru -> Evict using approximated LRU among the keys with an expire set.

allkeys-lru -> Evict any key using approximated LRU.

volatile-lfu -> Evict using approximated LFU among the keys with an expire set.

allkeys-lfu -> Evict any key using approximated LFU.

volatile-random -> Remove a random key among the ones with an expire set.

allkeys-random -> Remove a random key, any key.

volatile-ttl -> Remove the key with the nearest expire time (minor TTL)

noeviction -> Don't evict anything, just return an error on write operations.

LRU means Least Recently Used

LFU means Least Frequently Used

Both LRU, LFU and volatile-ttl are implemented using approximated

randomized algorithms.

Note: with any of the above policies, Redis will return an error on write

operations, when there are no suitable keys for eviction.

At the date of writing these commands are: set setnx setex append

incr decr rpush lpush rpushx lpushx linsert lset rpoplpush sadd

sinter sinterstore sunion sunionstore sdiff sdiffstore zadd zincrby

zunionstore zinterstore hset hsetnx hmset hincrby incrby decrby

getset mset msetnx exec sort

The default is:

maxmemory-policy noeviction

LRU, LFU and minimal TTL algorithms are not precise algorithms but approximated

algorithms (in order to save memory), so you can tune it for speed or

accuracy. For default Redis will check five keys and pick the one that was

used less recently, you can change the sample size using the following

configuration directive.

The default of 5 produces good enough results. 10 Approximates very closely

true LRU but costs more CPU. 3 is faster but not very accurate.

maxmemory-samples 5

Starting from Redis 5, by default a replica will ignore its maxmemory setting

(unless it is promoted to master after a failover or manually). It means

that the eviction of keys will be just handled by the master, sending the

DEL commands to the replica as keys evict in the master side.

This behavior ensures that masters and replicas stay consistent, and is usually

what you want, however if your replica is writable, or you want the replica to have

a different memory setting, and you are sure all the writes performed to the

replica are idempotent, then you may change this default (but be sure to understand

what you are doing).

Note that since the replica by default does not evict, it may end using more

memory than the one set via maxmemory (there are certain buffers that may

be larger on the replica, or data structures may sometimes take more memory and so

forth). So make sure you monitor your replicas and make sure they have enough

memory to never hit a real out-of-memory condition before the master hits

the configured maxmemory setting.

replica-ignore-maxmemory yes

默认情况下,在32位系统中,Redis最大使用3GB的内存,在64位系统中则没有限制。

在使用Redis时,应该对数据占用的最大空间有一个基本准确的预估,并为Redis设定最大使用的内存。否则在64位系统中Redis会无限制地占用内存(当物理内存被占满后会使用swap空间),容易引发各种各样的问题。

通过如下配置控制Redis使用的最大内存:

maxmemory <bytes>

例如:

maxmemory 100mb

在内存占用达到了maxmemory后,再向Redis写入数据时,Redis会:

- 根据配置的数据淘汰策略尝试淘汰数据,释放空间

- 如果没有数据可以淘汰,或者没有配置数据淘汰策略,那么Redis会对所有写请求返回错误,但读请求仍然可以正常执行

在为Redis设置maxmemory时,需要注意:

- 如果采用了Redis的主从复制,主节点向从节点同步数据时,会占用掉一部分内存空间,如果maxmemory过于接近主机的可用内存,导致数据同步时内存不足。所以设置的maxmemory不要过于接近主机可用的内存,留出一部分预留用作主从同步。

数据淘汰机制

Redis提供了5种数据淘汰策略当redis内存占用达到maxmemory时会使用配置的数据淘汰策略来删除内存中的数据:

- volatile-lru:使用LRU算法进行数据淘汰(淘汰上次使用时间最早的,且使用次数最少的key),只淘汰设定了有效期的key

- allkeys-lru:使用LRU算法进行数据淘汰,所有的key都可以被淘汰

- volatile-random:随机淘汰数据,只淘汰设定了有效期的key

- allkeys-random:随机淘汰数据,所有的key都可以被淘汰

- volatile-ttl:淘汰剩余有效期最短的key

最好为Redis指定一种有效的数据淘汰策略以配合maxmemory设置,避免在内存使用满后发生写入失败的情况。

一般来说,推荐使用的策略是volatile-lru,并辨识Redis中保存的数据的重要性。对于那些重要的,绝对不能丢弃的数据(如配置类数据等),应不设置有效期,这样Redis就永远不会淘汰这些数据。对于那些相对不是那么重要的,并且能够热加载的数据(比如缓存最近登录的用户信息,当在Redis中找不到时,程序会去DB中读取),可以设置上有效期,这样在内存不够时Redis就会淘汰这部分数据。

配置方法:

maxmemory-policy volatile-lru #默认是noeviction,即不进行数据淘汰

4.11 LAZY FREEING 惰性删除 {#411-lazy-freeing-惰性删除}

# Redis has two primitives to delete keys. One is called DEL and is a blocking

# deletion of the object. It means that the server stops processing new commands

# in order to reclaim all the memory associated with an object in a synchronous

# way. If the key deleted is associated with a small object, the time needed

# in order to execute the DEL command is very small and comparable to most other

# O(1) or O(log_N) commands in Redis. However if the key is associated with an

# aggregated value containing millions of elements, the server can block for

# a long time (even seconds) in order to complete the operation.

#

# For the above reasons Redis also offers non blocking deletion primitives

# such as UNLINK (non blocking DEL) and the ASYNC option of FLUSHALL and

# FLUSHDB commands, in order to reclaim memory in background. Those commands

# are executed in constant time. Another thread will incrementally free the

# object in the background as fast as possible.

#

# DEL, UNLINK and ASYNC option of FLUSHALL and FLUSHDB are user-controlled.

# It's up to the design of the application to understand when it is a good

# idea to use one or the other. However the Redis server sometimes has to

# delete keys or flush the whole database as a side effect of other operations.

# Specifically Redis deletes objects independently of a user call in the

# following scenarios:

#

# 1) On eviction, because of the maxmemory and maxmemory policy configurations,

# in order to make room for new data, without going over the specified

# memory limit.

# 2) Because of expire: when a key with an associated time to live (see the

# EXPIRE command) must be deleted from memory.

# 3) Because of a side effect of a command that stores data on a key that may

# already exist. For example the RENAME command may delete the old key

# content when it is replaced with another one. Similarly SUNIONSTORE

# or SORT with STORE option may delete existing keys. The SET command

# itself removes any old content of the specified key in order to replace

# it with the specified string.

# 4) During replication, when a replica performs a full resynchronization with

# its master, the content of the whole database is removed in order to

# load the RDB file just transferred.

#

# In all the above cases the default is to delete objects in a blocking way,

# like if DEL was called. However you can configure each case specifically

# in order to instead release memory in a non-blocking way like if UNLINK

# was called, using the following configuration directives:

lazyfree-lazy-eviction no

lazyfree-lazy-expire no

lazyfree-lazy-server-del no

replica-lazy-flush no

redis4.0新增了lazy free特性,lazy free可译为惰性删除或延迟释放;当删除键的时候,redis提供异步延时释放key内存的功能,把key释放操作放在bio(Background I/O)单独的子线程处理中,减少删除big key对redis主线程的阻塞。有效地避免删除big key带来的性能和可用性问题。

由于redis是单线程程序(除少量的bio任务),当运行一个耗时较大的请求时,会导致所有请求排队等待redis不能响应其他请求,引起性能问题,甚至集群发生故障切换。而redis删除大的集合键时,就属于这类比较耗时的请求。

删除集合耗时参考:

| Key类型 | Item数量 | 耗时 | |------------|--------|----------| | Hash | ~100万 | ~1000ms | | List | ~100万 | ~1000ms | | Set | ~100万 | ~1000ms | | Sorted Set | ~100万 | ~1000ms |

lazy free的使用分为2类:

第一类是与DEL命令对应的主动删除。

第二类是过期key删除、maxmemory key驱逐淘汰删除。

主动删除键使用lazy free {#主动删除键使用lazy-free}

UNLINK命令 {#unlink命令}

UNLINK命令是与DEL一样删除key功能的lazy free实现。 唯一不同时,UNLINK在删除集合类键时,如果集合键的元素个数大于64个(详细后文),会把真正的内存释放操作,给单独的bio来操作。 示例如下:使用UNLINK命令删除一个大键mylist, 它包含200万个元素,但用时只有0.03毫秒

redis> LLEN mylist

(integer) 2000000

redis> UNLINK mylist

(integer) 1

redis> SLOWLOG get

1) 1) (integer) 1

2) (integer) 1505465188

3) (integer) 30

4) 1) "UNLINK"

2) "mylist"

5) "127.0.0.1:17015"

6) ""

注意:DEL命令,还是并发阻塞的删除操作

FLUSHALL/FLUSHDB ASYNC {#flushallflushdb-async}

通过对FLUSHALL/FLUSHDB添加ASYNC异步清理选项,来减少操作时间。使用async之后redis在清理整个实例或DB时,操作都是异步的,避免线程杜塞。

redis> flushall //同步清理实例数据,180万个key耗时1020毫秒

OK

(1.02s)

redis> DBSIZE

(integer) 1812637

redis> flushall async //异步清理实例数据,180万个key耗时约9毫秒

OK

redis> SLOWLOG get

1) 1) (integer) 2996109

2) (integer) 1505465989

3) (integer) 9274 //指令运行耗时9.2毫秒

4) 1) "flushall"

2) "async"

5) "127.0.0.1:20110"

6) ""

被动删除键使用lazy free {#被动删除键使用lazy-free}

lazy free应用于被动删除中,目前有4种场景,每种场景对应一个配置参数; 默认都是关闭。

lazyfree-lazy-eviction no

lazyfree-lazy-expire no

lazyfree-lazy-server-del no

slave-lazy-flush no

lazyfree-lazy-eviction {#lazyfree-lazy-eviction}

针对redis内存使用达到maxmeory,并设置有淘汰策略的情况下,决定在被动淘汰键时,是否采用lazy free机制; 因为此场景开启lazy free, 可能使用淘汰键的内存释放不及时,导致redis内存超用,超过maxmemory的限制。此场景使用时,请结合业务测试。

lazyfree-lazy-expire {#lazyfree-lazy-expire}

针对设置有TTL的键,达到过期后,被redis清理删除时是否采用lazy free机制; 此场景建议开启,因TTL本身是自适应调整的速度。

lazyfree-lazy-server-del {#lazyfree-lazy-server-del}

针对有些指令在处理已存在的键时,会带有一个隐式的DEL键的操作。如rename命令,当目标键已存在,redis会先删除目标键,如果这些目标键是一个big key,那就会引入阻塞删除的性能问题。 此参数设置就是解决这类问题,建议可开启。

slave-lazy-flush {#slave-lazy-flush}

针对slave进行全量数据同步,slave在加载master的.rdb文件前,会运行flushall来清理自己的数据场景, lave-lazy-flush参数设置决定是否采用异步flush机制。如果内存变动不大,建议开启。可减少全量同步耗时,从而减少主库因输出缓冲区爆涨引起的内存使用增长。

lazy free的监控 {#lazy-free的监控}

lazy free能监控的数据指标,只有一个值:lazyfree_pending_objects,表示redis执行lazy free操作,在等待被实际回收内容的键个数。并不能体现单个大键的元素个数或等待lazy free回收的内存大小。 所以此值有一定参考值,可监测redis lazy free的效率或堆积键数量; 比如在flushall async场景下会有少量的堆积。

4.12 APPEND ONLY MODE {#412-append-only-mode}

#原文1:什么是APPEND ONLY

# By default Redis asynchronously dumps the dataset on disk. This mode is

# good enough in many applications, but an issue with the Redis process or

# a power outage may result into a few minutes of writes lost (depending on

# the configured save points).

#

# The Append Only File is an alternative persistence mode that provides

# much better durability. For instance using the default data fsync policy

# (see later in the config file) Redis can lose just one second of writes in a

# dramatic event like a server power outage, or a single write if something

# wrong with the Redis process itself happens, but the operating system is

# still running correctly.

#

# AOF and RDB persistence can be enabled at the same time without problems.

# If the AOF is enabled on startup Redis will load the AOF, that is the file

# with the better durability guarantees.

#

# Please check http://redis.io/topics/persistence for more information.

appendonly no

The name of the append only file (default: "appendonly.aof")

appendfilename "appendonly.aof"

原文2:fsync()解释

The fsync() call tells the Operating System to actually write data on disk

instead of waiting for more data in the output buffer. Some OS will really flush

data on disk, some other OS will just try to do it ASAP.

Redis supports three different modes:

no: don't fsync, just let the OS flush the data when it wants. Faster.

always: fsync after every write to the append only log. Slow, Safest.

everysec: fsync only one time every second. Compromise.

The default is "everysec", as that's usually the right compromise between

speed and data safety. It's up to you to understand if you can relax this to

"no" that will let the operating system flush the output buffer when

it wants, for better performances (but if you can live with the idea of

some data loss consider the default persistence mode that's snapshotting),

or on the contrary, use "always" that's very slow but a bit safer than

everysec.

More details please check the following article:

http://antirez.com/post/redis-persistence-demystified.html

If unsure, use "everysec".

appendfsync always

appendfsync everysec

appendfsync no

#原文3:使用fsync的影响

When the AOF fsync policy is set to always or everysec, and a background

saving process (a background save or AOF log background rewriting) is

performing a lot of I/O against the disk, in some Linux configurations

Redis may block too long on the fsync() call. Note that there is no fix for

this currently, as even performing fsync in a different thread will block

our synchronous write(2) call.

In order to mitigate this problem it's possible to use the following option

that will prevent fsync() from being called in the main process while a

BGSAVE or BGREWRITEAOF is in progress.

This means that while another child is saving, the durability of Redis is

the same as "appendfsync none". In practical terms, this means that it is

possible to lose up to 30 seconds of log in the worst scenario (with the

default Linux settings).

If you have latency problems turn this to "yes". Otherwise leave it as

"no" that is the safest pick from the point of view of durability.

no-appendfsync-on-rewrite no

原文4:自动重写append only文件的配置

Automatic rewrite of the append only file.

Redis is able to automatically rewrite the log file implicitly calling

BGREWRITEAOF when the AOF log size grows by the specified percentage.

This is how it works: Redis remembers the size of the AOF file after the

latest rewrite (if no rewrite has happened since the restart, the size of

the AOF at startup is used).

This base size is compared to the current size. If the current size is

bigger than the specified percentage, the rewrite is triggered. Also

you need to specify a minimal size for the AOF file to be rewritten, this

is useful to avoid rewriting the AOF file even if the percentage increase

is reached but it is still pretty small.

Specify a percentage of zero in order to disable the automatic AOF

rewrite feature.

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

原文5:AOF文件在Redis启动过程中被截断时该做何处理

An AOF file may be found to be truncated at the end during the Redis

startup process, when the AOF data gets loaded back into memory.

This may happen when the system where Redis is running

crashes, especially when an ext4 filesystem is mounted without the

data=ordered option (however this can't happen when Redis itself

crashes or aborts but the operating system still works correctly).

Redis can either exit with an error when this happens, or load as much

data as possible (the default now) and start if the AOF file is found

to be truncated at the end. The following option controls this behavior.

If aof-load-truncated is set to yes, a truncated AOF file is loaded and

the Redis server starts emitting a log to inform the user of the event.

Otherwise if the option is set to no, the server aborts with an error

and refuses to start. When the option is set to no, the user requires

to fix the AOF file using the "redis-check-aof" utility before to restart

the server.

Note that if the AOF file will be found to be corrupted in the middle

the server will still exit with an error. This option only applies when

Redis will try to read more data from the AOF file but not enough bytes

will be found.

aof-load-truncated yes

When rewriting the AOF file, Redis is able to use an RDB preamble in the

AOF file for faster rewrites and recoveries. When this option is turned

on the rewritten AOF file is composed of two different stanzas:

[RDB file][AOF tail]

When loading Redis recognizes that the AOF file starts with the "REDIS"

string and loads the prefixed RDB file, and continues loading the AOF

tail.

aof-use-rdb-preamble yes

Redis可以实现数据的持久化存储,即将数据保存到磁盘上。 Redis的持久化存储提供两种方式:RDB与AOF。RDB是默认配置。AOF需要手动开启。 默认是关闭AOF模式的。

如果需要开启redis的AOF持久化需要做如下配置:

appendonly yes #开启AOF模式 原文1

appendfilename "appendonly.aof" #保存数据的AOF文件名称 原文1

appendfsync always

appendfsync everysec #fsync模式 原文2

appendfsync no

no-appendfsync-on-rewrite no #原文3

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb #原文4

aof-load-truncated yes #原文5

原文1:

Redis默认采用异步的方式将数据存放到磁盘上,这个模式对大部份应用来说是足够好的,但是在Redis进程或电源发生故障的情况下,可能会造成小部份的数据丢失,这取决于配置的保存时间点。 Appendonly是一种能够提供非常好的持久化的模式,例如使用默认的Fsync方案,Redis能在发生服务器电源故障或操作系统仍然正常运行但Redis进程莫名挂掉的情况下,只丢失1秒的数据。 AOF与RDB模式可以同时启用,这并不冲突。如果AOF是可用的,那Redis启动时将自动加载AOF,这个文件能够提供更好的持久性保障。

原文2:

fsync()调用告诉操作系统将数据真实的写入磁盘而不是放到缓冲区中,一些操作系统会真实的执行请求,还有一些操作系统只会尽力的尝试。

Redis支持3种不同的模式: no:不即时同步,由操作系统控制何时刷写到磁盘上,这种模式速度最快; always:每次只写日志,速度较慢,但最安全; everysec:每秒钟同步一次,折中的方案。

默认的模式是"everysec",它通常是在速度和数据安全之间折中的方法。如果你可以控制操作系统在Redis需要的时候去刷写缓冲区那可以使用"no"模式,能够提供更好的性能(但如果你能接受一些数据丢失,可以考虑默认的持久化模式--快照方式),相反,使用"always"模式很慢,但是它比"everysec"模式要安全一点。

如果不确定,就使用"everysec"。

原文3:

当使用AOF的fsync方案设置为"always"或"everysec"时,后台的存储进程会执行大量的磁盘I/O操作,在一些Linux架构中,Redis在fsync()调用时可能会阻塞很久。这个问题当前并没有修复,即使是在一个不同的线程执行fsync也将会阻塞我们的同步写调用。

为了缓解这个问题,可以使用以下选项,它将会在有一个BGSAVE或BGREWRITEAOF正在运行时,阻止主进程调用fsync()。

这意味着有另一个子进程在存储时,Redis的持久性等同于"appendfsync none"。在实践中,意味着在最坏的情况下它可能丢失多达30秒的日志(默认的Linux设置)。

如果你有潜在的问题需要更改它为"yes"。否则从持久性的观点来看"no"是最安全的选择。

原文4:

自动重写append only文件。 当AOF日志的大小根据指定的百分比增长时,Redis会暗中调用BGREWRITEAOF去自动重写日志文件。

工作原理:Redis记忆AOF文件最后一次重写的大小(如果重启后没有重写发生,AOF的大小在启动时会被使用)。

基本大小对比当前大小。如果当前大小比指定的百分比大,触发重写。并且你要为AOF文件指定一个最小的尺寸去重写,这对于避免重写AOF文件是有用的,即使达到了百分比增长率但它仍然是非常小的。

指定百分比为0以便禁用自动AOF重写。

原文5:

可能发现一个AOF文件在Redis启动过程中被截断,当AOF数据被加载回内存时。 这可能发生在系统中Redis运行崩溃,尤其是挂载一个EXT4文件系统而没有使用"data=ordered"选项时(但是这不会发生在Redis自身崩溃或中断而操作系统仍然正常运行的时候)。

当有一个错误发生时Redis要么退出,要么加载尽可能多的数据(当前默认)启动,如果AOF文件最后发现被截断。以下选项控制这个行为。

如果aof-load-truncated被设置为"yes",一个被截断的AOF文件将会被加载,Redis服务启动发出一个日志告知用户这个事件。如果这个选项设置为"no",服务器中止一个错误并拒绝启动。当选项被设置为"no",用户需要在重启服务之前使用"redis-check-aof"功能确定AOF文件。

需要注意的是如果AOF文件被发现是损坏的,那服务器仍然会以一个错误退出。这个选项仅适用于Redis希望读取更多的数据但是没有发现足够的字节时。

4.13 LUA SCRIPTING (LUA脚本) {#413-lua-scripting-lua脚本}

# Max execution time of a Lua script in milliseconds.

#

# If the maximum execution time is reached Redis will log that a script is

# still in execution after the maximum allowed time and will start to

# reply to queries with an error.

#

# When a long running script exceeds the maximum execution time only the

# SCRIPT KILL and SHUTDOWN NOSAVE commands are available. The first can be

# used to stop a script that did not yet called write commands. The second

# is the only way to shut down the server in the case a write command was

# already issued by the script but the user doesn't want to wait for the natural

# termination of the script.

#

# Set it to 0 or a negative value for unlimited execution without warnings.

lua-time-limit 5000

设置Lua脚本的最大执行时间(以毫秒为单位)。如果达到最大执行时间,Redis将响应一个错误提示为:"脚本在最大允许时间之后仍然没有执行完",但是脚本不会停止,会继续执行。

当长时间运行的脚本超过最大执行时间时,只有SCRIPT KILL 和 SHUTDOWN NOSAVE是可用的。第一种方法可用于停止尚未调用write命令的脚本。第二种方法是在脚本已经发出写命令但用户不想等待脚本自然终止的情况下关闭服务器的唯一方法。

将其设置为0或负值,以便在没有警告的情况下无限执行。

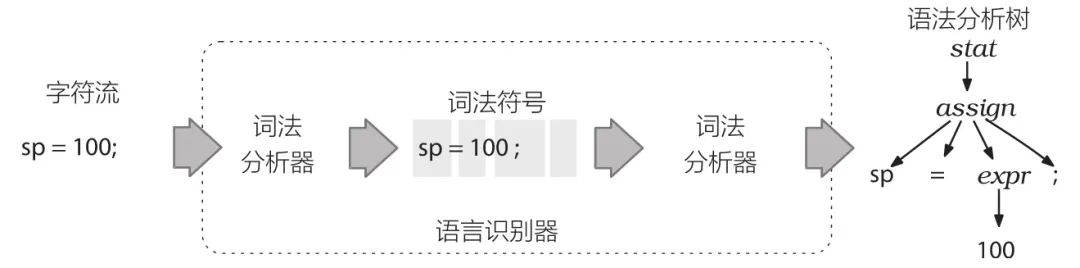

Lua 脚本功能是 Reids 2.6 版本的最大亮点, 通过内嵌对 Lua 环境的支持, Redis 解决了长久以来不能高效地处理 CAS (check-and-set)命令的缺点, 并且可以通过组合使用多个命令, 轻松实现以前很难实现或者不能高效实现的模式。

什么是LUA {#什么是lua}

Lua 是一种轻量小巧的脚本语言,用标准C语言编写并以源代码形式开放, 其设计目的是为了嵌入应用程序中,从而为应用程序提供灵活的扩展和定制功能。其设计目的是为了嵌入应用程序中,从而为应用程序提供灵活的扩展和定制功能。

LUA特性 {#lua特性}

- 轻量级: 它用标准C语言编写并以源代码形式开放,编译后仅仅一百余K,可以很方便的嵌入别的程序里。

- 可扩展: Lua提供了非常易于使用的扩展接口和机制:由宿主语言(通常是C或C++)提供这些功能,Lua可以使用它们,就像是本来就内置的功能一样。

- 其它特性:

- 支持面向过程(procedure-oriented)编程和函数式编程(functional programming);

- 自动内存管理;只提供了一种通用类型的表(table),用它可以实现数组,哈希表,集合,对象;

- 语言内置模式匹配;闭包(closure);函数也可以看做一个值;提供多线程(协同进程,并非操作系统所支持的线程)支持;

- 通过闭包和table可以很方便地支持面向对象编程所需要的一些关键机制,比如数据抽象,虚函数,继承和重载等。

初始化Lua环境 {#初始化lua环境}

在初始化 Redis 服务器时, 对 Lua 环境的初始化也会一并进行。

为了让 Lua 环境符合 Redis 脚本功能的需求, Redis 对 Lua 环境进行了一系列的修改, 包括添加函数库、更换随机函数、保护全局变量, 等等。

整个初始化 Lua 环境的步骤如下:

-

调用 lua_open 函数,创建一个新的 Lua 环境。

-

载入指定的 Lua 函数库,包括:

- 基础库(base lib)。

- 表格库(table lib)。

- 字符串库(string lib)。

- 数学库(math lib)。

- 调试库(debug lib)。

- 用于处理 JSON 对象的

cjson库。 - 在 Lua 值和 C 结构(struct)之间进行转换的

struct库(http://www.inf.puc-rio.br/~roberto/struct/)。 - 处理 MessagePack 数据的

cmsgpack库(https://github.com/antirez/lua-cmsgpack)。

-

屏蔽一些可能对 Lua 环境产生安全问题的函数,比如 loadfile 。

-

创建一个 Redis 字典,保存 Lua 脚本,并在复制(replication)脚本时使用。字典的键为 SHA1 校验和,字典的值为 Lua 脚本。

-

创建一个

redis全局表格到 Lua 环境,表格中包含了各种对 Redis 进行操作的函数,包括:

-

用于执行 Redis 命令的

redis.call和redis.pcall函数。 -

用于发送日志(log)的

redis.log函数,以及相应的日志级别(level):

redis.LOG_DEBUGredis.LOG_VERBOSEredis.LOG_NOTICEredis.LOG_WARNING

-

用于计算 SHA1 校验和的

redis.sha1hex函数。 -

用于返回错误信息的

redis.error_reply函数和redis.status_reply函数。

-

-

用 Redis 自己定义的随机生成函数,替换

math表原有的math.random函数和math.randomseed函数,新的函数具有这样的性质:每次执行 Lua 脚本时,除非显式地调用math.randomseed,否则math.random生成的伪随机数序列总是相同的。 -

创建一个对 Redis 多批量回复(multi bulk reply)进行排序的辅助函数。

-

对 Lua 环境中的全局变量进行保护,以免被传入的脚本修改。

-

因为 Redis 命令必须通过客户端来执行,所以需要在服务器状态中创建一个无网络连接的伪客户端(fake client),专门用于执行 Lua 脚本中包含的 Redis 命令:当 Lua 脚本需要执行 Redis 命令时,它通过伪客户端来向服务器发送命令请求,服务器在执行完命令之后,将结果返回给伪客户端,而伪客户端又转而将命令结果返回给 Lua 脚本。

-

将 Lua 环境的指针记录到 Redis 服务器的全局状态中,等候 Redis 的调用。

以上就是 Redis 初始化 Lua 环境的整个过程, 当这些步骤都执行完之后, Redis 就可以使用 Lua 环境来处理脚本了。

严格来说, 步骤 1 至 8 才是初始化 Lua 环境的操作, 而步骤 9 和 10 则是将 Lua 环境关联到服务器的操作, 为了按顺序观察整个初始化过程, 我们将两种操作放在了一起。

另外, 步骤 6 用于创建无副作用的脚本, 而步骤 7 则用于去除部分 Redis 命令中的不确定性(non deterministic)。

Lua教程参见 {#lua教程参见}

http://www.runoob.com/lua/lua-tutorial.html

redis使用Lua示例: {#redis使用lua示例}

在redis-cli中直接写lua脚本,非常不方便编辑,所以通常创建一个lua文件然后写lua脚本,然后执行这个lua脚本,例如:

通过lua脚本获取指定的key的List中的所有数据,创建一个lua脚本文件命名为test.lua,然后写如下代码:

local key=KEYS[1]

local list=redis.call("lrange",key,0,-1);

return list;

然后在redis中添加一个list名为persion集合:

lpush person mary jack peter

然后我们来执行这个lua脚本,下面这样:

redis> redis-cli --eval /opt/testdata/test.lua person

1) "mary"

2) "jack"

3) "peter"

4.14 REDIS CLUSTER {#414-redis-cluster}

#

# ++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

# WARNING EXPERIMENTAL: Redis Cluster is considered to be stable code, however

# in order to mark it as "mature" we need to wait for a non trivial percentage

# of users to deploy it in production.

# ++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

#

# Normal Redis instances can't be part of a Redis Cluster; only nodes that are

# started as cluster nodes can. In order to start a Redis instance as a

# cluster node enable the cluster support uncommenting the following:

#

# cluster-enabled yes

Every cluster node has a cluster configuration file. This file is not

intended to be edited by hand. It is created and updated by Redis nodes.

Every Redis Cluster node requires a different cluster configuration file.

Make sure that instances running in the same system do not have

overlapping cluster configuration file names.

cluster-config-file nodes-6379.conf

Cluster node timeout is the amount of milliseconds a node must be unreachable

for it to be considered in failure state.

Most other internal time limits are multiple of the node timeout.

cluster-node-timeout 15000

A replica of a failing master will avoid to start a failover if its data

looks too old.

There is no simple way for a replica to actually have an exact measure of

its "data age", so the following two checks are performed:

- If there are multiple replicas able to failover, they exchange messages

==========================================================================

in order to try to give an advantage to the replica with the best

replication offset (more data from the master processed).

Replicas will try to get their rank by offset, and apply to the start

of the failover a delay proportional to their rank.

- Every single replica computes the time of the last interaction with

======================================================================

its master. This can be the last ping or command received (if the master

is still in the "connected" state), or the time that elapsed since the

disconnection with the master (if the replication link is currently down).

If the last interaction is too old, the replica will not try to failover

at all.

The point "2" can be tuned by user. Specifically a replica will not perform

the failover if, since the last interaction with the master, the time

elapsed is greater than:

(node-timeout * replica-validity-factor) + repl-ping-replica-period

So for example if node-timeout is 30 seconds, and the replica-validity-factor

is 10, and assuming a default repl-ping-replica-period of 10 seconds, the

replica will not try to failover if it was not able to talk with the master

for longer than 310 seconds.

A large replica-validity-factor may allow replicas with too old data to failover

a master, while a too small value may prevent the cluster from being able to

elect a replica at all.

For maximum availability, it is possible to set the replica-validity-factor

to a value of 0, which means, that replicas will always try to failover the

master regardless of the last time they interacted with the master.

(However they'll always try to apply a delay proportional to their

offset rank).

Zero is the only value able to guarantee that when all the partitions heal

the cluster will always be able to continue.

cluster-replica-validity-factor 10

Cluster replicas are able to migrate to orphaned masters, that are masters

that are left without working replicas. This improves the cluster ability

to resist to failures as otherwise an orphaned master can't be failed over

in case of failure if it has no working replicas.

Replicas migrate to orphaned masters only if there are still at least a

given number of other working replicas for their old master. This number

is the "migration barrier". A migration barrier of 1 means that a replica

will migrate only if there is at least 1 other working replica for its master

and so forth. It usually reflects the number of replicas you want for every

master in your cluster.

Default is 1 (replicas migrate only if their masters remain with at least

one replica). To disable migration just set it to a very large value.

A value of 0 can be set but is useful only for debugging and dangerous

in production.

cluster-migration-barrier 1

By default Redis Cluster nodes stop accepting queries if they detect there

is at least an hash slot uncovered (no available node is serving it).

This way if the cluster is partially down (for example a range of hash slots

are no longer covered) all the cluster becomes, eventually, unavailable.

It automatically returns available as soon as all the slots are covered again.

However sometimes you want the subset of the cluster which is working,

to continue to accept queries for the part of the key space that is still

covered. In order to do so, just set the cluster-require-full-coverage

option to no.

cluster-require-full-coverage yes

This option, when set to yes, prevents replicas from trying to failover its

master during master failures. However the master can still perform a

manual failover, if forced to do so.

This is useful in different scenarios, especially in the case of multiple

data center operations, where we want one side to never be promoted if not

in the case of a total DC failure.

cluster-replica-no-failover no

In order to setup your cluster make sure to read the documentation

available at http://redis.io web site.

redis cluster配置 {#redis-cluster配置}

cluster-enabled yes

如果配置yes则开启集群功能,此redis实例作为集群的一个节点,否则,它是一个普通的单一的redis实例。

cluster-config-file nodes-6379.conf

虽然此配置的名字叫"集群配置文件",但是此配置文件不能人工编辑,它是集群节点自动维护的文件,主要用于记录集群中有哪些节点、他们的状态以及一些持久化参数等,方便在重启时恢复这些状态。通常是在收到请求之后这个文件就会被更新。

cluster-node-timeout 15000

这是集群中的节点能够失联的最大时间,超过这个时间,该节点就会被认为故障。如果主节点超过这个时间还是不可达,则用它的从节点将启动故障迁移,升级成主节点。注意,任何一个节点在这个时间之内如果还是没有连上大部分的主节点,则此节点将停止接收任何请求。一般设置为15秒即可。

cluster-slave-validity-factor 10

如果设置成0,则无论从节点与主节点失联多久,从节点都会尝试升级成主节点。如果设置成正数,则cluster-node-timeout乘以cluster-slave-validity-factor得到的时间,是从节点与主节点失联后,此从节点数据有效的最长时间,超过这个时间,从节点不会启动故障迁移。假设cluster-node-timeout=5,cluster-slave-validity-factor=10,则如果从节点跟主节点失联超过50秒,此从节点不能成为主节点。注意,如果此参数配置为非0,将可能出现由于某主节点失联却没有从节点能顶上的情况,从而导致集群不能正常工作,在这种情况下,只有等到原来的主节点重新回归到集群,集群才恢复运作。

cluster-migration-barrier 1

主节点需要的最小从节点数,只有达到这个数,主节点失败时,它从节点才会进行迁移。更详细介绍可以看本教程后面关于副本迁移到部分。

cluster-require-full-coverage yes

在部分key所在的节点不可用时,如果此参数设置为"yes"(默认值), 则整个集群停止接受操作;如果此参数设置为"no",则集群依然为可达节点上的key提供读操作。

4.15 CLUSTER DOCKER/NAT support {#415-cluster-dockernat-support}

# In certain deployments, Redis Cluster nodes address discovery fails, because

# addresses are NAT-ted or because ports are forwarded (the typical case is

# Docker and other containers).

#

# In order to make Redis Cluster working in such environments, a static

# configuration where each node knows its public address is needed. The

# following two options are used for this scope, and are:

#

# * cluster-announce-ip

# * cluster-announce-port

# * cluster-announce-bus-port

#

# Each instruct the node about its address, client port, and cluster message

# bus port. The information is then published in the header of the bus packets

# so that other nodes will be able to correctly map the address of the node

# publishing the information.

#

# If the above options are not used, the normal Redis Cluster auto-detection

# will be used instead.

#

# Note that when remapped, the bus port may not be at the fixed offset of

# clients port + 10000, so you can specify any port and bus-port depending

# on how they get remapped. If the bus-port is not set, a fixed offset of

# 10000 will be used as usually.

#

# Example:

#

# cluster-announce-ip 10.1.1.5

# cluster-announce-port 6379

# cluster-announce-bus-port 6380

在某些部署中,Redis集群节点地址发现失败,因为地址是NAT-ted的,或者因为端口被转发(典型的情况是Docker和其他容器)。

为了让Redis集群在这样的环境中工作,需要一个静态配置,其中每个节点都知道自己的公共地址。此范围使用以下两个选项:

cluster-announce-ip

cluster-announce-port

cluster-announce-bus-port

每个节点都指示节点的地址、客户端端口和集群消息总线端口。然后将信息发布到总线包的头部,以便其他节点能够正确映射发布信息的节点的地址。

如果不使用上述选项,则使用常规的Redis集群自动检测。注意,在重新映射时,总线端口可能不在客户机port + 10000的固定偏移量上,因此可以根据重新映射的方式指定任何端口和总线端口。如果没有设置总线端口,将像往常一样使用10000的固定偏移量。

例如:

cluster-announce-ip 10.1.1.5

cluster-announce-port 6379

cluster-announce-bus-port 6380

4.16 SLOW LOG {#416-slow-log}