简介 {#简介}

单机 & 集群 {#单机---集群}

单台Elasticsearch服务器提供服务,往往都有最大的负载能力,超过这个阈值,服务器性能就会大大降低甚至不可用,所以生产环境中,一般都是运行在指定服务器集群中。

除了负载能力,单点服务器也存在其他问题:

- 单台机器存储容量上限

- 单服务器容易出现单点故障,无法实现高可用

- 单服务的并发处理能力有限

配置服务器集群时,集群中节点数量没有限制,大于等于2个节点就可以看作是集群里。一般出于高性能及高可用方面来考虑集群中节点数量都是3个以上。

集群Cluster {#集群Cluster}

一个集群是由一个或多个服务器节点组织在一起,共同持有整个的数据,并一起提供索引和搜索功能。一个Elasticsearch集群有一个唯一的名字和标识,这个名字默认就是"elasticsearch"。这个名字是重要的,因为一个节点只能通过指定某个集群的名字,来加入这个集群。

节点Node {#节点Node}

集群中包含很多服务器,一个节点就是其中的一个服务器。作为集群的一部分,它存储数据,参与集群的索引和搜索功能。

一个节点也是由一个名字来标识的,默认情况下,这个名字是一个随机的漫威漫画角色的名字,这个名字会在启动的时候赋予节点。这个名字对于管理工作来说挺重要的,因为在这个管理过程中,你会去确定网络中的哪些服务器对应于Elasticsearch集群中的哪些节点。

一个节点可以通过配置集群名称的方式来加入一个指定的集群。默认情况下,每个节点都会被安排加入到一个叫做"elasticsearch"的集群中,这意味着,如果你在你的网络中启动了若干个节点,并假定它们能够相互发现彼此,它们将会自动地形成并加入到一个叫做"elasticsearch"的集群中。

Docker-Compose 单机部署(个人测试推荐使用) {#Docker-Compose-单机部署-个人测试推荐使用-}

启动服务 {#启动服务}

1)执行以下命令创建对应目录以及创建配置文件

mkdir elasticsearch

cd elasticsearch

2)创建docker-compose文件

vim docker-compose.yml

按 i键调成编辑模式,将以下内容复制到docker-compose.yml中,接着按esc,输入 :wq并回车进行保存。

version: '3.8'

services:

elastic:

image: elasticsearch:7.17.0

container_name: elastic

networks:

- esnet

environment:

# 开启内存锁定

- bootstrap.memory_lock=true

# 指定单节点启动

- discovery.type=single-node

- "ES_JAVA_OPTS=-Xms2g -Xmx2g"

ulimits:

# 取消内存相关限制 用于开启内存锁定

memlock:

soft: -1

hard: -1

volumes:

- ./es-config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- ./es-data:/usr/share/elasticsearch/data

- ./es-logs:/usr/share/elasticsearch/logs

- ./es-plugins:/usr/share/elasticsearch/plugins

ports:

- 9200:9200

- 9300:9300

kibana:

image: kibana:7.17.0

container_name: kibana

networks:

- esnet

environment:

ELASTICSEARCH_HOSTS: http://elastic:9200

#ELASTICSEARCH_USERNAME: elastic

# 填写es初始化时的密码

#ELASTICSEARCH_PASSWORD: changeme

I18N_LOCALE: zh-CN

volumes:

- ./kibana-data:/usr/share/kibana/data

ports:

- 5601:5601

`networks:

esnet:

`

3)创建配置文件的目录以及配置文件

mkdir es-config es-data es-logs es-plugins kibana-data

chmod -R 777 es-config es-data es-logs es-plugins kibana-data

echo -e "cluster.name: \"docker-cluster\"\nnetwork.host: 0.0.0.0" >> es-config/elasticsearch.yml

4)启动服务

# 启动服务

docker compose up -d

# 查看服务启动状态

docker ps

# 查看启动日志

docker compose logs -f

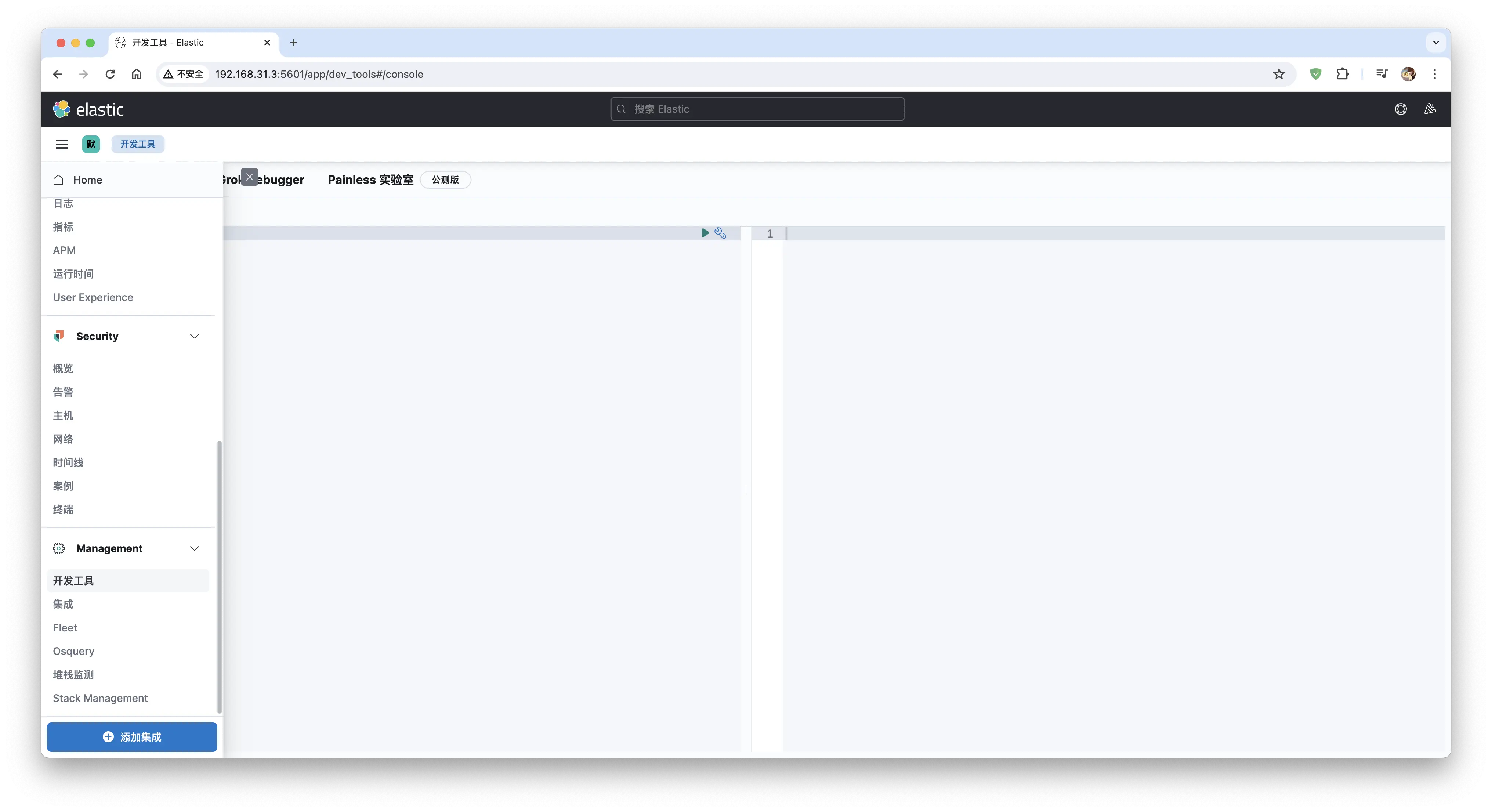

5)输入http://localhost:5601 进入kibana页面,点击左侧侧边栏的开发工具发送请求

Linux 单机部署 {#Linux-单机部署}

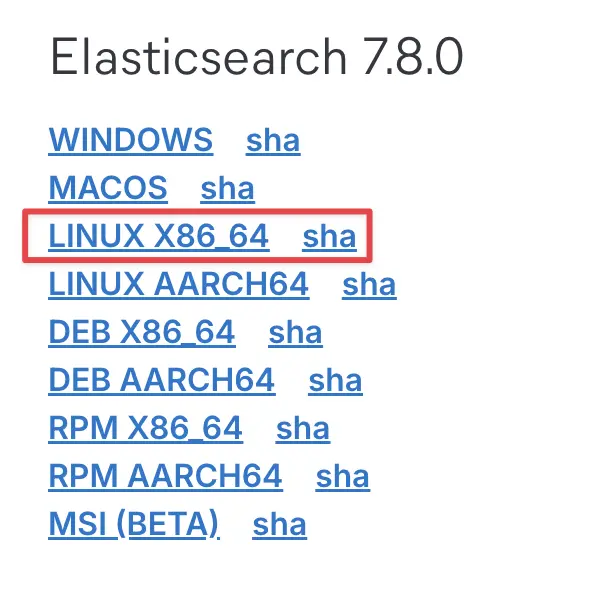

软件下载 {#软件下载}

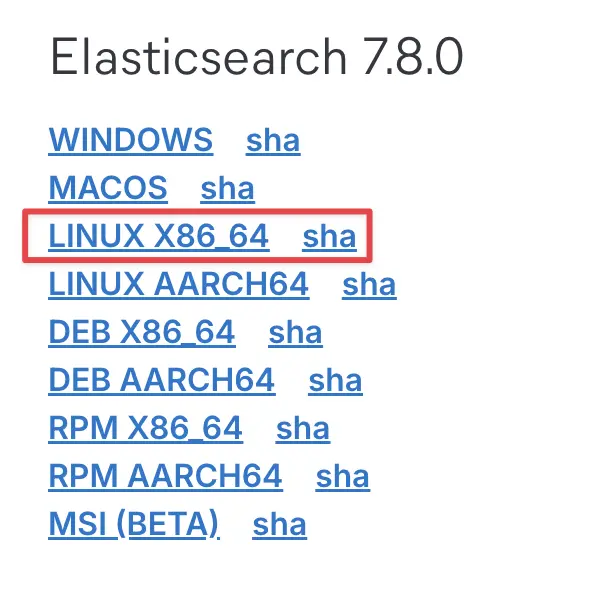

下载地址:https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7-8-0

软件安装 {#软件安装}

1)解压软件

将下载的软件解压缩

# 解压缩

tar -zxvf elasticsearch-7.8.0-linux-x86_64.tar.gz -C /opt/module

# 改名

mv elasticsearch-7.8.0 es

2)创建用户

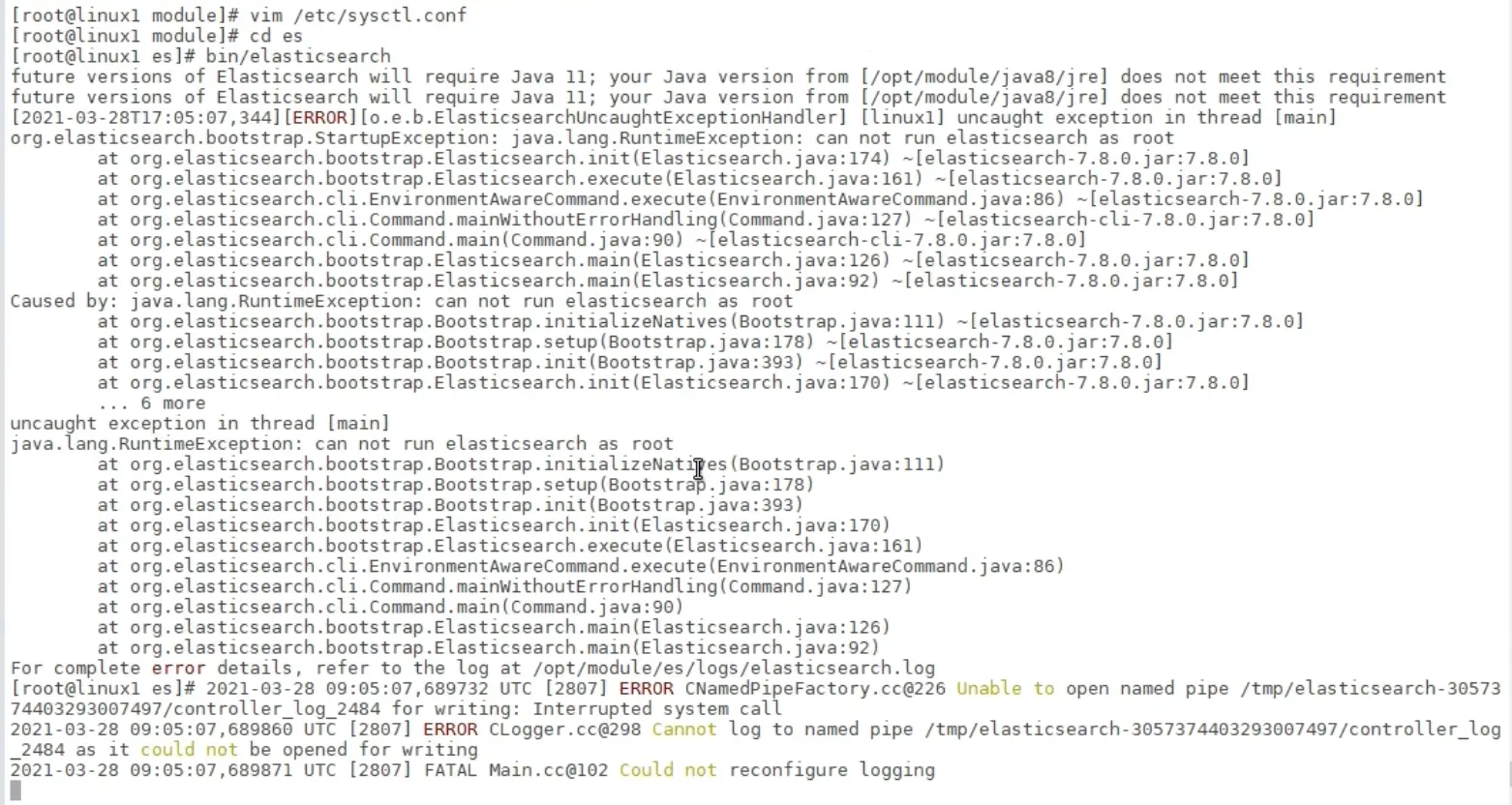

因为安全问题,elasticsearch不允许root用户直接运行,所以要创建新用户,在root用户中创建新用户

useradd es # 新增es用户

passwd es # 为es用户设置密码

`userdel -r es # 如果错了,可以删除再加

chown -R es:es /opt/module/es # 文件夹所有者

`

3)修改配置文件

修改/opt/module/es/config/elasticsearch.yml文件

# 加入如下配置

cluster.name: lasticsearch

node.name: node-1

network.host: 0.0.0.0

http.port: 9200

cluster.initial_master_nodes: ["node-1"]

修改/etc/security/limits.conf

# 在文件末尾中增加下面内容

# 每个进程可以打开的文件数的限制

es soft nofile 65536

es hard nofile 65536

修改/etc/security/limits.d/20-nproc.conf

# 在文件末尾中增加下面内容

# 每个进程可以打开的文件数的限制

es soft nofile 65536

es hard nofile 65536

# 操作系统级别对每个用户创建的进程数的限制

* hard nproc 4096

# 注: * 带表 Linux 所有用户名称

修改/etc/sysctl.conf

# 在文件中增加下面内容

# 一个进程可以拥有的 VMA(虚拟内存区域)的数量,默认值为 65536

vm.max_map_count=655360

重新加载

sysctl -p

启动软件 {#启动软件}

使用 ES 用户启动

cd /opt/module/es/

#启动

bin/elasticsearch

#后台启动

bin/elasticsearch -d

启动时,会动态生成文件,如果文件所属用户不匹配,会发生错误,需要重新进行修改用户和用户组

执行以下命令

su root

chown -R es:es /opt/module/es

su es

Linux集群部署 {#Linux集群部署}

软件下载 {#软件下载-}

下载地址:https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7-8-0

软件安装 {#软件安装-}

1)解压软件

# 解压缩

tar -zxvf elasticsearch-7.8.0-linux-x86_64.tar.gz -C /opt/module

# 改名

mv elasticsearch-7.8.0 es-cluster

在其他节点执行相同的操作:linux2, linux3

2)创建用户

因为安全问题,elasticsearch不允许root用户直接运行,所以要在每个节点中创建新用户,在root用户中创建新用户

useradd es # 新增es用户

passwd es # 为es用户设置密码

`userdel -r es # 如果错了,可以删除再加

chown -R es:es /opt/module/es-cluster # 文件夹所有者

`

3)修改配置文件(每个节点相同操作)

修改/opt/module/es/config/elasticsearch.yml 文件,分发文件。

# 加入如下配置

#集群名称

cluster.name: cluster-es

#节点名称, 每个节点的名称不能重复

node.name: node-1

#ip 地址, 每个节点的地址不能重复(改成对应节点ip)

network.host: linux1

#是不是有资格主节点

node.master: true

node.data: true

http.port: 9200

# head 插件需要这打开这两个配置

http.cors.allow-origin: "*"

http.cors.enabled: true

http.max_content_length: 200mb

#es7.x 之后新增的配置,初始化一个新的集群时需要此配置来选举 master

cluster.initial_master_nodes: ["node-1"]

#es7.x 之后新增的配置,节点发现(如果没有配置linux1、linux2这些域名,则改成对应节点ip)

discovery.seed_hosts: ["linux1:9300","linux2:9300","linux3:9300"]

gateway.recover_after_nodes: 2

network.tcp.keep_alive: true

network.tcp.no_delay: true

transport.tcp.compress: true

#集群内同时启动的数据任务个数,默认是 2 个

cluster.routing.allocation.cluster_concurrent_rebalance: 16

#添加或删除节点及负载均衡时并发恢复的线程个数,默认 4 个

cluster.routing.allocation.node_concurrent_recoveries: 16

#初始化数据恢复时,并发恢复线程的个数,默认 4 个

cluster.routing.allocation.node_initial_primaries_recoveries: 16

修改/etc/security/limits.conf ,分发文件

# 在文件末尾中增加下面内容

es soft nofile 65536

es hard nofile 65536

修改/etc/security/limits.d/20-nproc.conf,分发文件

# 在文件末尾中增加下面内容

es soft nofile 65536

es hard nofile 65536

\* hard nproc 4096

\# 注: * 带表 Linux 所有用户名称

修改/etc/sysctl.conf

# 在文件中增加下面内容

vm.max_map_count=655360

重新加载

sysctl -p

启动软件 {#启动软件-}

分别在不同节点上启动ES软件

cd /opt/module/es-cluster

#启动

bin/elasticsearch

#后台启动

bin/elasticsearch -d

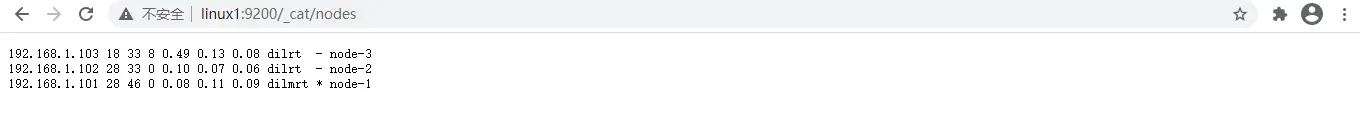

测试集群 {#测试集群}

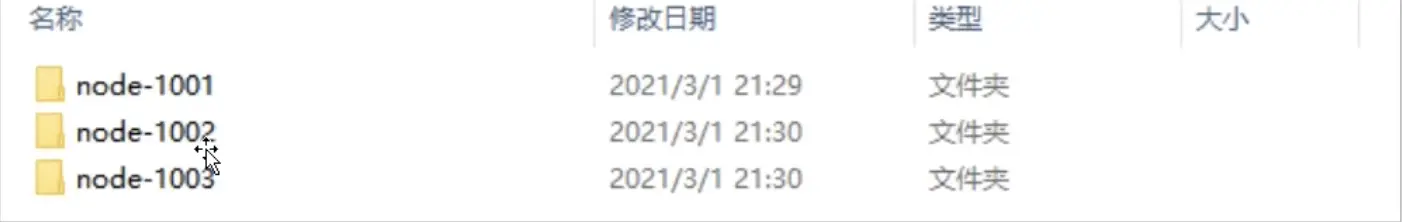

Windows集群部署 {#Windows集群部署}

1)创建elasticsearch-cluster文件夹,在内部复制三个elasticsearch服务

下载地址:https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7-8-0

2)修改集群文件目录中每个节点的config/elasticsearch.yml配置文件

node-1001

# 集群名称,节点之间要保持一致

cluster.name: my-elasticsearch

# 节点名称,集群内要唯一

node.name: node-1001

node.master: true

node.data: true

ip地址

====

network.host: localhost

http端口

======

http.port: 9201

tcp监听端口

=======

transport.tcp.port: 9301

discovery.seed_hosts: \["localhost:9301", "localhost:9302","localhost:9303"\]

=============================================================================

discovery.zen.fd.ping_timeout: 1m

=================================

discovery.zen.fd.ping_retries: 5

================================

集群内的可以被选为主节点的节点列表

=================

#cluster.initial_master_nodes: \["node-1", "node-2","node-3"\]

跨域配置

====

action.destructive_requires_name: true

======================================

`http.cors.enabled: true

http.cors.allow-origin: "*"

`

node-1002

# 集群名称,节点之间要保持一致

cluster.name: my-elasticsearch

# 节点名称,集群内要唯一

node.name: node-1002

node.master: true

node.data: true

ip地址

====

network.host: localhost

http端口

======

http.port: 9202

tcp监听端口

=======

transport.tcp.port: 9302

相比第一个节点,其他节点需要增加这个配置用来发现主节点

===========================

discovery.seed_hosts: \["localhost:9301"\]

discovery.zen.fd.ping_timeout: 1m

discovery.zen.fd.ping_retries: 5

集群内的可以被选为主节点的节点列表

=================

#cluster.initial_master_nodes: \["node-1", "node-2","node-3"\]

跨域配置

====

action.destructive_requires_name: true

======================================

`http.cors.enabled: true

http.cors.allow-origin: "*"

`

node-1002

# 集群名称,节点之间要保持一致

cluster.name: my-elasticsearch

# 节点名称,集群内要唯一

node.name: node-1003

node.master: true

node.data: true

ip地址

====

network.host: localhost

http端口

======

http.port: 9203

tcp监听端口

=======

transport.tcp.port: 9303

相比第一个节点,其他节点需要增加这个配置用来发现主节点

===========================

discovery.seed_hosts: \["localhost:9301", "localhost:9302"\]

discovery.zen.fd.ping_timeout: 1m

discovery.zen.fd.ping_retries: 5

集群内的可以被选为主节点的节点列表

=================

#cluster.initial_master_nodes: \["node-1", "node-2","node-3"\]

跨域配置

====

action.destructive_requires_name: true

======================================

`http.cors.enabled: true

http.cors.allow-origin: "*"

`

3)启动集群节点

依次执行三个节点文件夹下bin/elasticsearch.bat文件

4)查看集群信息

GET http://localhost:9201/_cluster/health

51工具盒子

51工具盒子