继上次分享完SEO优化的文章后,还没阅读过的可以去了解下:

今天继续分享一篇关于网站SEO优化的文章。主题是:关于重复性内容6个注意点。

当你的网站许多页面被标记为彼此重复时,你该如何解决?本质上,重复内容是出现在Internet上多个位置的内容。太相似的内容,即使不完全相同,也可能被视为彼此重复。

重复内容发生在以下两种情况:

一是访问者在访问您的网站并比较两个页面时看到的内容;

二是搜索引擎和搜寻器访问这些页面时看到的内容和源代码,如果该代码过于相似,则搜寻器可能会认为它正在查看同一页面的两个版本。

负面影响是搜索引擎可能无法弄清楚应该对哪个页面进行排名,排除哪个页面,或者对不正确的页面进行排名,也不知道要将定向链接指标(信任,权限,锚文本,链接等)定向到一个页面,或将其分隔在多个版本之间。

解决商城重复性内容的6种方式:

1. 301重定向

这个是比较基础的方法应用于解决重复页面,可以将页面的旧版本重定向到新的更新版本。这与子域或协议更改以及内容更新有关。

2. Rel=规范

两个页面重复度较高时,可以在其中一个不打算给予排名的页面代码头部加上rel = canonicals选项,告知搜寻器哪个是最重要的页面,但不影响用户对两个页面的访问。

这类似于出售两种颜色不同的商品。您希望访客能够看到和访问这两种颜色,但是您将使用规范的标签来告诉爬虫哪些是最相关的页面。

格式为:(在html的部分)

rel = canonical属性应添加到页面的每个重复版本的HTML头中,上面的" URL OF ORIGINAL PAGE"部分应替换为指向原始(规范)页面的链接。(请确保保留引号。)该属性传递的链接公平性(排名能力)与301重定向大致相同,并且由于它是在页面(而不是服务器)级别实现的,因此通常只需较少的开发时间即可实行。

3. 元索引

如果同一个主题内容有两个页面A,B版本,你更推荐B是最新且最相关的,但希望A版本仍然是可以阅读的,那可以选择将A页面标记为meta noindex。

元noindex标记告诉抓取工具可以抓取重复的页面,但不应将其包含在索引中。这可以帮助解决由于分页等原因造成的重复内容问题。

格式为:(在html的部分,对重复的页面加上这段代码)

meta robots标签允许搜索引擎抓取页面上的链接,但阻止它们将这些链接包括在索引中。但您即使告诉Google不要对其进行索引,仍然要保障他们可以对重复页面进行爬网,因为Google明确警告不要限制对网站上重复内容的爬网访问。

4. 添加内容

如果两个页面涉及不同的主题,但却被判断为重复页面,这种情况,可以选择向这些页面中的每个页面添加更多内容,使不同的主题都可以脱颖而出。

这类似于说在一个纸杯蛋糕上撒些巧克力和樱桃,而在另一个纸杯蛋糕上添加另一种颜色的糖霜。

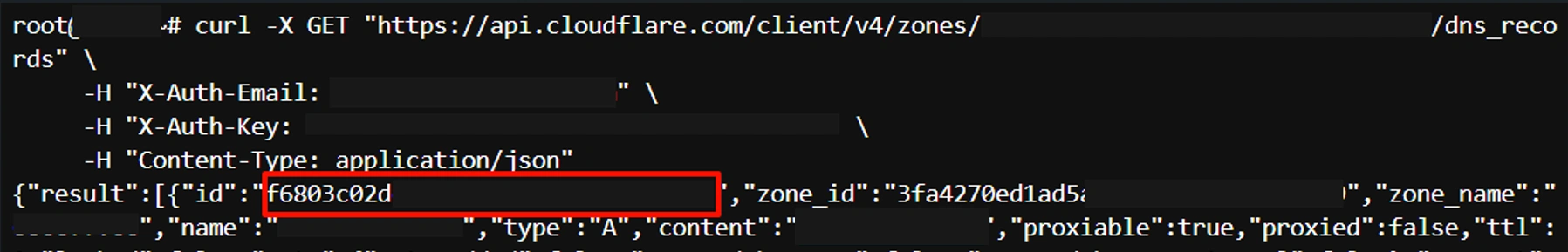

5. URL变体

URL参数(例如点击跟踪和一些分析代码)可能会导致重复的内容问题。不仅由参数本身引起,而且还由这些参数在URL本身中出现的顺序引起的问题。

支持打印的内容页面也可能会造成重复页面:

解决方法:避免添加URL参数或URL的备用版本,通常可以通过脚本传递这些信息。

6. HTTP与HTTPS或WWW与非WWW页面

如果"www.jiangweishan.com" 和"jiangweishan.com"上具有单独的版本,http:// 和https:// 版本的网站版本都是实时的并且对搜索引擎可见,则可能会遇到重复的内容问题。

解决方法是保持域名的唯一性,https://www.jiangweishan.com/ 的唯一,其他的版本都跳转到这里。

51工具盒子

51工具盒子