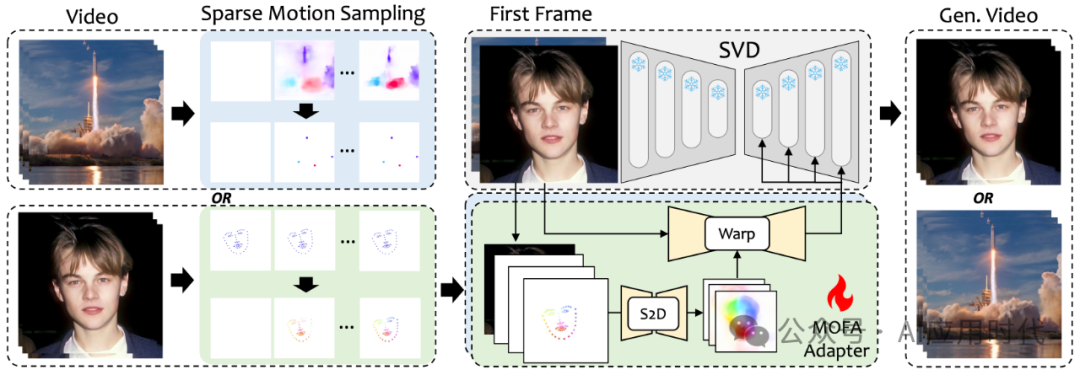

MOFA-Video是一种由腾讯A1实验室和东京大学的研究人员共同开源的图像生成视频模型。该技术通过生成运动场适应器将静态图像动画化,从而生成视频。基于预训练的Stable VideoDiffusion模型,MOFA-Video能够通过稀疏控制信号(如手动轨迹、面部标记序列或音频等)实现对视频生成过程中动作的精细控制。这些控制信号不仅可以单独使用,还可以组合使用,以零样本(zero-shot)的方式进行复杂的动画制作,提供了一种全新且高度可控的图像动画视频解决方案。

功能特色

轨迹控制动画

用户可以通过在图像上手动绘制轨迹,指导MOFA-Video生成相应的视频动画。这种功能特别适用于需要精确控制物体或相机运动的场景。

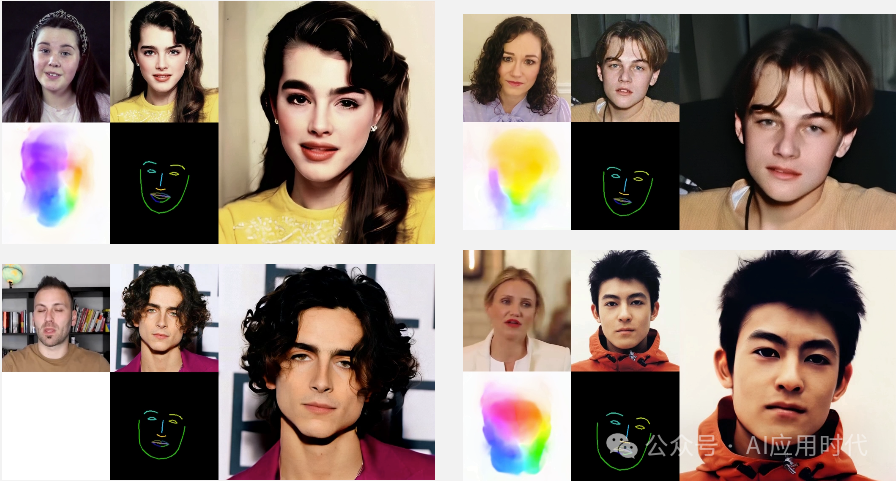

面部关键点动画

系统利用面部关键点数据(例如通过面部识别技术获得的标记)来生成逼真的面部表情和头部动作动画。

混合控制动画

MOFA-Video能够将轨迹控制和面部关键点控制相结合,实现面部表情和身体动作的同步动画,创造出复杂的多部分动画效果。

音频驱动面部动画

通过分析音频信号,MOFA-Video能够生成与语音或音乐同步的面部动画,例如口型同步。

视频驱动面部动画

使用参考视频,MOFA-Video能够使静态图像中的面部动作模仿视频中的动作,实现动态的面部表情再现。

零样本多模态控制

MOFA-Video支持零样本学习,不同控制信号可以无需额外训练即可组合使用,这大大提高了动画生成的灵活性和多样性。

长视频生成能力

通过采用周期性采样策略,MOFA-Video能够生成比传统模型更长的视频动画,突破了帧数限制。

用户界面操作

MOFA-Video提供了基于Gradio的简单易用的用户界面,用户可以通过这个界面直观地进行动画生成,无需具备专业的编程技能。

工作原理

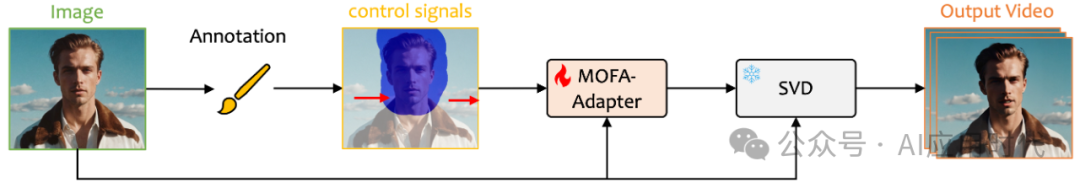

MOFA-Video动画生成技术概述

- 稀疏控制信号生成

在训练阶段,系统通过稀疏运动采样技术生成稀疏控制信号。这些信号可能包括基于轨迹的动画控制点、面部关键点序列或其他形式的运动指示。

- MOFA-Adapter设计

MOFA-Adapter是系统的核心组件,用于将稀疏控制信号转换为密集的运动场。其主要组成部分包括:

-

S2D网络:将稀疏的运动提示转换为密集的运动场。

-

参考图像编码器:提取参考图像的多尺度特征,用于生成运动场。

-

特征融合编码器:将S2D网络生成的运动场与参考图像编码器的特征结合。

- 多尺度特征提取

参考图像编码器处理输入的参考图像,提取多尺度的特征表示,这些特征将在视频帧生成过程中提供引导和变形。

- 运动场的生成与应用

S2D网络根据稀疏控制信号生成密集的运动场,这些运动场用于对多尺度特征进行空间变形,以模拟视频中的运动效果。

- 预训练的SVD模型

MOFA-Adapter与预训练的Stable Video Diffusion模型(SVD)结合,利用从MOFA-Adapter获得的条件特征来引导视频帧的生成。

- 空间变形

利用生成的运动场,系统对参考图像的多尺度特征进行空间变形,确保视频帧中的物体和场景元素按照预定的运动轨迹移动。

- 视频帧生成

在特征空间中经过变形的特征被用于生成视频帧。这一过程涉及从潜在空间中采样并逐步去除噪声,以重建清晰的视频帧。

- 多模态控制信号集成

MOFA-Video能够处理来自不同源的控制信号,并将它们融合到统一的生成过程中,实现复杂的动画效果。

- 零样本学习

MOFA-Adapter训练完成后,可以在不同控制域中无需额外训练即可联合工作,实现对视频生成的精细控制。

- 长视频生成策略

为了生成更长的视频,MOFA-Video采用周期性采样策略,通过在潜在空间中对帧进行分组和重新采样,解决长视频生成中的连贯性和计算复杂性问题。

项目地址

官网:https://myniuuu.github.io/MOFA_Video/

github: https://github.com/MyNiuuu/MOFA-Video

51工具盒子

51工具盒子