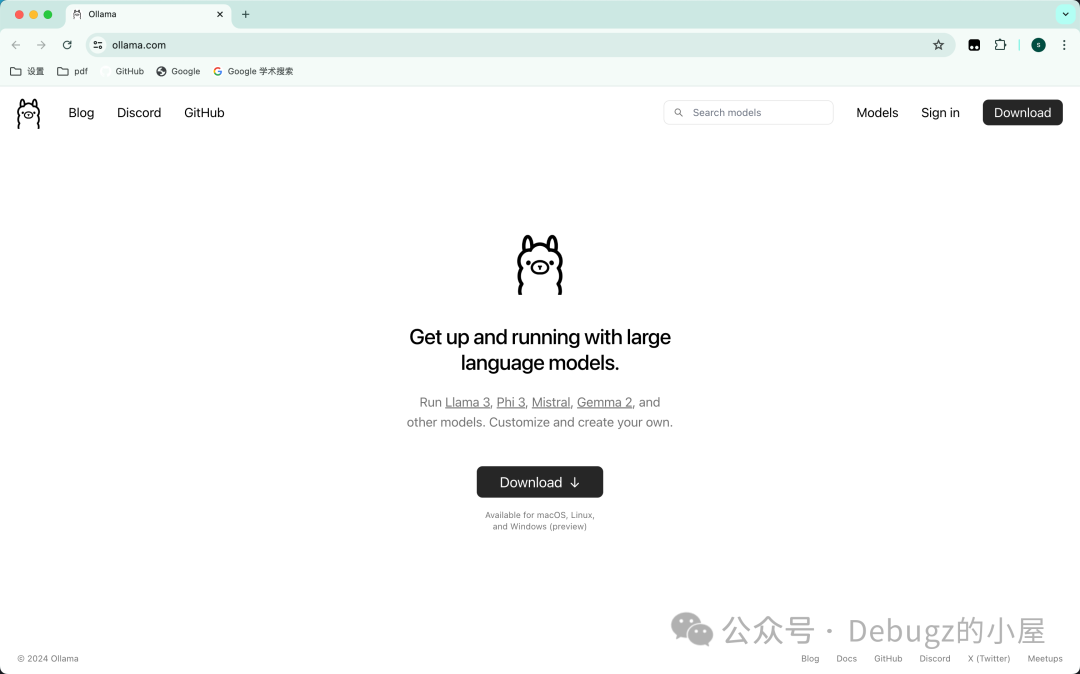

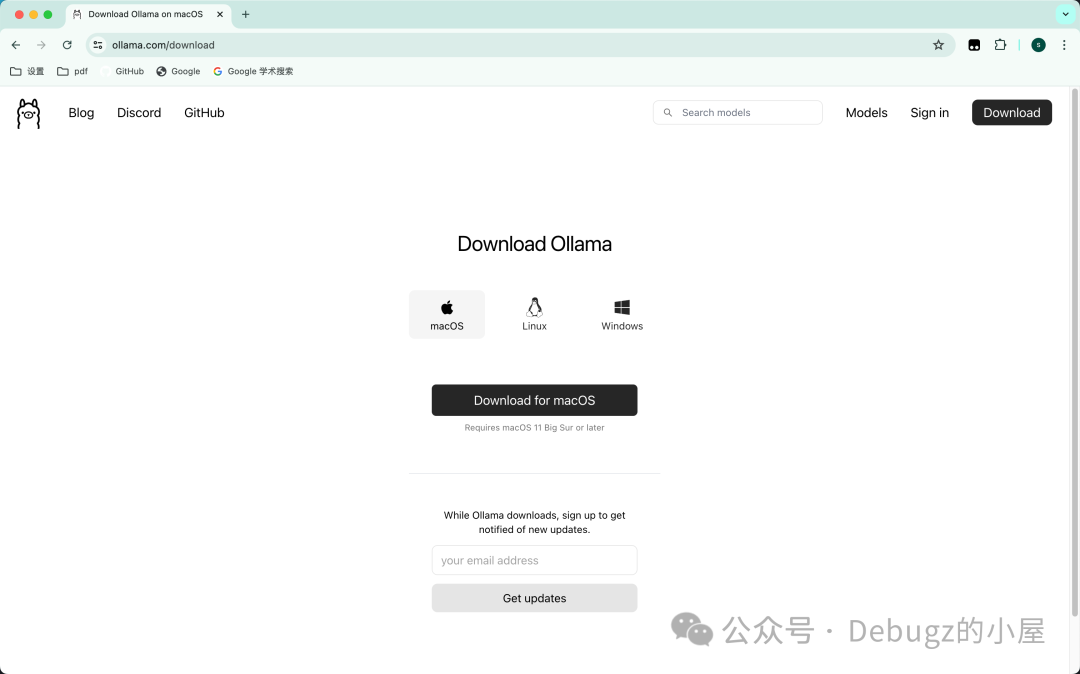

- Ollama的安装

官网地址:Ollama

选择适合自己的系统并下载安装包进行安装即可

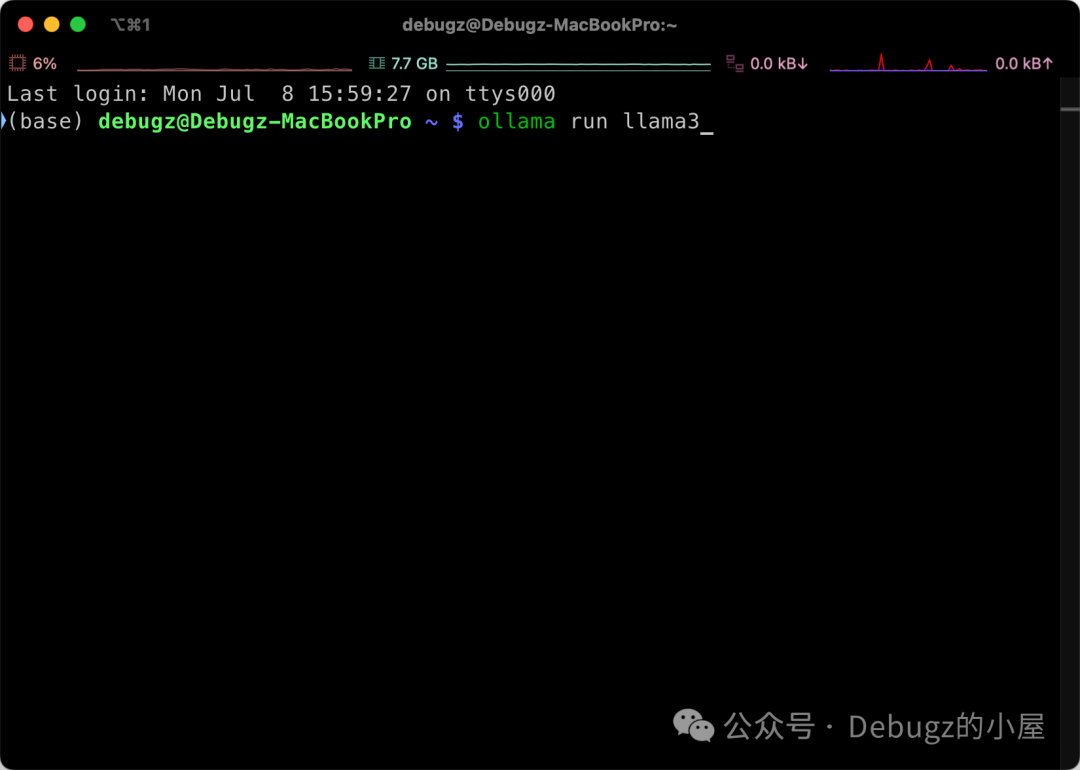

- 下载模型,本地部署

打开终端,输入 *

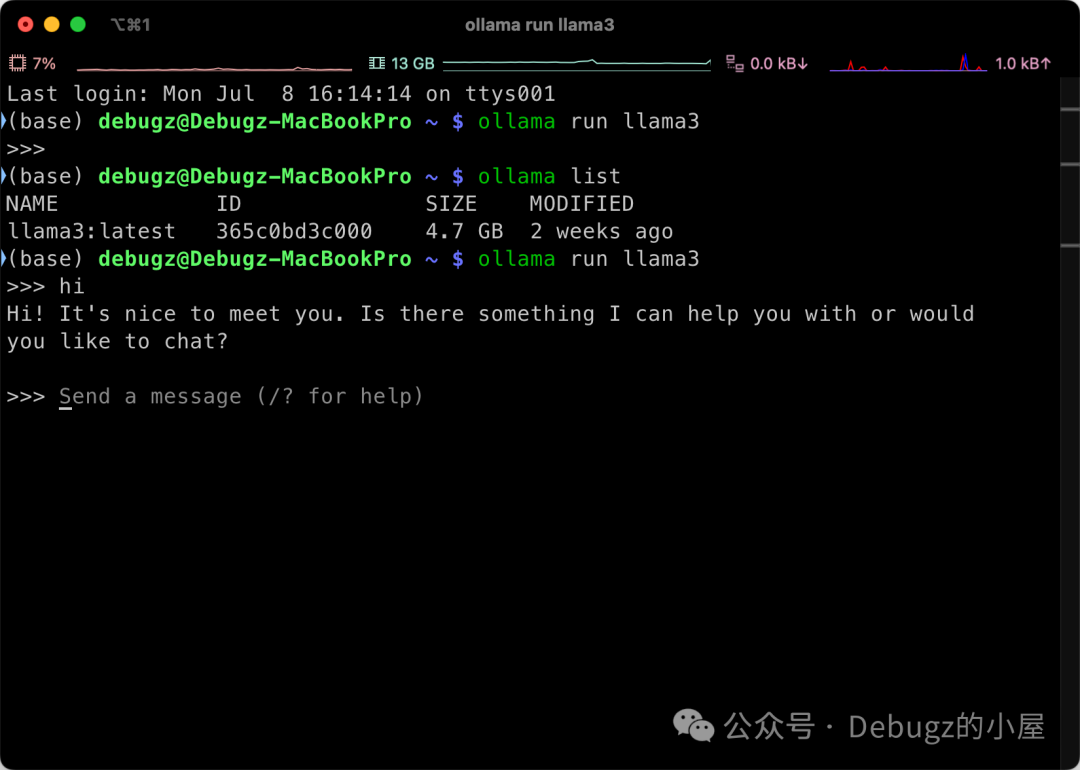

ollama run llama3

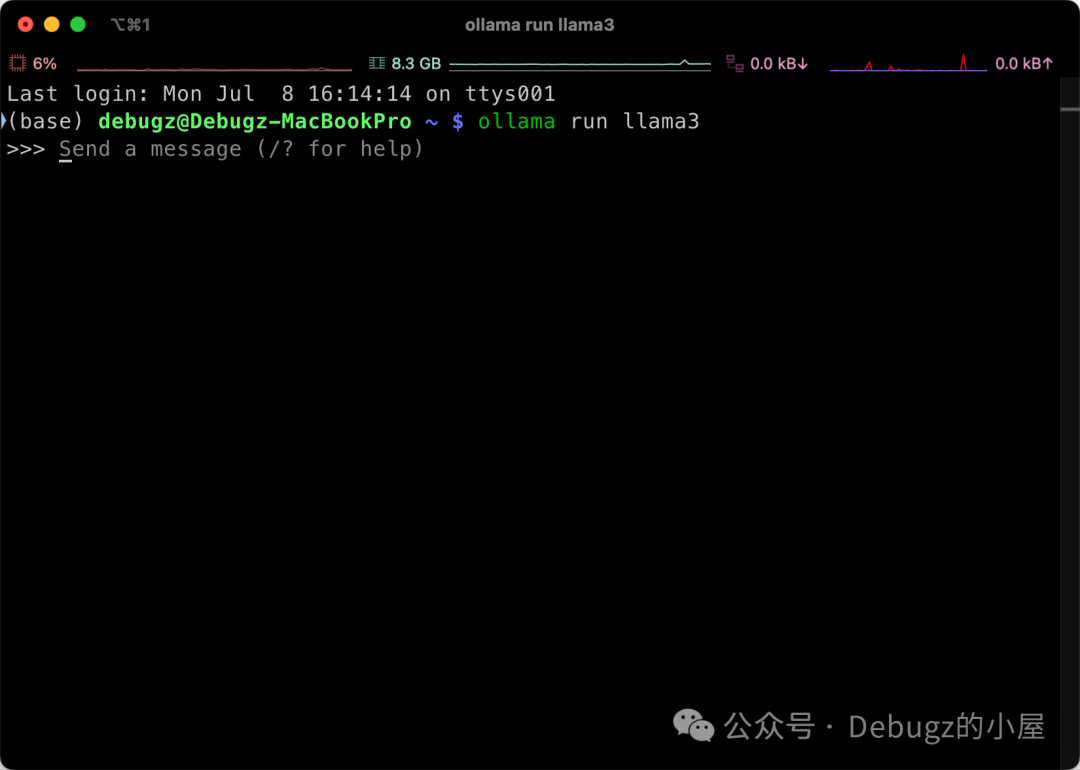

第一次使用,ollama会进行模型的下载,等待模型下载完成,弹出以下内容即可使用

如果你要部署其他模型,在ollama run命令后加上你需要部署的模型名称即可

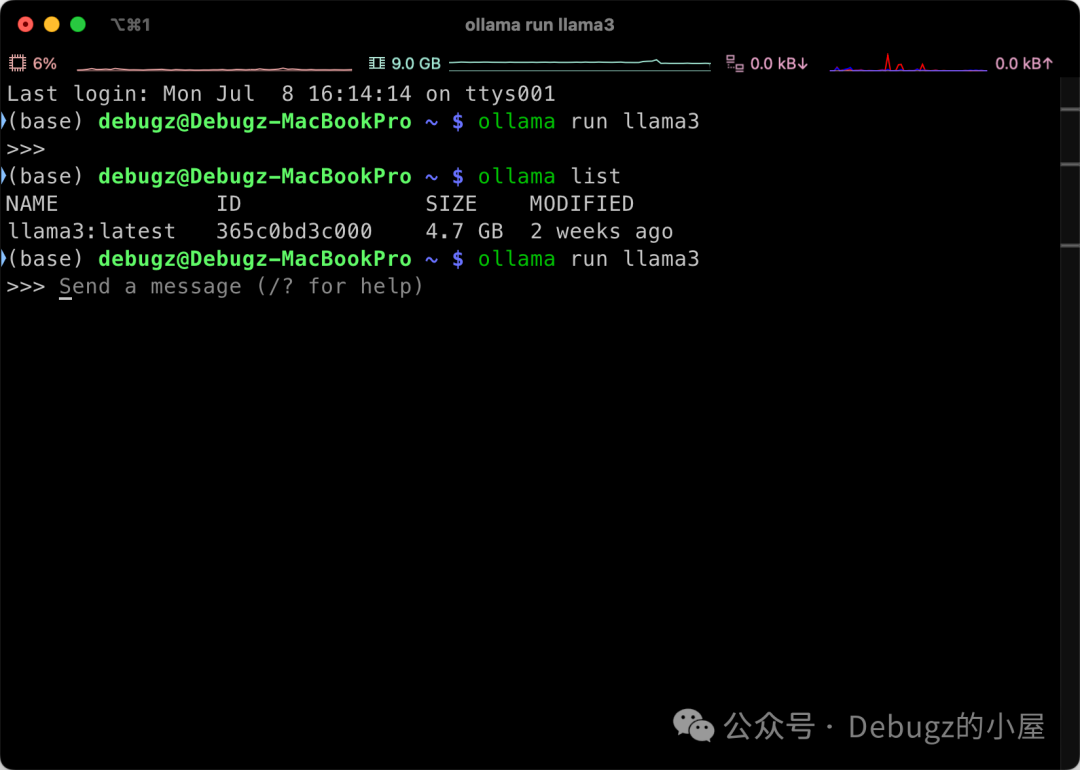

ollama常用命令

*

*

*

*

ollama list # 显示当前已经部署的大模型ollama rm <model_name> # 删除部署的大模型ollama run <model_name> # 运行大模型ollama create <model_name> -f <model_file> # 创建大模型

ollama可部署的模型列表见library (ollama.com)

- 配置需求

本机配置:Macbook Pro M3pro(11CPUs,14GPUs),18+512

测试问题占用内存约4GB

- 可视化聊天界面

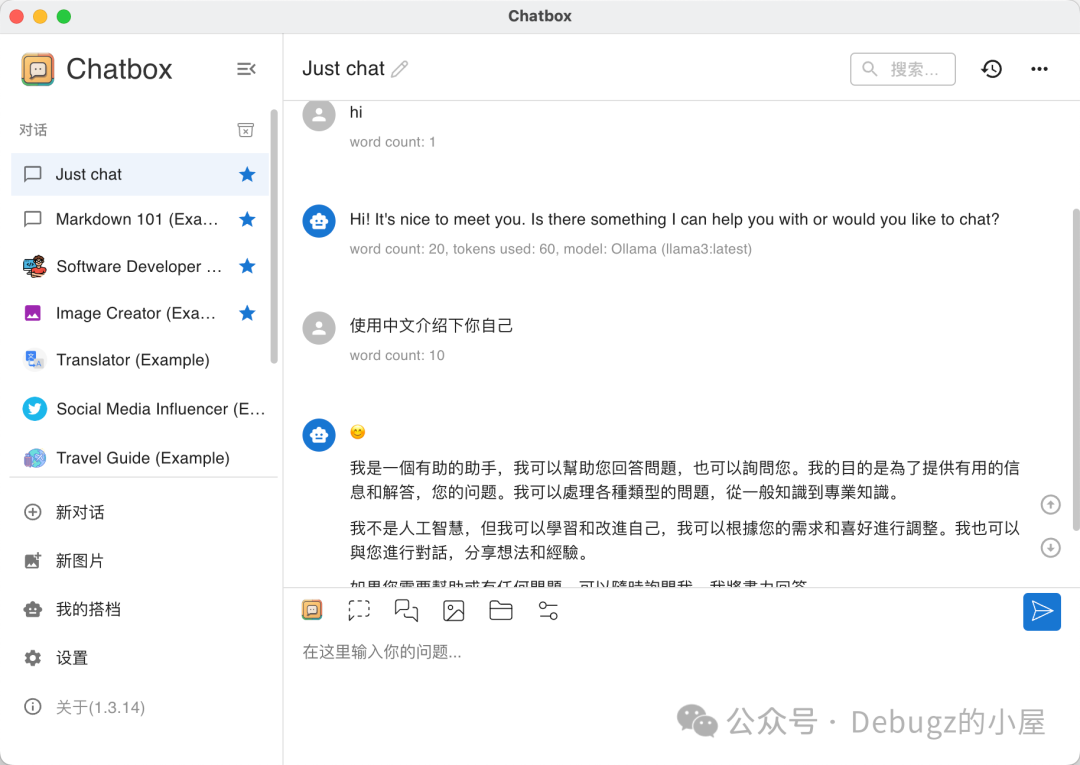

使用Chatbox进行部署:Chatbox

选择合适的版本进行安装下载

设置模型提供方为Ollama,API域名以及模型,可以修改上下文消息数量限制、模型严谨程度(想象力)等等

建议使用英文进行提问,中文需求可以使用针对中文语料微调的llama3

51工具盒子

51工具盒子