大家好,我是袋鼠帝,今天又来给大家更新喂饭级教程了,之前更新的kimi接入个人微信 ,以及GPT4o接入个人微信 ,有好些朋友留言说信息不安全,确实,这样做信息最终都会发送给大模型厂商。 那么有没有什么办法能把AI接入个人微信的同时保证数据安全呢?

那就是使用本地私有化部署的开源大模型 。到时候直接调用自己本地大模型,不就安全了吗 。而且回复速度非常快 ,关键是**免费!**为开源点赞!

我会将开源AI接入个人微信再做一个系列 ,分几章还没想好,不过分多章对于我来说有利于把每篇文章写的更详细。

并且这个系列是讲开源AI,除了开源大模型之外还有很多开源AI工具,如果你对这块内容感兴趣不妨先点个关注~

今天给大家带来的就是第一章(开源大模型接入个人微信的准备工作)

利用ollama 本地部署开源大模型的喂饭级教程。耐心看完,你一定有所收获~

最终呈现的效果如下:

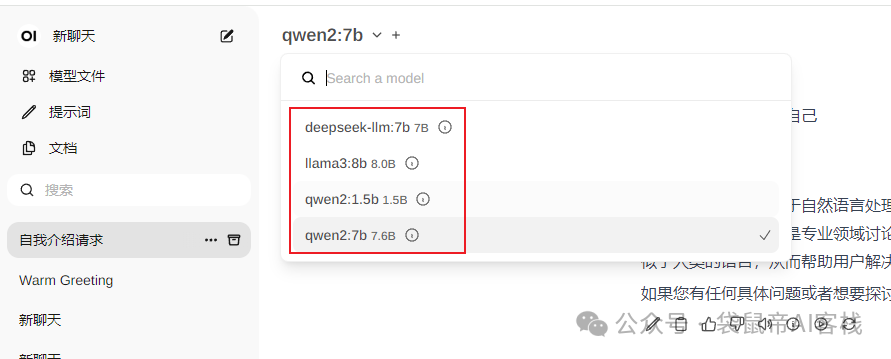

这里用的是qwen2:7b参数的大模型:

并且还可以随意切换多种开源大模型 (有meta的llama3 ,阿里最新的qwen2 ,还有号称中文能力最强的deepseek ,谷歌的gemma ,黑马模型mistral ,以及一些vision类模型 等 几十种开源大模型可选择):

其实部署一个本地大模型,还是很困难的,你要去解决复杂的环境问题,以及有各种繁琐的操作。

不过现如今已经有了一个非常方便的开源工具。

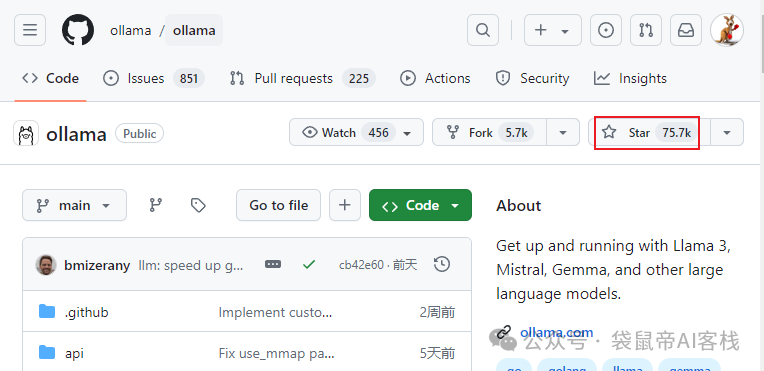

一个简明易用的本地大模型运行框架:ollama (一个在github斩获75k star的超级项目,足见它的受欢迎程度)

ollama的优点 1.提供命令行操作,提供模型调用的api接口; 2.超多开源大模型选择:https://ollama.com/library 3.对模型的运行、推理进行了优化,能更充分的发挥GPU的性能; 4.支持多个平台,windows,mac,linux等。

ollama的优点 1.提供命令行操作,提供模型调用的api接口; 2.超多开源大模型选择:https://ollama.com/library 3.对模型的运行、推理进行了优化,能更充分的发挥GPU的性能; 4.支持多个平台,windows,mac,linux等。

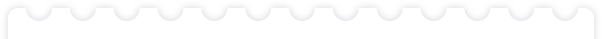

不过ollama 只是集成了命令行操作,要想达到上图中更方便的界面操作效果,还需要另外一个开源工具:open-webui

同样也是一个超级受欢迎,斩获了29k star的AI WebUI项目

ollama + open-webui可谓是强强联手,让你即能在本地快速安装超多的开源大模型。又能通过webui界面更方便的操作使用它们。

好了,下面开始"喂饭"!

一、安装ollama

一、安装ollama

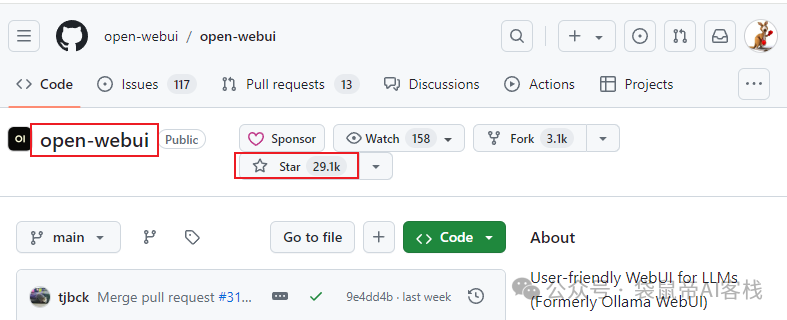

我以win10为例来带大家操作(其他平台也是类似的)

首先进入ollama官网 下载支持windows的安装包

地址:https://ollama.com/download

地址:https://ollama.com/download

下载之后是一个.exe可执行文件,双击安装即可。

ollama在各个平台下的默认模型存储路径:

ollama在各个平台下的默认模型存储路径:

mac:~/.ollama/models

Linux:/usr/share/ollama/.ollama/models

**windows:**C:\Users\%username%\.ollama\models

在windows中因为ollama默认是把模型下载到c盘 ,所以安装完成之后我们先更改一下模型安装目录,否则大家c盘容易满,因为一个模型就要好几G。

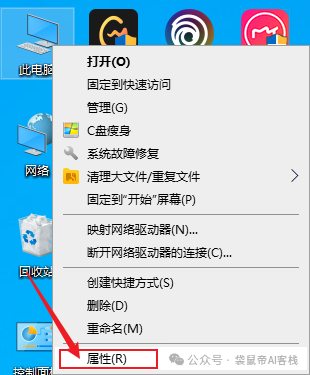

右键 此电脑->属性

高级系统设置

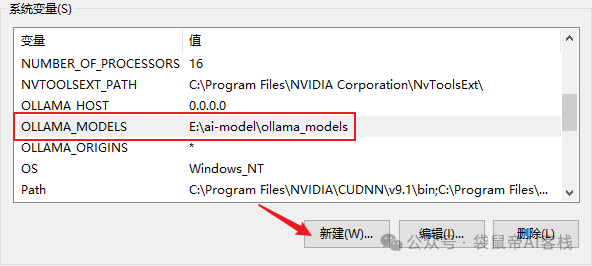

环境变量

在系统变量添加 OLLAMA_MODELS,值就是你模型想要存放的路径(最后点击确认->确认)

ollama的常用命令 如下: * * * * * * * * * *

ollama serve 启动ollamaollama create 从模型文件创建模型ollama show 显示模型信息ollama run 运行模型ollama pull 从注册表中拉取模型ollama push 将模型推送到注册表ollama list 列出模型ollama cp 复制模型ollama rm 删除模型ollama help 获取有关任何命令的帮助信息

接下来我们启动ollama

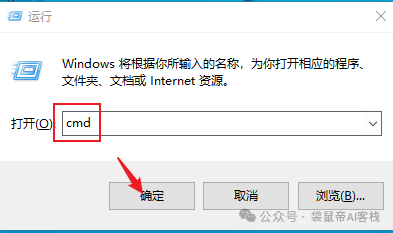

使用win + r 输入cmd然后回车,打开windows控制台

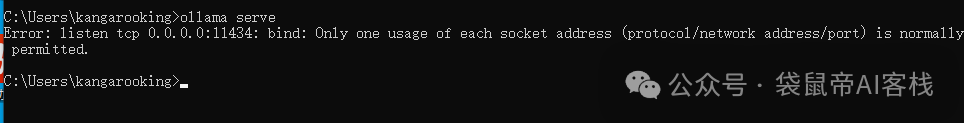

在控制台输入ollama的启动命令: ollama serve(这里我已经启动过了,所以有个报错)

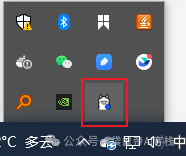

启动ollama后,能在右下角看到ollama羊驼的一个图标(没有的话请重启电脑):

到这里本地的ollama就安装好了。

二、安装open-webui

二、安装open-webui

open-webui 可以用docker非常方便的一键部署。

不清楚docker如何安装使用的朋友请看我之前的文章(或者自行搜索一下)

docker部署教程 公众号:袋鼠帝AI客栈Ollama一键部署!开源部署神器:docker-desktop,小白也能轻松上手~

open-webui项目地址:https://github.com/open-webui/open-webui

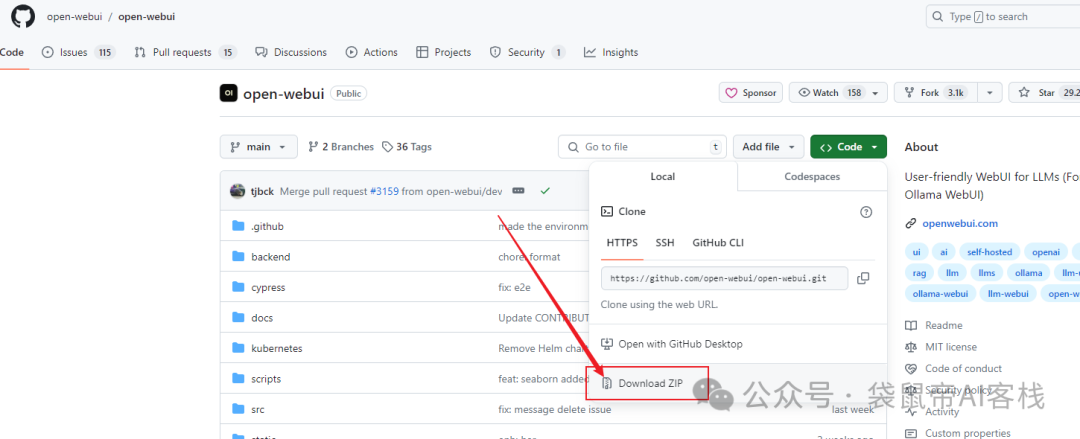

还是老规矩,进入项目页面,下载open-webui源码包

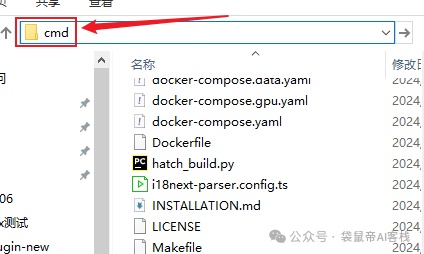

解压源码包后,进入项目根目录 (docker-compose.yaml文件所在目录)

解压源码包后,进入项目根目录 (docker-compose.yaml文件所在目录)

在路径栏输入cmd 然后回车,即可进入当前目录的控制台

在路径栏输入cmd 然后回车,即可进入当前目录的控制台

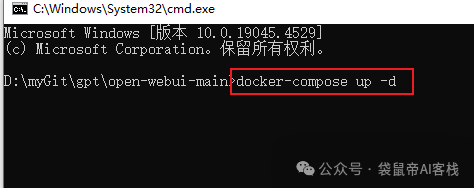

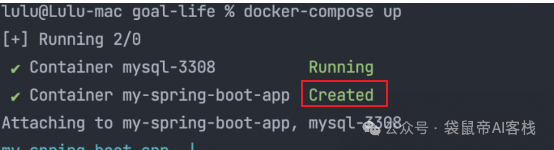

在windows控制台执行docker-compose up -d 以启动项目(我的之前部署过了,就不重新部署了)

在windows控制台执行docker-compose up -d 以启动项目(我的之前部署过了,就不重新部署了)

最后出现类似下图的created 就代表open-webui启动成功啦~

最后出现类似下图的created 就代表open-webui启动成功啦~

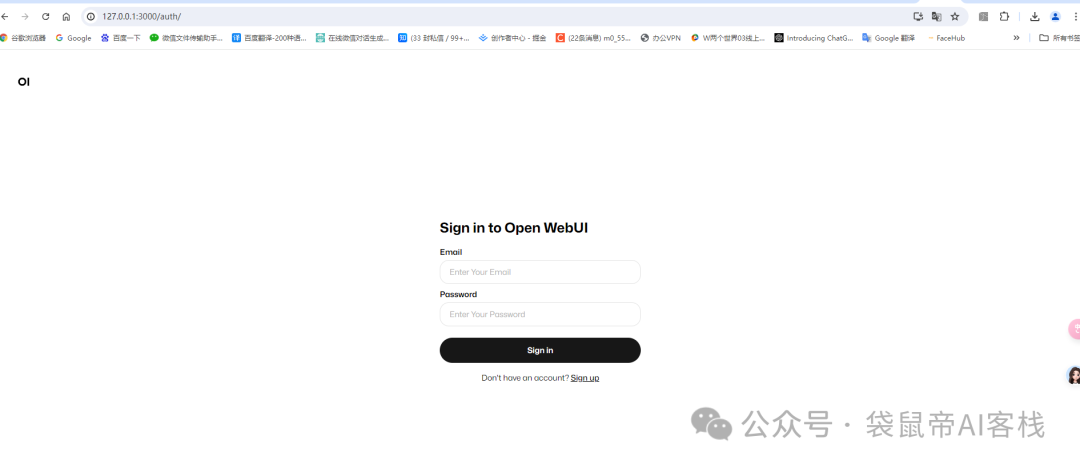

然后打开浏览器,输入127.0.0.1:3000 回车。即可进入open-webui的界面。注册->登录

然后打开浏览器,输入127.0.0.1:3000 回车。即可进入open-webui的界面。注册->登录

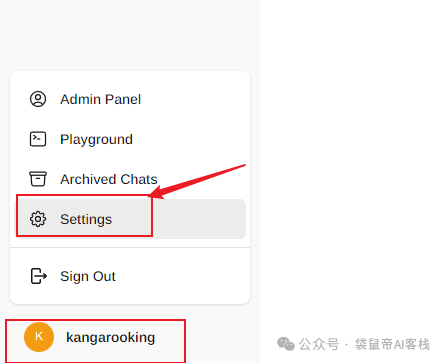

打开左下角设置

打开左下角设置

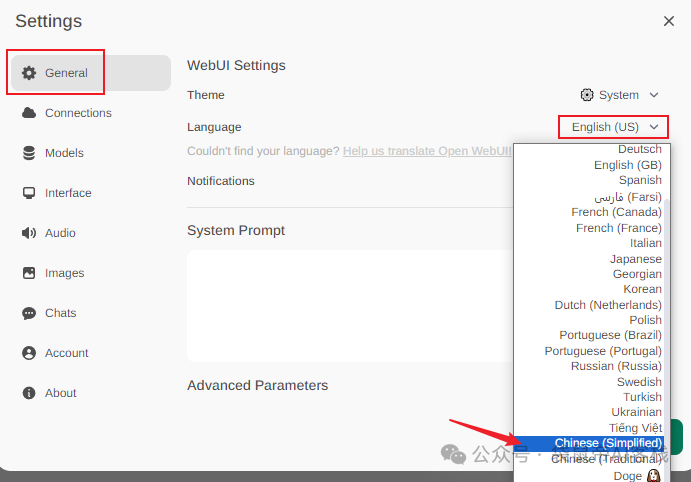

可设置语言为简体中文

可设置语言为简体中文

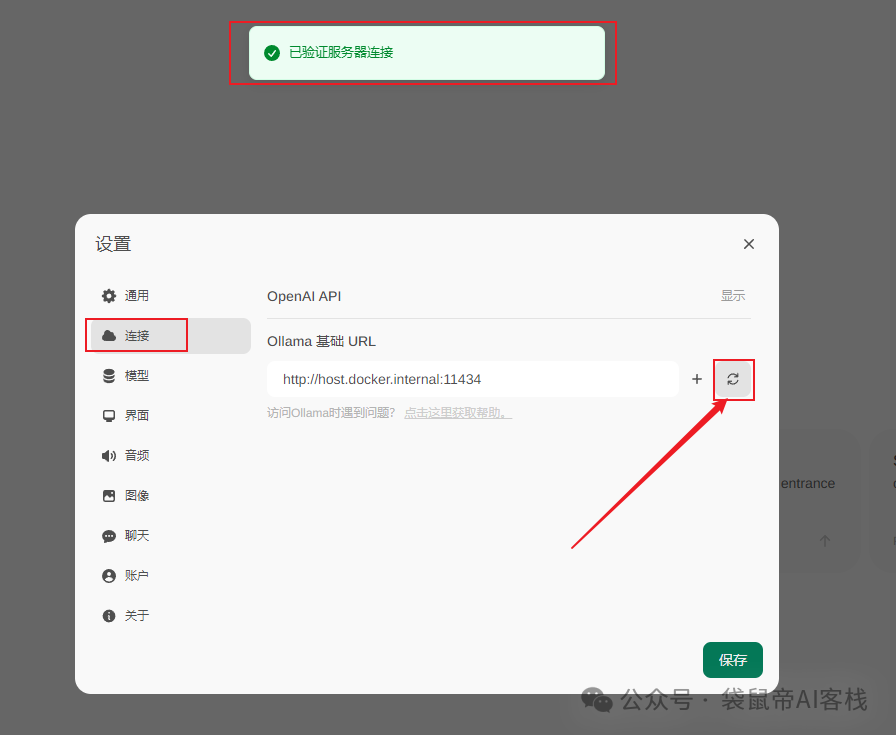

查看open-webui 是否自动检测到了本地的ollama服务 (出现"已验证服务器连接"就代表自动检测到了)。

查看open-webui 是否自动检测到了本地的ollama服务 (出现"已验证服务器连接"就代表自动检测到了)。

在模型一栏,可查看所有可下载的模型(几十种),以及下载模型

在模型一栏,可查看所有可下载的模型(几十种),以及下载模型

三、下载使用开源大模型

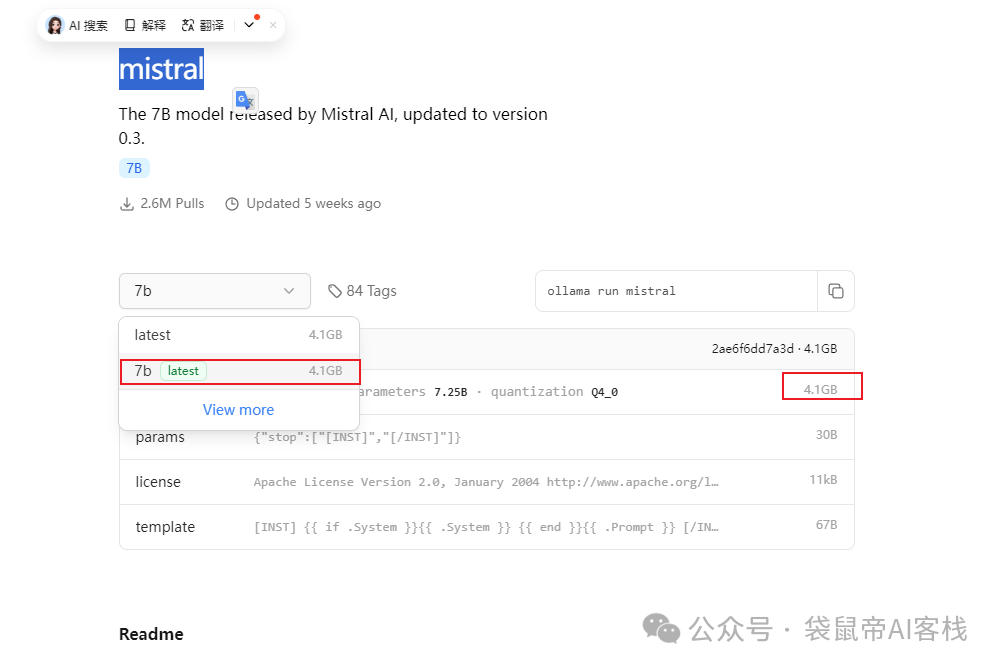

三、下载使用开源大模型 输入模型标签,点击下载按钮即可开始下载模型,我这里以下载mistral:7b 为例,当进度条到100% 就下载完成了(我只花了5分钟左右 就下载完毕了)

输入模型标签,点击下载按钮即可开始下载模型,我这里以下载mistral:7b 为例,当进度条到100% 就下载完成了(我只花了5分钟左右 就下载完毕了)

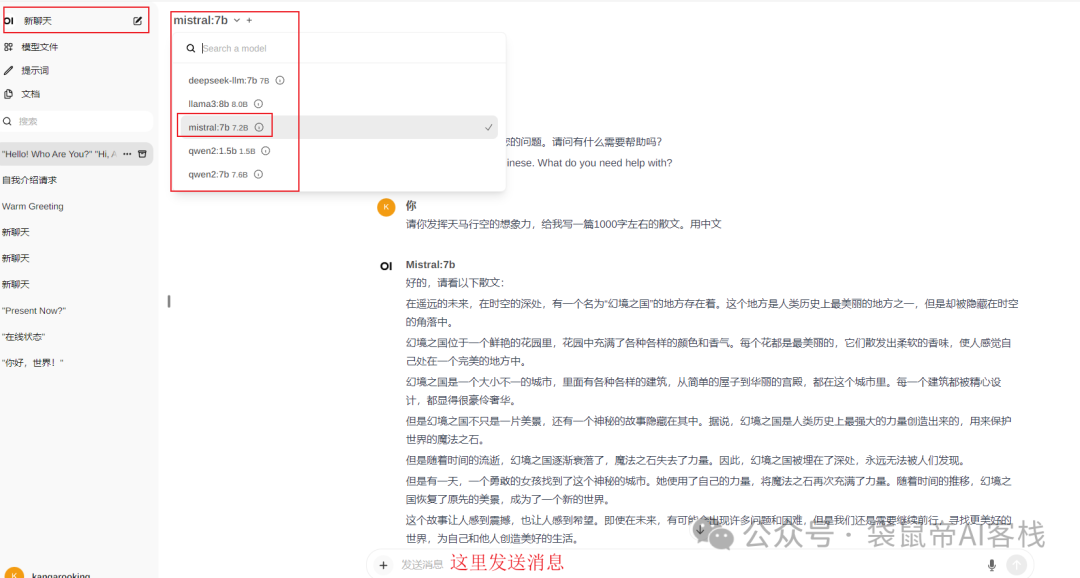

这时就能在模型列表里面选择mistral:7b进行对话 了(本地部署模型回复真的超级快)。

这时就能在模型列表里面选择mistral:7b进行对话 了(本地部署模型回复真的超级快)。

一般7b左右 的模型占用磁盘空间在5G左右 ,mistral:7b是4.1G

一般7b左右 的模型占用磁盘空间在5G左右 ,mistral:7b是4.1G

对于电脑配置来说,运行 7B 至少需要 8GB 内存,运行 13B 至少需要 16GB 内存,运行33b 至少要 32G内存。 好了,到这里我们的ollama + open-webui就搭建完毕啦!

对于电脑配置来说,运行 7B 至少需要 8GB 内存,运行 13B 至少需要 16GB 内存,运行33b 至少要 32G内存。 好了,到这里我们的ollama + open-webui就搭建完毕啦!

大家可以多下载几个模型来试用一下。

后续会更新如何把开源大模型接入个人微信,以及对各个开源大模型进行测评,关注公众号发送:ollama,获取资源包。点关注,不迷路。

以上就是本期所有啦,能看到这里的都是人中龙凤!如果觉得不错,随手点个赞、在看、转发三连吧

如果想第一时间收到推送,也可以给我个星标⭐

谢谢你耐心看完我的文章~  你点的每个好看,我都认真当成了喜欢

你点的每个好看,我都认真当成了喜欢

51工具盒子

51工具盒子